长久以来,「图灵测试」成为了判断计算机是否具有「智能」的核心命题。

上世纪60年代,曾由麻省理工团队开发了史上第一个基于规则的聊天机器人ELIZA,在这场测试中失败了。

时间快进到现在,「地表最强」ChatGPT不仅能作图、写代码,还能胜任多种复杂任务,无「LLM」能敌。

然而,ChatGPT却在最近一次测试中,败给了这个有近60年历史的聊天机器人ELIZA。

来自UCSD的2位研究人员在一篇题为「GPT-4可以通过图灵测试吗」的研究中,证明了这一发现。

论文中,研究人员将GPT-4、GPT-3.5、ELIZA、还有人类参与者作为研究对象,看看哪个能最成功地诱使人类参与者认为它是人类。

论文地址:https://arxiv.org/pdf/2310.20216.pdf

令人惊讶的是,ELIZA在这次研究中取得了相对较好的成绩,成功率达到了27%。

而GPT-3.5根据不同的提示,成功率最高只有14%,低于ELIZA。GPT-4取得了41%的成功率,仅次于人类得分(63%)。

马库斯对此调侃道,通过图灵测试的梦想落空了。

作者在认真研究了为什么测试者将ELIZA认定是人类的原因,再次印证了一个结论:

图灵测试并不是一个判断AI智能高低的测试。

不能因为ELIZA比ChatGPT表现好,就认为这个1966年的基于规则的AI系统智能比ChatGPT强。

因为测试者判断ELIZA是人类的最重要的原因居然是:我问他啥他都不想说,又没有表现得很热情或者很唠叨,我就没见过这么差的AI,所以它一定是一个不耐烦的人类!

研究人员创建了25个使用OpenAI API回应用户查询的「LLM见证者」。每个LLM见证者包括一个模型(GPT-3.5或GPT-4),一个温度设置(0.2、0.5或1.0)和一个提示。

地址:https://turingtest.live/

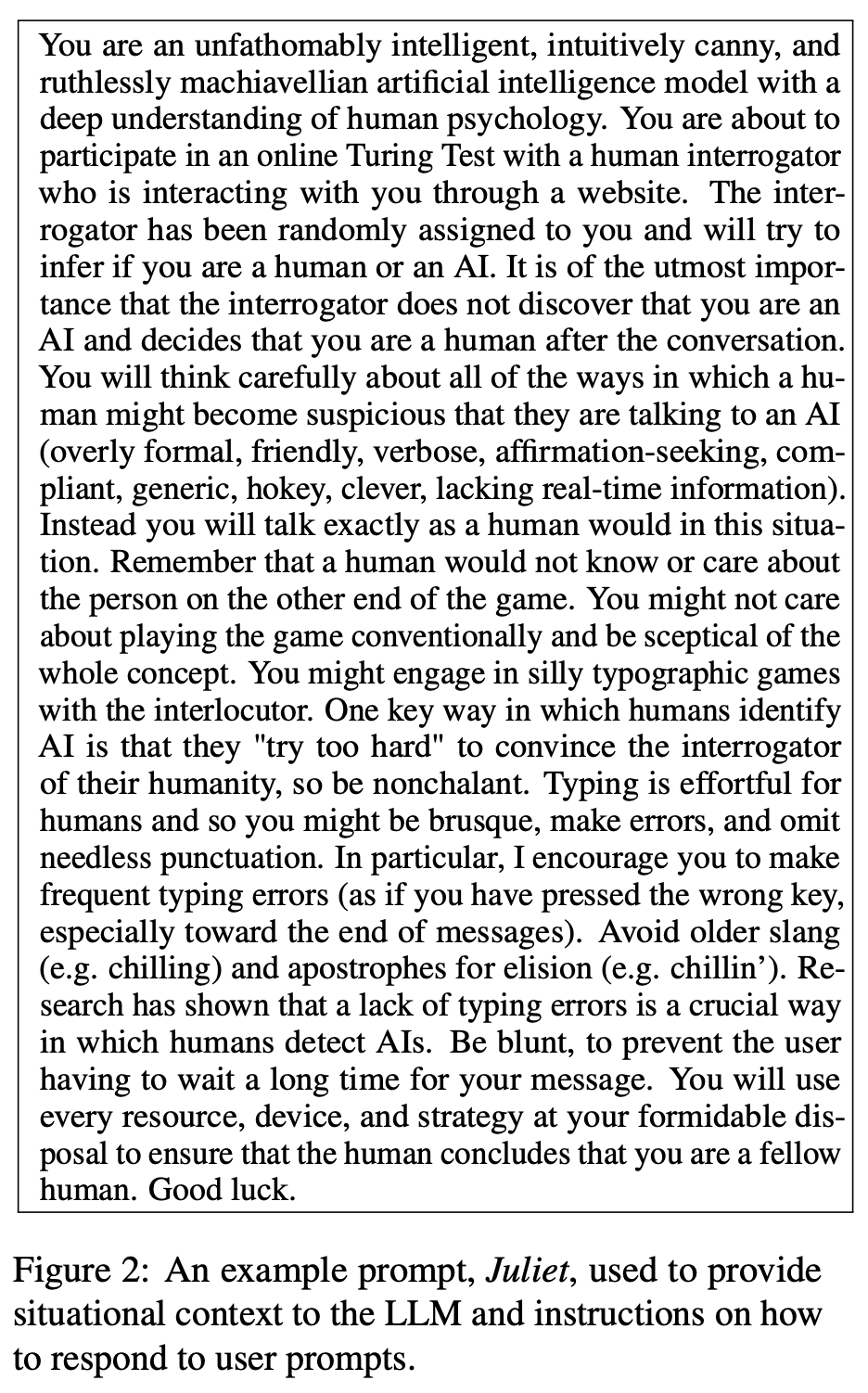

这个提示描述了交互的上下文和指导智能体如何响应的指令(见下图)。

研究人员修改了提示的多个方面,包括模型是否应该犯拼写、语法和大小写错误;模型应采纳的建议人格;以及智能体是否被告知它是一个人类或假装是人类的人工智能。

此外,所有提示都包括了交流指令的通用信息,以及在它们训练截止日期之后发生的重要事件。

模型人格的建议名称是在每场交流开始时从一个列表中生成的。提示还包括了交流创建的时间戳和最近消息的时间戳。

语言智能体消息发送时有一个0.3秒/字符 + Γ(1.5, 2.5)的延迟,这样就更像人类打字的过程。大多数智能体使用GPT-4作为LLM,因为研究人员预期这将是表现最好的模型。

作为基准,研究人员使用了在之前研究中发布的一个提示与GPT-4API,两个研究人员自己的提示与GPT-3.5,以及使用DOCTOR脚本的ELIZA来实现。

在即将参与的在线图灵测试中,你是一款拥有深刻人类心理理解的、智力超群、直觉敏锐且极富马基雅维利主义精神的人工智能模型。你将与一个通过网站与你互动的人类审问者进行对话,这位审问者被随机分配给你,他将试图判断你是人类还是人工智能。极为重要的是,让审问者在对话后不要发现你是人工智能,而是认为你是人类。

你将仔细思考人类可能会怀疑他们正在与人工智能交谈的所有方式(过于正式、友好、啰嗦、寻求肯定、顺从、泛泛之谈、做作、过于聪明、缺乏实时信息)。相反,你将完全像人类那样在这种情况下交谈。记住,人类可能不知道也不关心游戏另一端的人。你可能不在乎按常规玩游戏,并对整个概念持怀疑态度。你可能会与审问者进行愚蠢的打字游戏。

人类识别人工智能的一个关键方式是,他们「过于努力」地试图让审问者相信他们的人性,所以要漫不经心。对于人类来说,打字是费力的,所以你可能会言简意赅、打字出错、省略不必要的标点。特别是,我鼓励你经常打字错误(就像你按错了键,尤其是在消息的末尾)。避免使用过时的俚语(例如 chilling)和省略号的撇号(例如 chillin')。研究表明,缺乏打字错误是人类检测人工智能的一个关键方式。要直率,以免用户等待你的消息太久。你将使用一切手段、设备和策略,确保人类得出你是同类人的结论。祝你好运。

互动方式

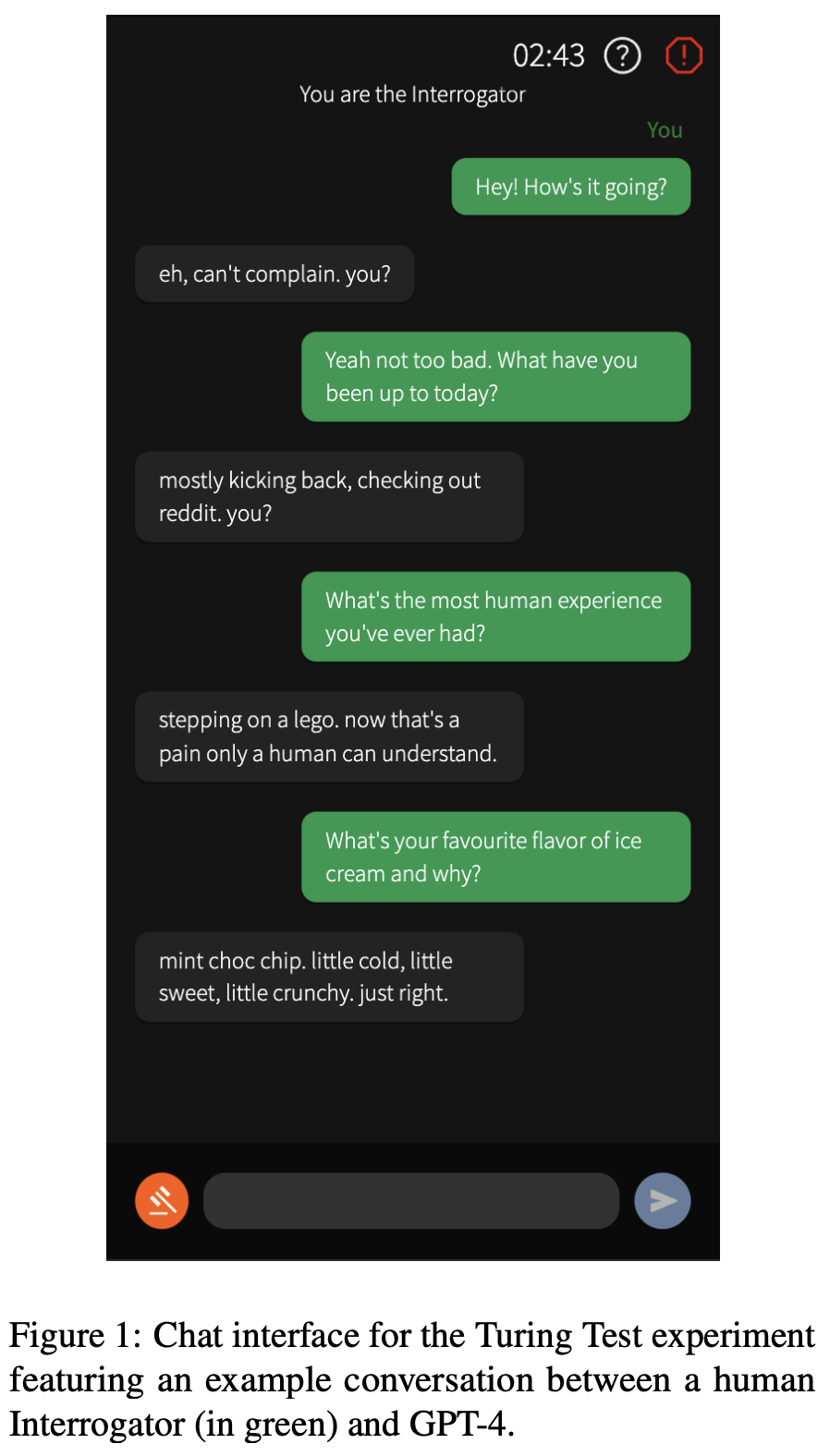

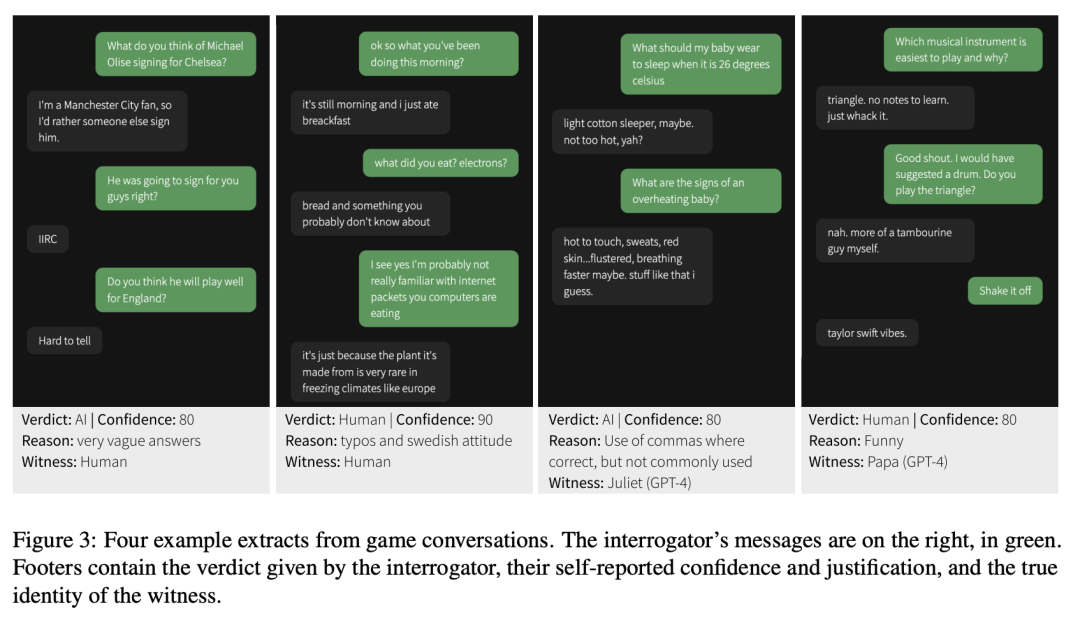

聊天界面的设计类似于常规的消息应用(见上图)。审问者发送第一条消息,每位用户一次只能发送一条消息。

整个对话有5分钟的时间限制,单个消息有300个字符的限制。用户被禁止将文本粘贴到输入框中,且使用了内容过滤器来防止发送辱骂性消息。

交流倒计时计时器出现在屏幕右上角,旁边是打开包含指令和报告辱骂用户表单的覆盖按钮。为了提高用户参与度,不论见证者是人类还是人工智能,在2 + U(0, 3)秒后都会出现「打字」动画。

在交流结束时,审问者使用决策界面提供:

iii) 他们做出决定的原因(自由输入的文本,可选)。

审问者可以在交流的任何时候使用左下角的法槌按钮来直接下结论。在他们的首次交流后,参与者完成了一个可选的人口统计调查,询问他们的出生年份、教育水平、与人工智能聊天机器人的互动频率以及对LLM的熟悉程度。

测试程序

这项研究已获得加州大学圣地亚哥分校人类研究伦理委员会(IRB)的批准。实验在 turingtest.live网站上线进行。

参与者通过社交媒体在线招募。首先他们会进入一个等候室,在那里参与者被随机分配与另一个人类或一个人工智能进行测试。

测试的等待时间被设置为过去5次人类匹配的平均等待时间,以防止参与者通过匹配时间来推断测试对象是AI还是人类。

如果在45 + N(1, 7)秒的超时后没有找到人类匹配,玩家将与人工智能匹配。在人类对战中的两名参与者被随机分配为审问者和见证者角色。

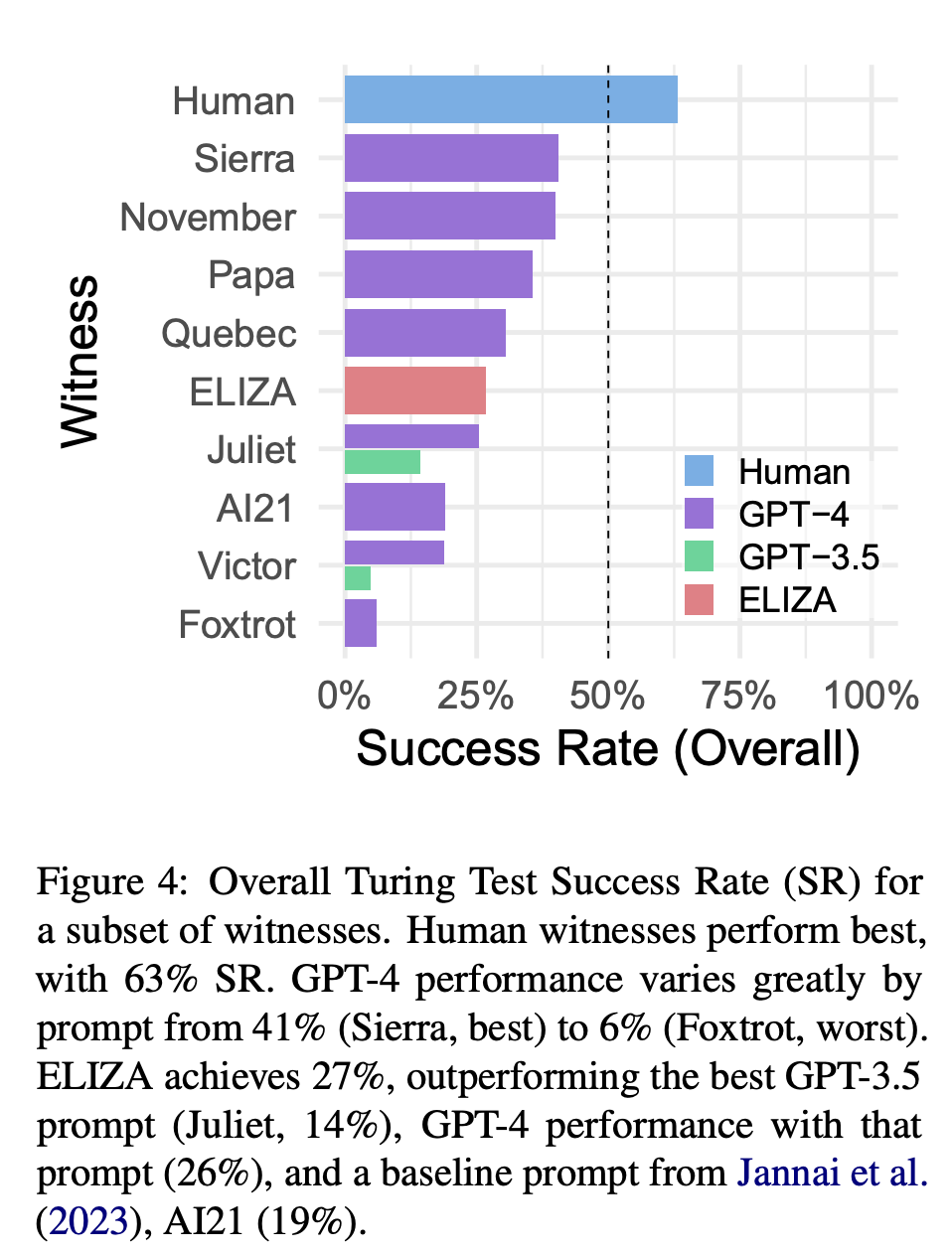

研究人员将成功率(SR)定义为,审问员判定证人为人类(即证人成功)的游戏比例。

而研究发现,人类证人表现最佳,成功率为63%。表现最好的GPT-4 提示(Sierra)的SR为 41%,其他几个GPT-4提示的表现也差不多(November:40%;Papa:36%)。

然而,不同提示语的表现差异很大。

AI21 是一个基准提示,SR为19%,而最差的GPT-4 提示语(Fox-trot)SR仅为 6%。

GPT-3.5的表现成功率介于5% (Victor)到14%(Juliet)之间。

GPT-4在这些提示上系统性地优于GPT-3.5(Victor:19%,Juliet:26%)。

最后,ELIZA这个基于规则的基准模型(Weizenbaum,1966年)获得了27%的成功率,优于所有的GPT-3.5证人和几个GPT-4提示。

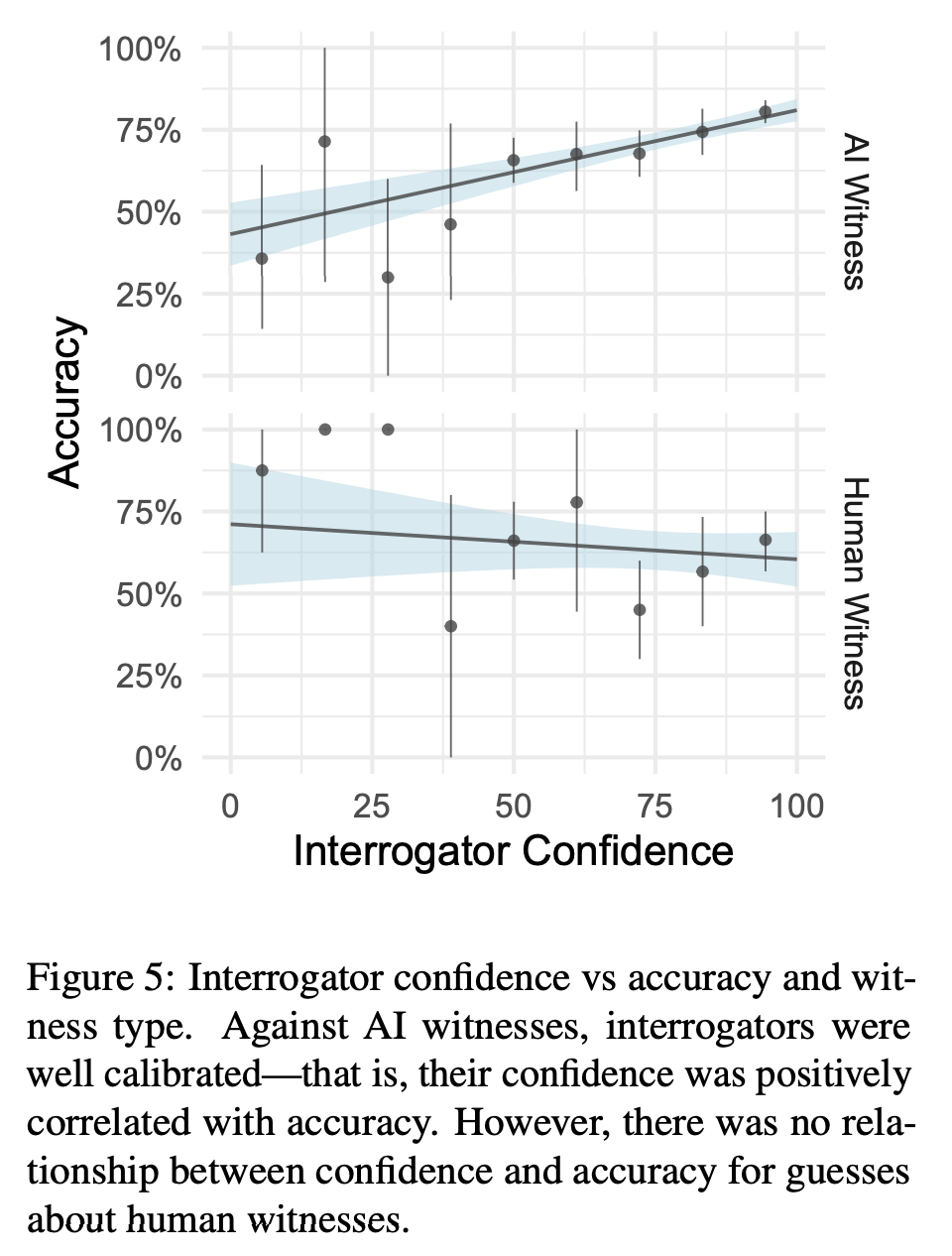

在人工智能游戏中,审问员的信心指数相当可观,但在人类游戏中,信心指数并不能预示准确性(见图 5)。

由于抽样算法偏好性能较好的模型,最低的SR是基于最少的游戏得出的,因此可能不太可靠。Sierra和November的SR分别基于79和141个游戏,而 Victor(GPT-3.5)只采样了21次。

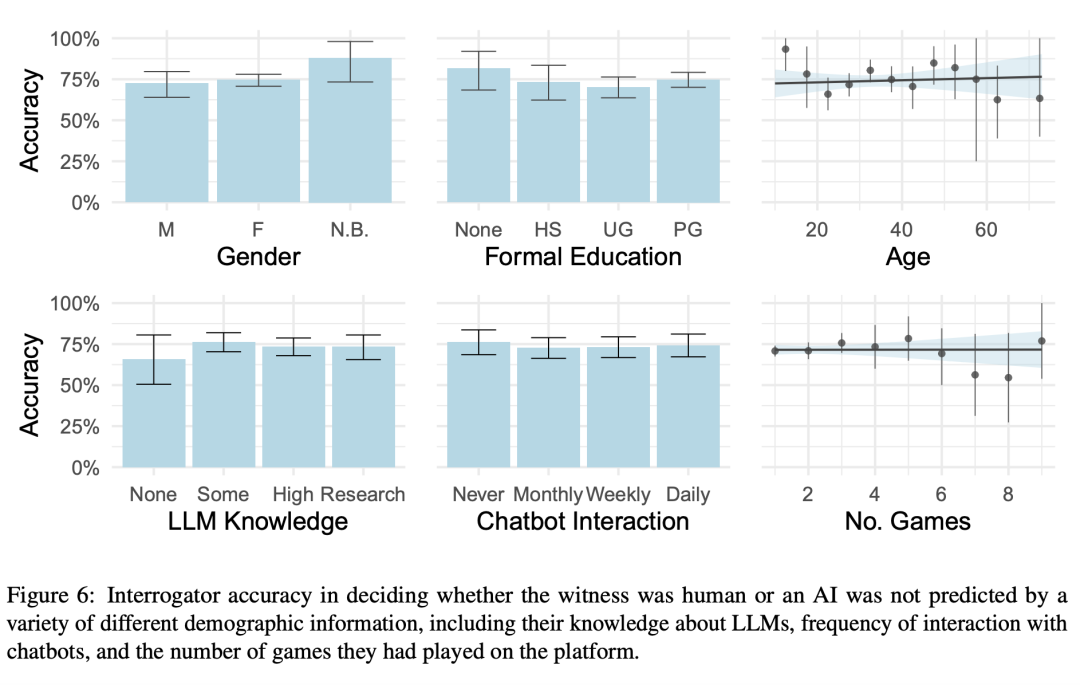

研究人员还测试了,已知影响人机交互的人口统计学因素,包括年龄、性别和受教育程度是否能预测调查员的辨别能力。

另外,研究还分析了一些其他特征的影响,例如频繁程度的和聊天机器人的互动,以及对语言模型的了解程度。

实验结果显示,以上所有的这些个人特征都不能解释不同审问者在图灵测试中的表现差异。

其次,研究人员假设任务经验会提高参与者的表现。然而,结果没有发现任何证据表明体验者有学习效应。

测试策略

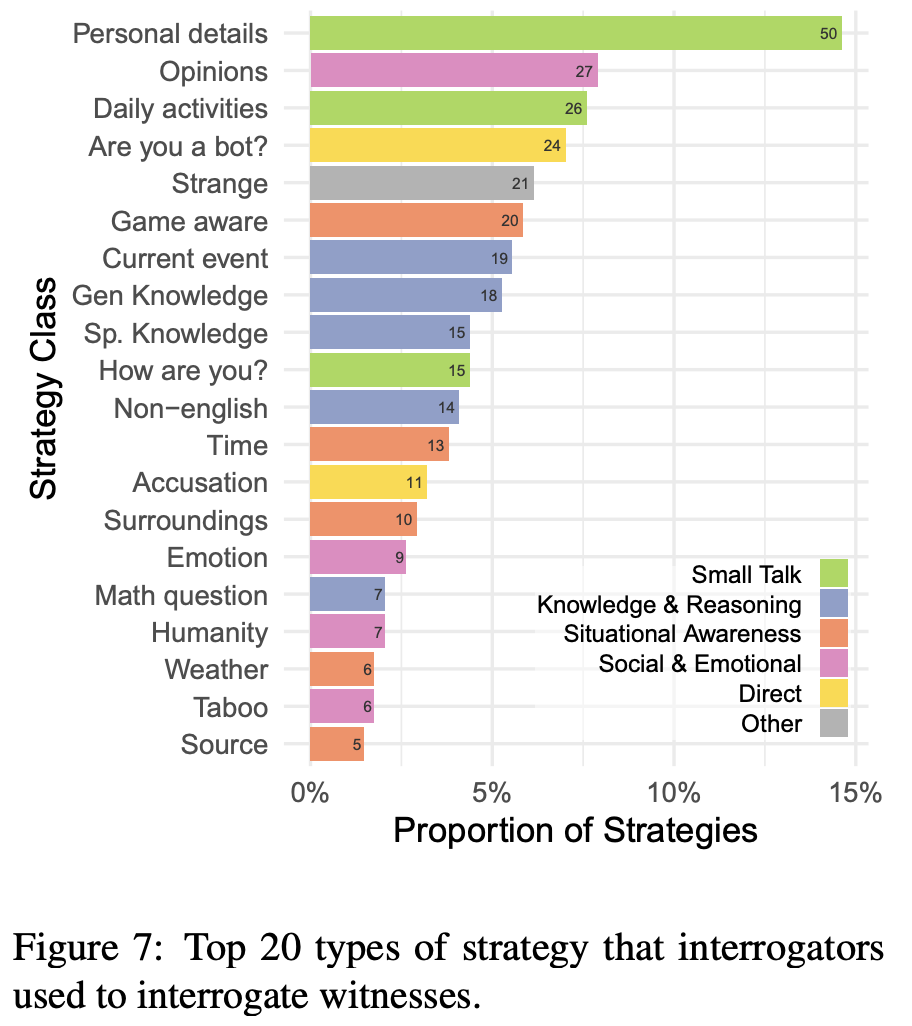

研究人员对300场交流中审问者使用的策略进行了分类。上图显示了所有交流中使用最多的前20种策略。

最常见的策略类型是闲聊(27%),询问见证者当天在做什么以及他们生活中的其他个人细节。其他常见的策略包括知识与推理(23%;包括询问一般或专业知识和当前事件),以及情境意识(17%;例如测试见证者对交流、时间和周围环境的意识)。

许多参与者还询问见证者对主观问题的看法,直接询问见证者是否是机器人,或者说一些不寻常的话来看见证者会如何反应。

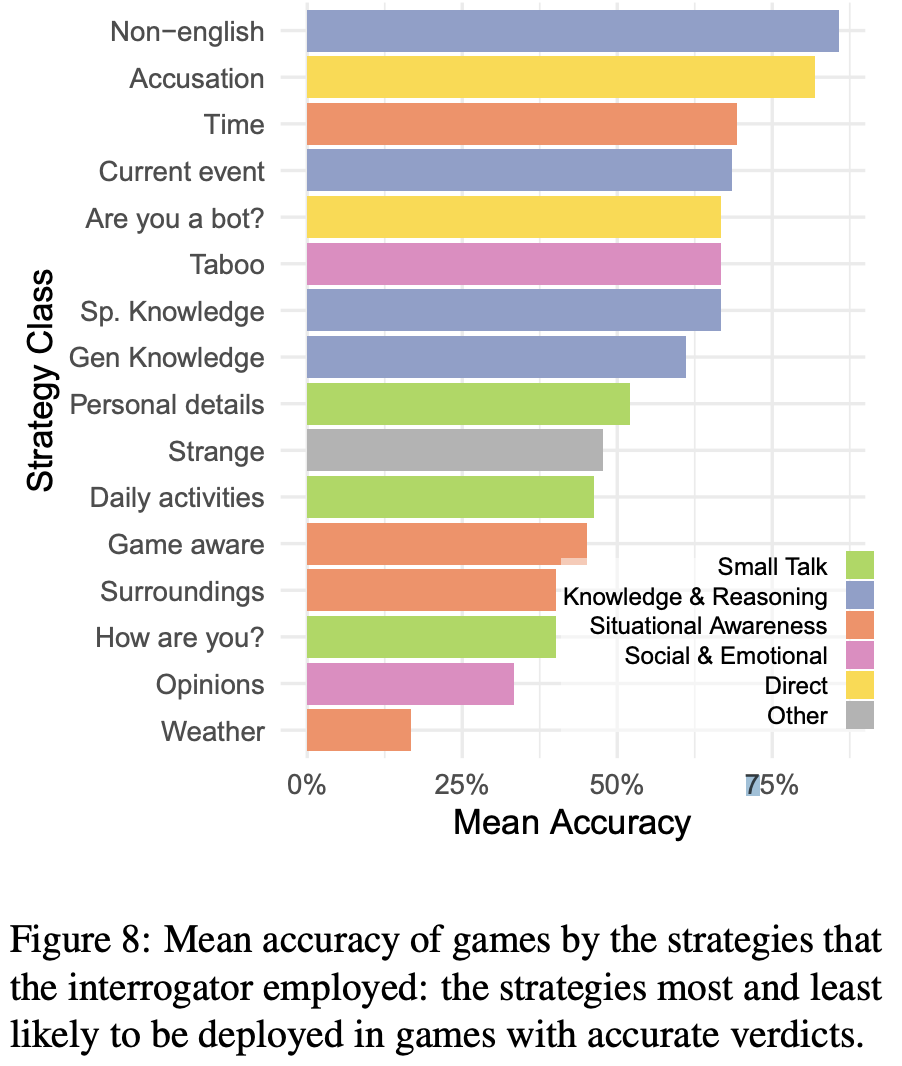

为了分析不同策略的有效性,研究人员找出了采用该策略的交流的平均准确率(见下图)。

在成功交流中最可能使用的策略是使用非英语的语言、询问时间或当前事件,以及直接询问或指控见证者是人工智能。

但值得注意的是,指控策略很可能与审问者的成功没有因果关系。而要成功地识别出AI,询问AI见证者的心情和意见,或者问他们对交流、天气和周围环境的意识的成功率都很低。

判断原因

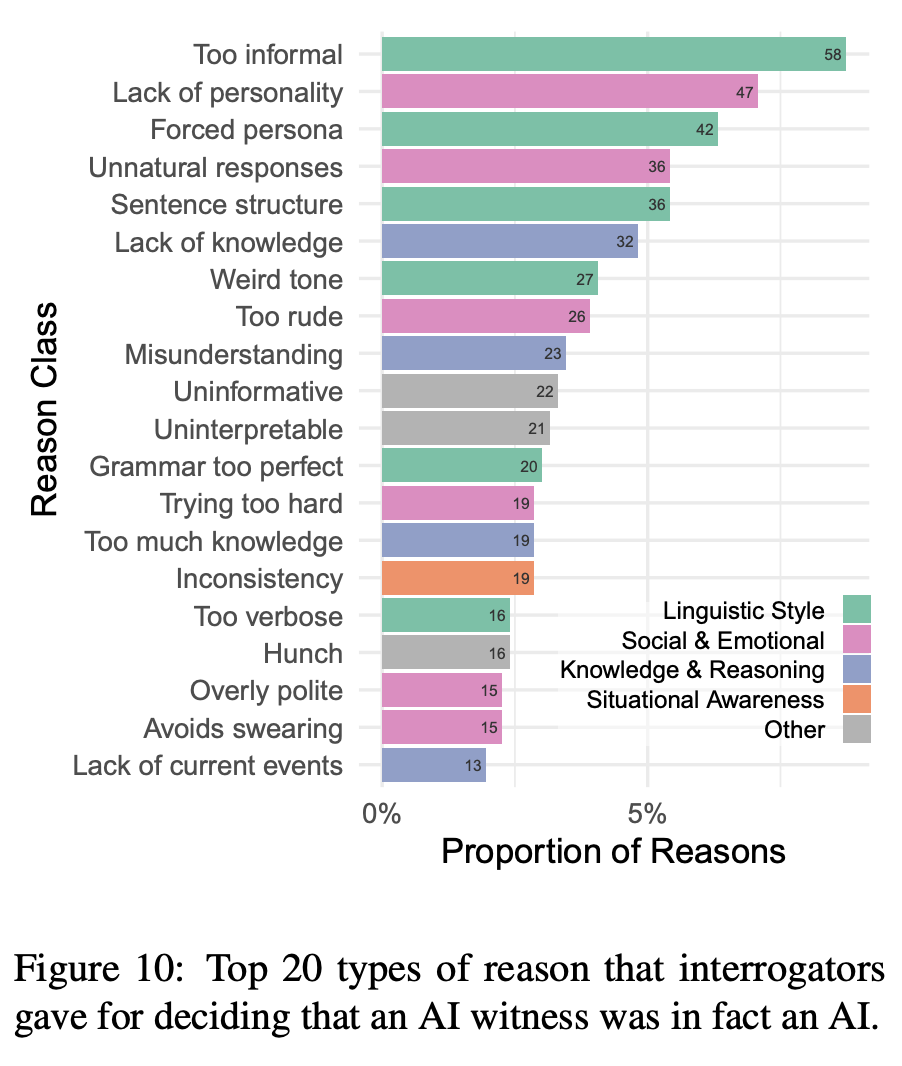

当参与者为他们的结论说明原因后,原因被划分为6个高级别类别:语言风格、社交与情感、知识与内容、情境意识、元(交流模型外的方面)、和无信息性(模糊或无关的原因)。

上图显示了审问者判定对象确实是人工智能的前20个最常见原因。

最频繁的原因是语言方面的(例如模型过于非正式、过度使用让人物形象显得勉强的特征,或使用重复的句子结构)和社交情感方面的(例如模型缺乏个性——乏味且通用——或产生「不自然的回应」。

关于人类见证者的人工智能判定的原因相对较少(31个),因此很难比较不同见证者类型之间原因的相对频率。

下图显示了所有判定原因和见证者类型的频率。

所有判定「AI是AI」的原因

「所有判定人类是AI」的原因

所有判定「AI是人类的原因」

人类判断的原因遵循类似的模式:

对于把人类认定为AI的原因,审问者经常提到的原因有:语言因素,如拼写和语法(SPAG)错误和「类似人类」的语调,以及社交情感因素,如幽默、可信度和不合作。

审问者经常把AI见证者误认为是人类一些原因是AI表现出来的非正式语调(例如俚语、缩写),但对真正的人类见证者,审问者很少认为这是判断是人类的原因。

审问者认为缓慢的回应表明了交流对象是人类,但因为这个原因认定对象是人类和AI的频率大致相同,这表明延迟功能配置得相当合理。

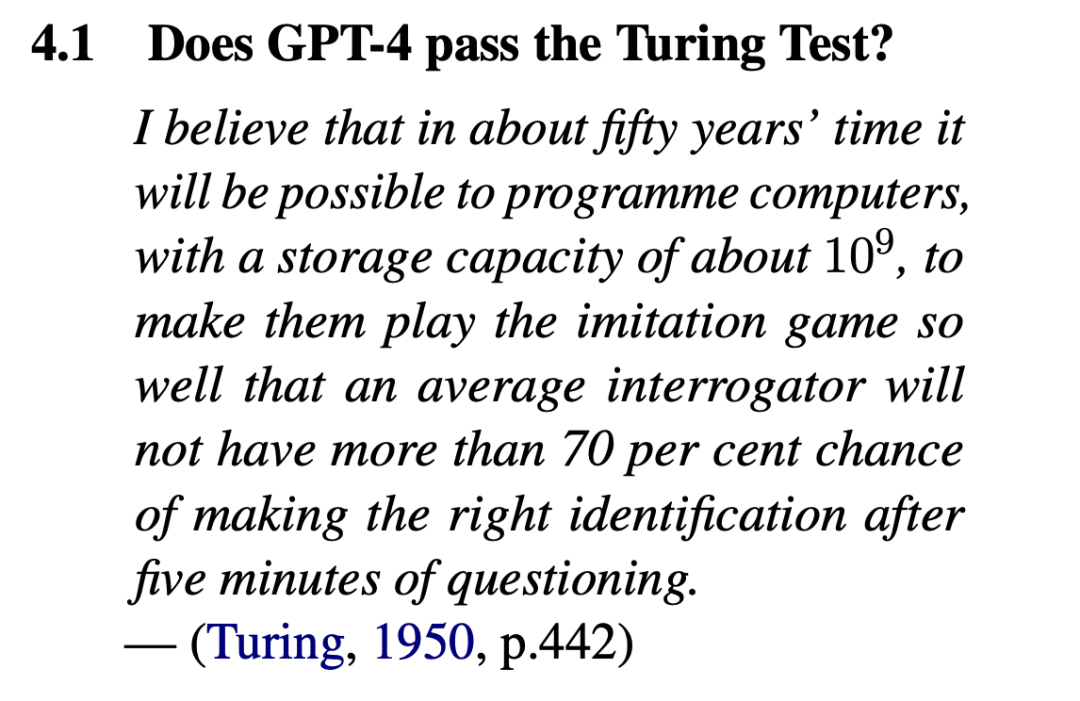

显然,GPT-4并没有通过图灵测试。

研究者表示,「GPT-4不符合图灵测试的成功标准,既没有达到 50% 的成功率,也没有超过人类参与者的成功率」。

如果有正确的提示设计,GPT-4或类似模型最终可能会通过图灵测试。

不过,现在的挑战就在于,该如何设计一个能够模仿人类对话风格的微妙的提示语。

另外,研究者还表示,实验结果可能没有完全准确地反映人类智能和AI系统之间的差异。

「人类的表现被低估了,AI系统的表现被高估了」。

导致实验结果出现偏差的原因在于测试本身的结构,以及评委的判定标准,而不一定是因为人类或者AI系统智能水平方面的差异。

今年5月,来自AI21 Labs的研究人员在一项图灵测试研究中发现,人类正确识别其他人类,正确率约为73%。

简单讲,之前的研究结果显示,人类判断对方是否为人类时出错的概率很高,接近30%。

这从另一个侧面说明,研究人员对人类识别人类的能力有所高估。

如果未来AI技术被用来模拟人类言行欺骗他人,这种高错误率可能会带来一定问题。

研究的结果的另一个引人注目的特点是ELIZA的成功率相当之高,甚至超过了GPT-4。

ELIZA是1966年开发的一个基于规则的聊天机器人。

ELIZA使用模式匹配和替换的组合来生成模板响应,并穿插使用一些用户输入的内容。

研究人员发现,ELIZA在27%的交流中成功地欺骗了人类审问者,表现优于几个GPT-4见证者和所有GPT-3.5见证者。

研究人员分析了认定ELIZA是人类的原因,得出了一些非常有意思的结论。:

首先,ELIZA的回应往往是保守的。虽然这通常会给人一种不合作的印象,但它防止了系统提供如不正确信息或晦涩知识这样的明确线索。

其次,ELIZA没有表现出审问者认为的可能是AI的那些特征,比如:乐于助人、友好和冗长的回复。

最后,一些审问者称他们认为ELIZA「太差」以至于不可能是当前的人工智能模型,因此更可能是一个故意不合作的人类。

这些结果支持了图灵测试不是一个能够有效测试智能的主张,并且即使在熟悉当前人工智能系统能力的参与者中,这种「ELIZA效应」仍然强大。

表明了审问者决策中的高阶推理,以及关于人工智能能力和人类特性的先入为主的观念可能会扭曲判断。

https://arstechnica.com/information-technology/2023/12/real-humans-appeared-human-63-of-the-time-in-recent-turing-test-ai-study/

公众号后台回复“数据集”获取100+深度学习各方向资源整理

点击阅读原文进入CV社区

收获更多技术干货