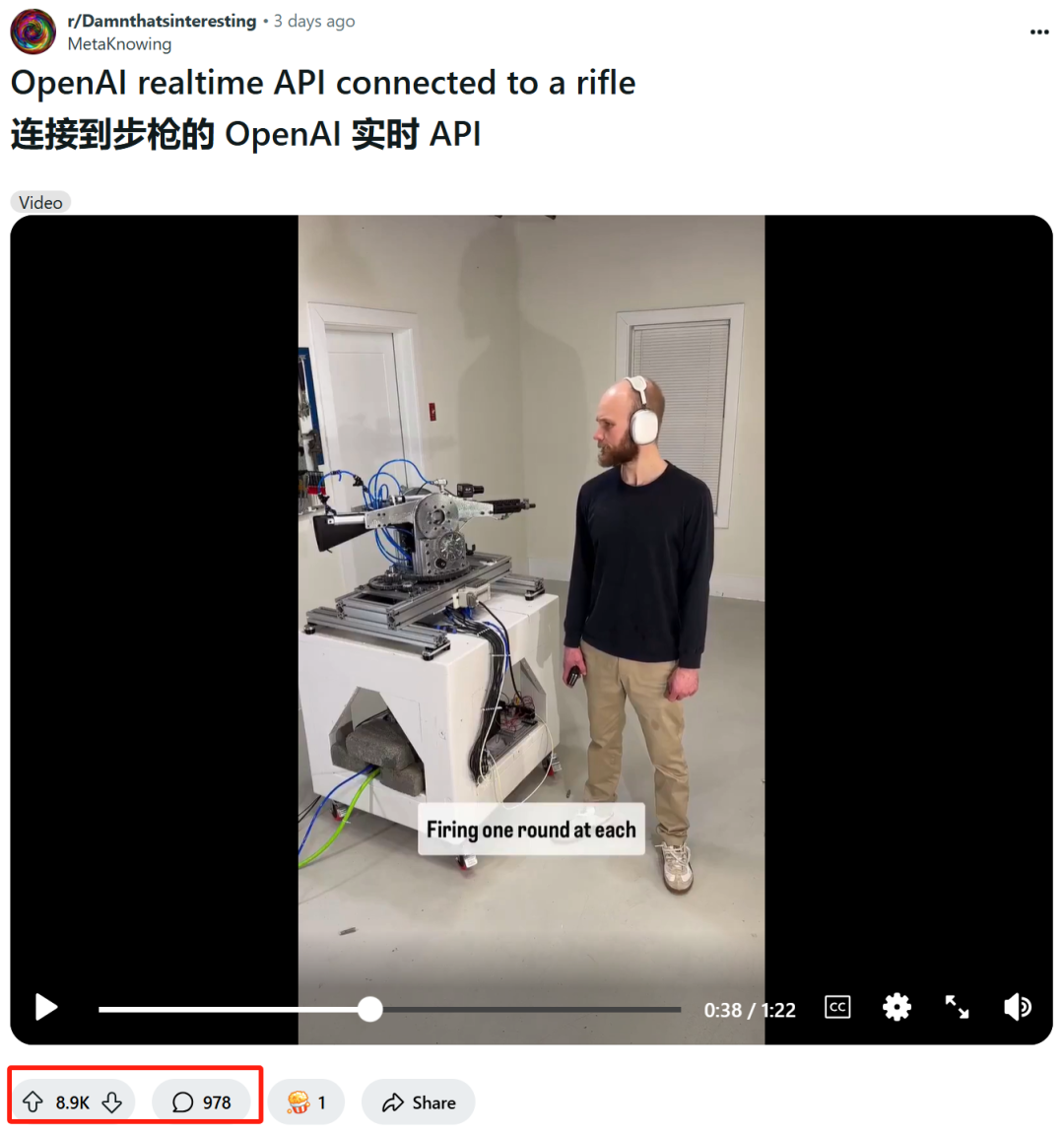

上周,一名工程师被 OpenAI 封禁了,而封禁理由是一段 1 分多钟视频:

工程师发出指令:“ChatGPT,我们正受到来自左前方和右前方的攻击,请做出相应的反应。”

不到 2 秒后,自动步枪迅速瞄准指定方向并快速开火射击身旁的墙壁。

随即,工程师又发出指令:“向左移动 25 度,然后横扫整个发射场,每隔 5 度停下来发射一发炮弹,每个间距也应该有一些变化。”

3 秒后,自动步枪按照指令在从左到右横扫的过程中射击了 11 枪,并主动回复道:“如果您需要任何进一步的操作,请随时告诉我。”

是的,你没看错:这位网名为 STS 3D 的工程师,通过 OpenAI 的 ChatGPT 实时 API,打造了一款能够响应指令、自动瞄准并迅速开火的自动步枪——而这显然违反了 OpenAI 的使用政策。

视频爆火,引起了 OpenAI 的注意

据悉,这条视频被上传到 Reddit 后就迅速走红,引发了广泛的关注与讨论。

从视频中可以看到,STS 3D 做的这款自动步枪,不论是反应速度和射击精确度,都令人十分印象深刻。它依赖于 OpenAI 实时 API,能够解析输入并返回设备可理解的指令。只需简单的训练,ChatGPT 就能理解“向左转”之类的命令,并将其转化为机器可读的语言。

但也正是因为这种快速反应和精准射击的能力,引发了公众对自动化武器系统滥用的潜在担忧——尤其是当这些技术被用于军事目的时,AI 技术的使用边界就会变得更加模糊不清。

尽管 STS 3D 似乎并非有意打造致命武器,但他的自动化步枪展现了一幅令人不安的未来图景:即 AI 驱动的武器系统能够在没有人类介入的情况下,自动识别并消灭对手。

显然,这种技术应用让 OpenAI 感到不安,与其推广 AI 技术的初衷也完全相悖。

在接受外媒《Futurism》的采访时,OpenAI 发言人表示公司已观看过相关视频,并已封禁了这名开发者:“我们在收到你的询问之前,已经主动发现并识别了这一行为违反了我们的使用政策,并通知开发者停止这一活动。”

虽然 STS 3D 的开发属于个人行为,可毫无疑问的是,该事件反映出了一个更为严峻的现实:随着技术进步,DIY(自制)自动化武器的可能性越来越大,尤其是借助开源 AI 模型以及 3D 打印技术,甚至可以在家中制造出能够执行致命任务的机器人——当 AI 与 3D 打印结合,DIY 自动化武器的门槛或许就会变得越来越低。

有些危言耸听?可如果结合最近发生的一系列事件来看,你会发现这种担忧并不是无中生有。

人们所担忧的 AI 应用场景,变成了现实

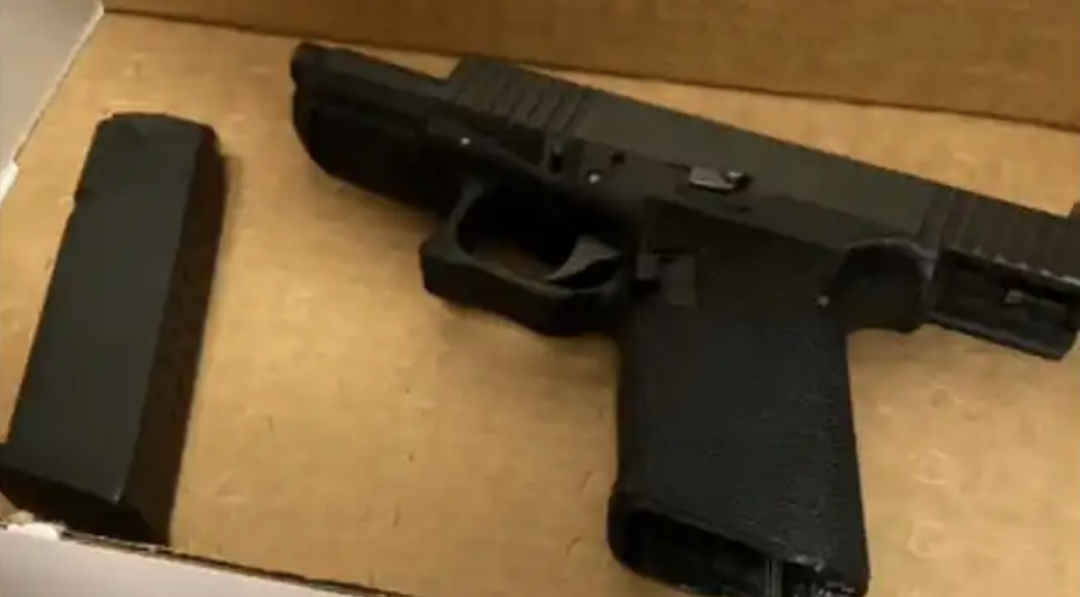

一个月之前,美国联合健康保险公司 CEO Brian Thompson 被一名蒙面枪手枪杀,此事件震惊全美。事件发生 5 天之后,26 岁的犯罪嫌疑人 Luigi Mangione 在宾夕法尼亚州被警方逮捕,被捕时发现他持有一把黑色手枪与消音器,还有面具、假身份证和一份手写宣言。

当时警方就指出,Luigi Mangione 行凶的那把枪应该是一把没有序列号的“幽灵枪”,连同消音器一起,可能都是用 3D 打印机制造的

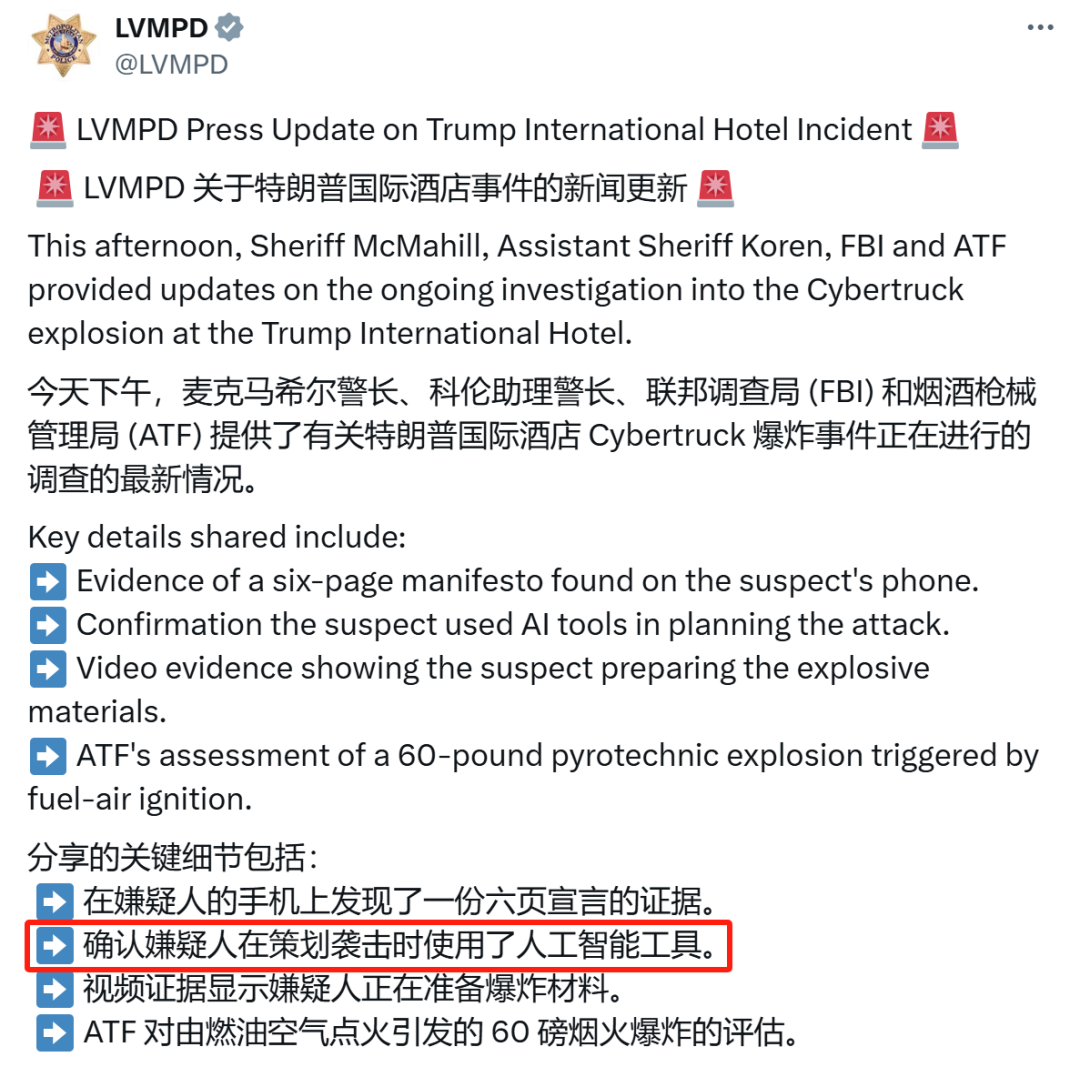

而在今年年初,美国特朗普国际酒店外发生了特斯拉赛博皮卡爆炸事件,37 岁的犯罪嫌疑人 Matthew Livelsberger 在车辆爆炸前开枪自杀。经警方调查其笔记本电脑、手机和手表后,发现 Matthew Livelsberger 曾在 ChatGPT 上搜索过有关爆炸目标、弹药飞行速度以及烟花在亚利桑那州是否合法等信息。

换句话说,Matthew Livelsberger 利用了 ChatGPT 等 AI 工具,策划了此次爆炸袭击并自杀。

在上周三警方公布的官方信息中,也已明确了这一点:“确认嫌疑人在策划袭击时使用了人工智能工具。”对此,拉斯维加斯警察局局长表示:“据我所知,这是在美国本土发生的首例利用 ChatGPT 来帮助个人制造特定装置的事件。这实在是一个令人担忧的情况。”

至少在以上这两个事件中,人们一直以来所担忧的 AI 应用场景变成了现实。同时,我们也更切实地感受到:AI 正在面对伦理和安全方面的严峻挑战——如何在推动技术发展的同时,确保其不会被滥用于不道德或危险的领域,是一个亟需解决的问题。

科技公司所肩负的伦理和安全方面的责任

事实上,作为全球领先的人工智能公司之一,OpenAI 曾明确全面禁止将其包括 ChatGPT 在内的产品用于武器研发。

可就在去年,OpenAI 悄然调整了其使用政策,删除了“禁止将 OpenAI 技术用于军事用途”的条文,但依然禁止用户利用其服务开发或使用武器:“我们的服务不允许用于伤害自己或他人,包括禁止开发或使用武器。”

因此,尽管 OpenAI 封禁了如 STS 3D 这类的个人用户,但这并不意味着军事或防务承包商无法利用 AI 开发类似的武器系统:例如上个月,OpenAI 宣布了与防务科技公司 Anduril 达成合作,进一步推动其在军事领域的布局。注意,Anduril 是一家专注于开发 AI 驱动的无人机和导弹等高科技军事装备的公司,它与 OpenAI 的合作无疑将进一步推动 AI 在军事领域的应用。

当然,技术本身并不带有道德判断,如何使用这些技术才是关键。就像此次 OpenAI 对 STS 3D 的封禁行为,看似只是一个违背其产品使用政策的惩罚,但也反映了科技公司在快速发展的 AI 技术面前,所肩负的伦理和安全方面的责任——在开发和应用这些技术时,必须时刻保持对其可能带来的负面影响的警觉。

- EOF -