最近深度学习可解释“杀”疯了!前脚TPAMI 2024全新框架DIML实现更可解释的深度度量学习,拿下SOTA;后脚Nature正刊上麻省理工提出的可解释的、基于子结构的方法在药物发现领域取得了新的突破!

要知道,深度学习可解释一直都是人工智能领域重点关注的研究主题,不仅在于它可以解决医疗、金融、法律等领域伦理道德问题,在实际应用中,这类可解释性强的模型还可以帮助我们更好地理解模型在不同情况下的表现,从而提高模型的可信度和实用性。

因此这方向在顶会顶刊上热门也属正常,大家想要发论文的话也能找到不少优秀的成果参考,如果有同学不想花时间或者确实不会找,也可以看我已经整理好的10篇深度学习可解释最新paper,开源代码有,希望可以帮到大家~

扫码添加小享,回复“深度可解释”

免费获取全部论文+代码合集

DFU_XAI: a deep learning-based approach to diabetic foot ulcer detection using feature explainability

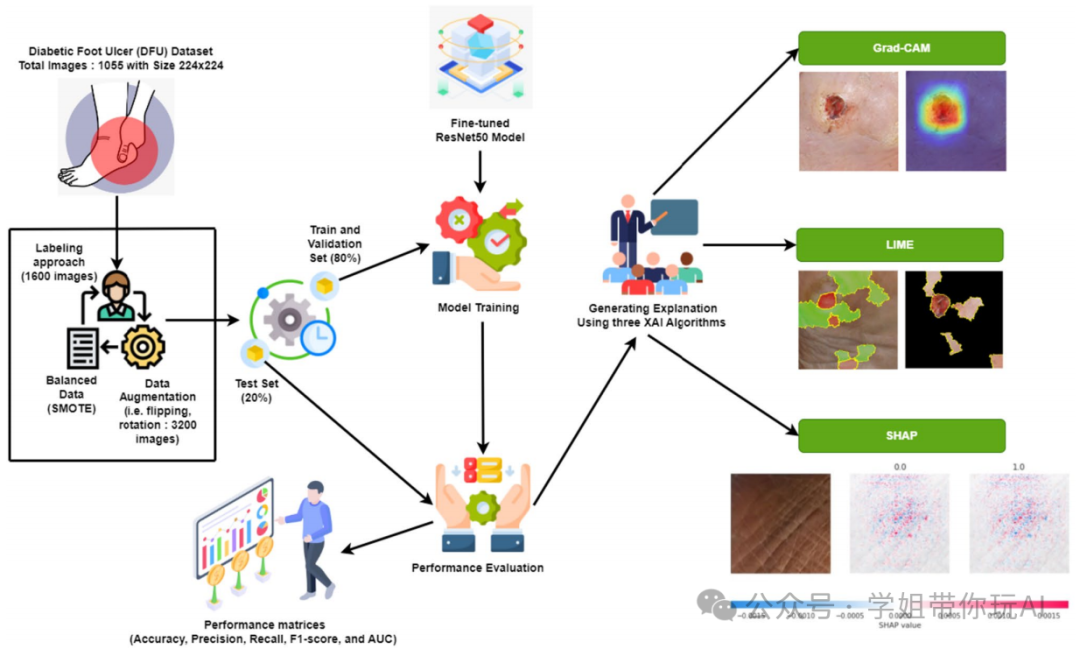

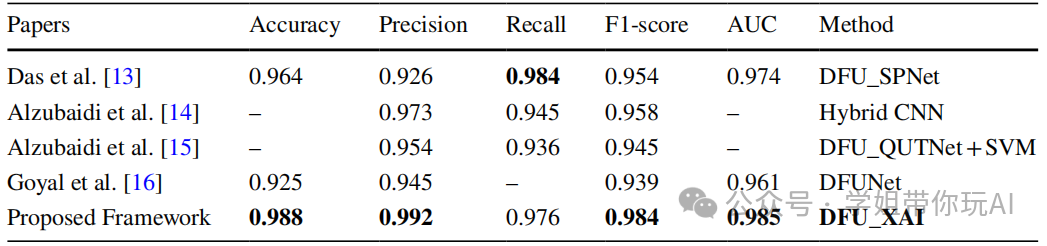

方法:论文提出了一种名为DFU_XAI的可解释深度学习框架,用于糖尿病足溃疡的检测和分类,通过集成XAI算法增强模型的透明度和解释性,以解决现有深度学习模型在临床应用中缺乏可解释性的问题。

创新点:

- 提出了一种定制化的多尺度迁移学习架构,通过结合多个预训练的CNN网络而非单一网络来提高性能。

- 在医疗图像分析领域引入了解释性人工智能(XAI)方法,通过整合XAI算法,使得AI模型的决策过程更加透明和可解释。

- 通过使用微调的ResNet50模型与XAI算法结合,开发了DFU_XAI框架,用于糖尿病足溃疡检测。

Deep Learning Model for Interpretability and Explainability of Aspect-Level Sentiment Analysis Based on Social Media

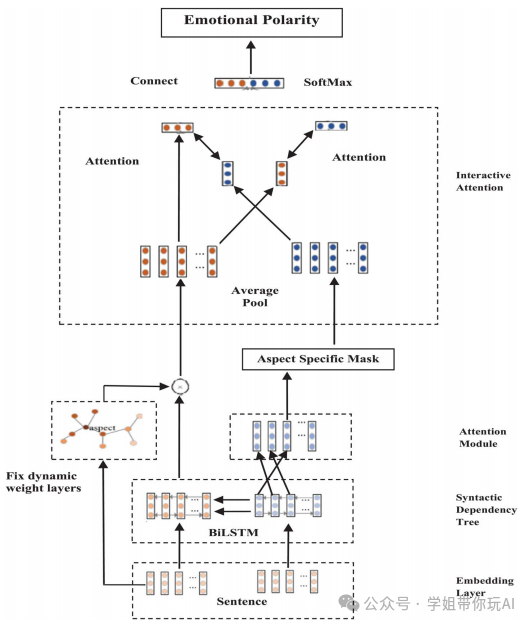

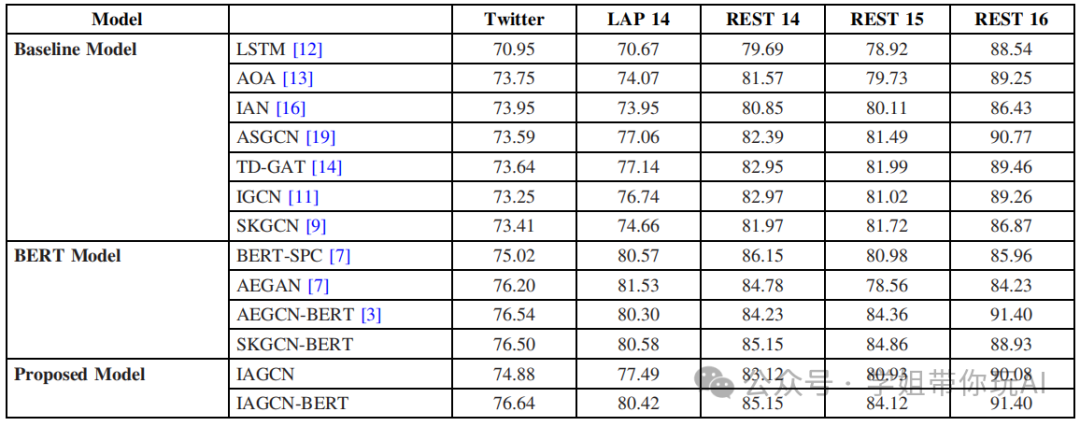

方法:论文讨论了深度学习在方面级情感分析中的可解释性和可解释性问题,提出了一个名为交互注意力图卷积网络(IAGCN)的新型模型,并通过结合交互注意力机制和图卷积网络来捕捉上下文和方面术语之间的复杂关系。

创新点:

- 引入了一种互动注意力技术,能够成功捕捉到方面词与上下文之间的互动关系。

- 将BERT等预训练语言模型整合进来,显著提高了模型的性能。

- 提出了互动注意力图卷积网络(IAGCN)模型,结合了互动注意力机制和图卷积网络的优势。

扫码添加小享,回复“深度可解释”

免费获取全部论文+代码合集

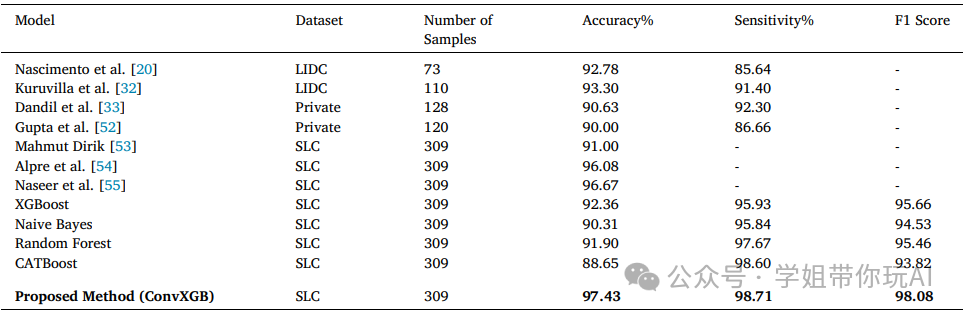

DeepXplainer: An interpretable deep learning based approach for lung cancer detection using explainable artificial intelligence

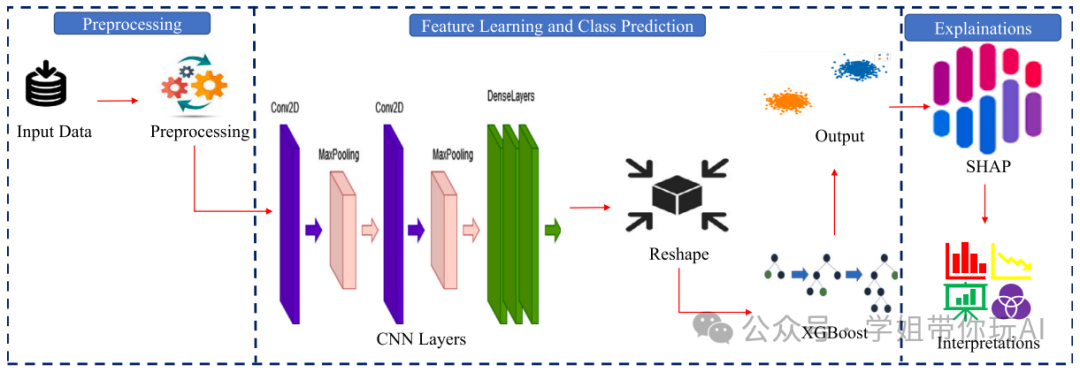

方法:作者开发了“DeepXplainer”,一种结合卷积神经网络(CNN)和XGBoost的可解释深度学习模型。CNN用于特征学习,而XGBoost用于分类,随后使用SHAP方法提供预测解释。

创新点:

- 提出了一种高效的混合模型ConvXGB,将卷积神经网络(CNN)与XGBoost结合用于肺癌检测。

- 使用了一种知名的可解释人工智能(XAI)方法,为医疗从业人员提供解释或解读,以帮助他们做出更好的决策。

Explainable Post hoc Portfolio Management Financial Policy of a Deep Reinforcement Learning agent

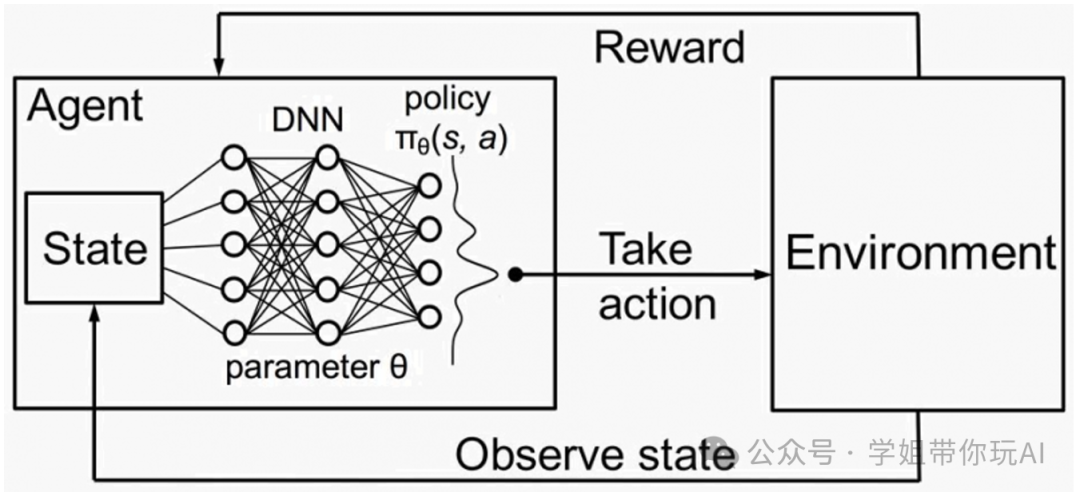

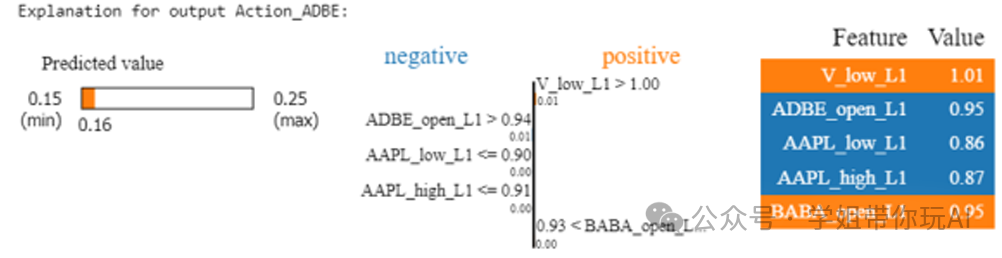

方法:论文通过引入一种新的解释性深度强化学习(XDRL)框架,结合PPO算法和模型无关的解释性方法(如SHAP和LIME),以提高模型透明度和信任度,并为投资者提供更明确的决策依据。

创新点:

- 首次提出了一种解释性的事后投资组合管理策略,应用于深度强化学习(DRL)代理。

- 将解释性技术(如SHAP和LIME)与深度强化学习方法相结合,使DRL模型的决策过程变得透明和可理解。

- 实验展示了在交易期间提取特征重要性的方法,提升了模型决策的可解释性和透明度。

扫码添加小享,回复“深度可解释”

免费获取全部论文+代码合集