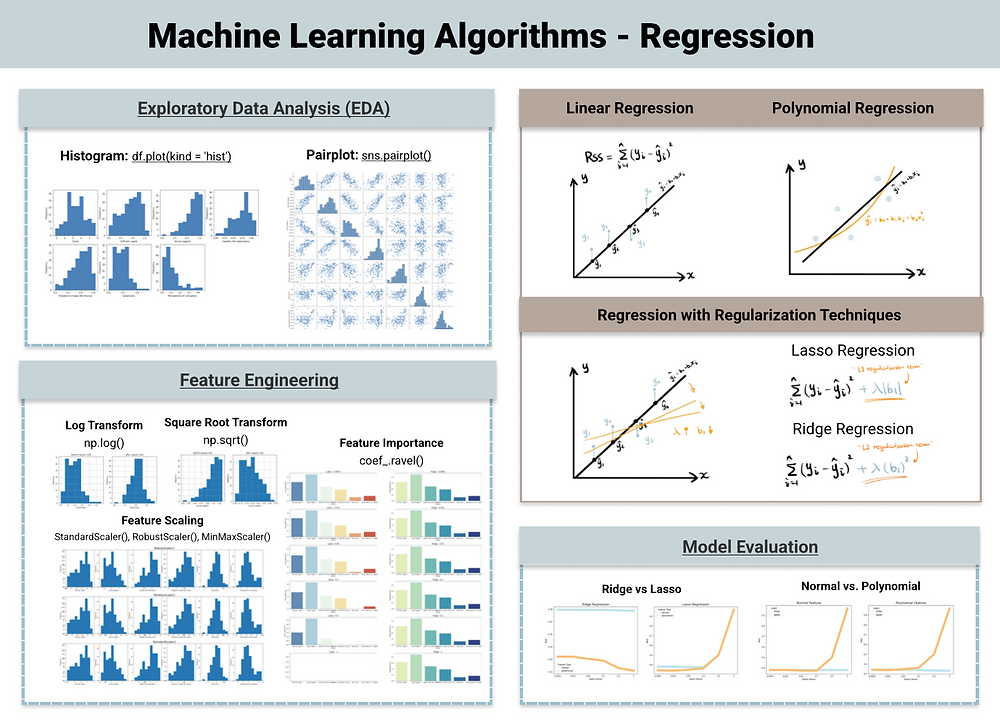

回归(Regression)是机器学习中的一种基本方法,其目标是通过分析自变量与因变量之间的关系,建立一个数学模型来预测因变量的值。

线性回归、多项式回归、正则化线性回归是机器学习中常用的回归分析方法。其中线性回归用直线拟合数据关系,多项式回归用曲线拟合复杂关系,正则化线性回归通过加约束来防止模型过于复杂。

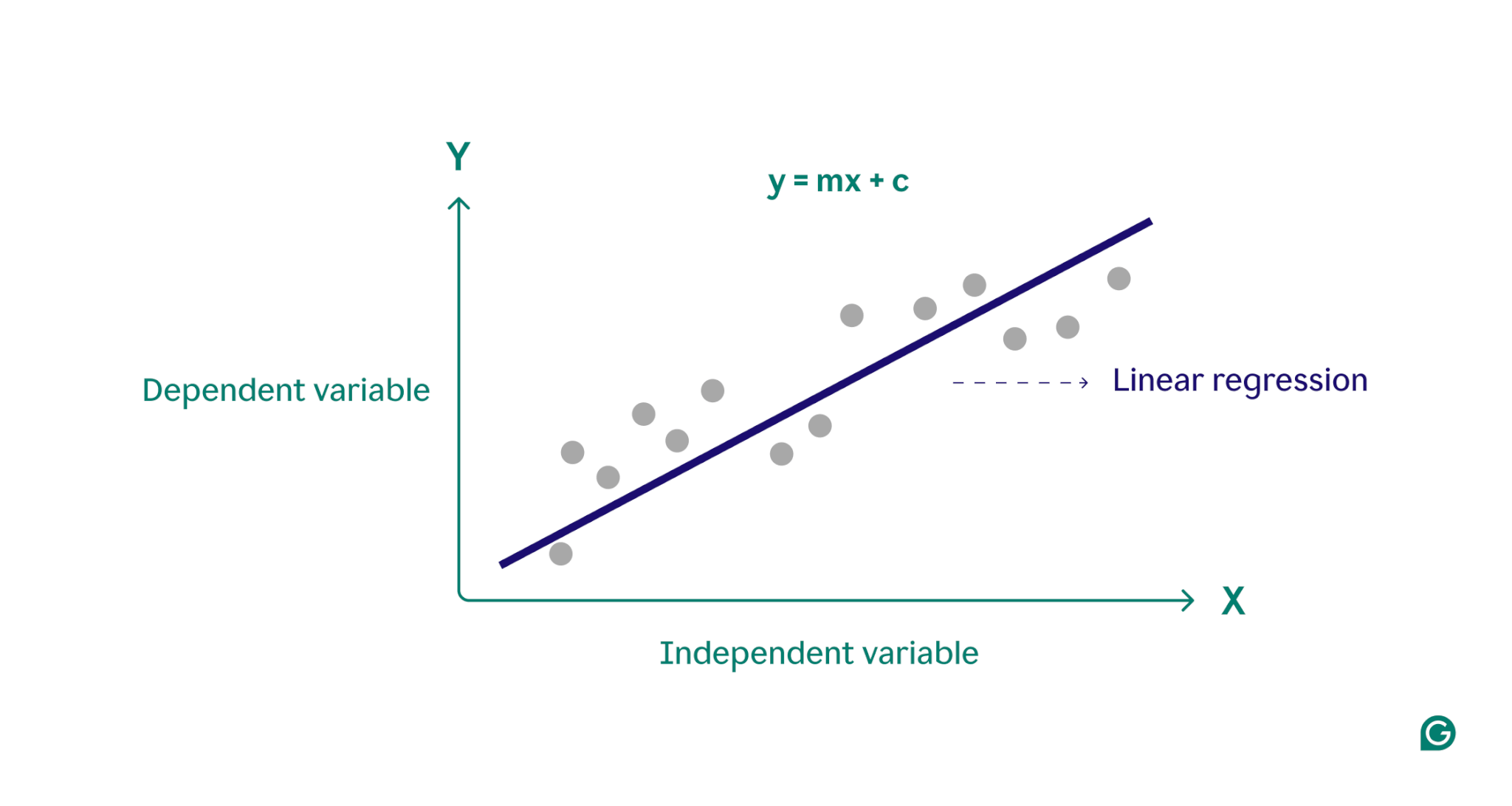

线性回归(Linear Regression)是什么?线性回归是一种统计方法,用于建模两个或多个变量之间的关系。它假设因变量和自变量之间的关系是线性的

,并试图找到最小化误差平方和的最佳拟合直线。

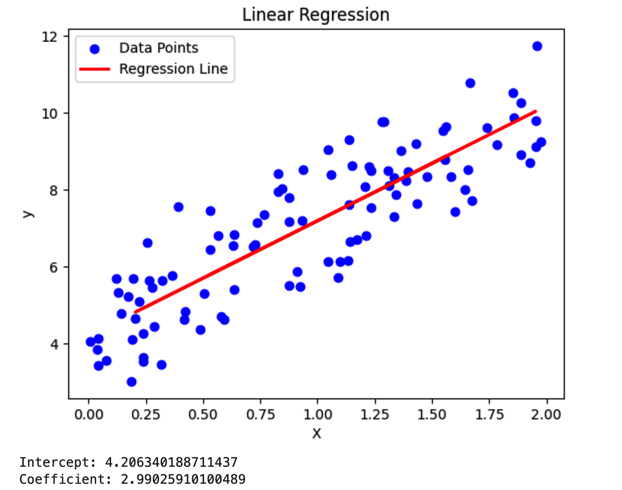

如何实现线性回归模型并进行可视化?在Python中实现一个线性回归模型并进行可视化,可以使用scikit-learn库来拟合模型,并使用matplotlib库来进行可视化。

import numpy as npimport matplotlib.pyplot as pltfrom sklearn.linear_model import LinearRegressionfrom sklearn.model_selection import train_test_split

np.random.seed(0) X = 2 * np.random.rand(100, 1) y = 4 + 3 * X + np.random.randn(100, 1)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

model = LinearRegression()model.fit(X_train, y_train)

y_pred = model.predict(X_test)

plt.scatter(X, y, color='blue', label='Data Points') plt.plot(X_test, y_pred, color='red', linewidth=2, label='Regression Line') plt.xlabel('X')plt.ylabel('y')plt.legend()plt.title('Linear Regression')plt.show()

print(f'Intercept: {model.intercept_[0]}')

print(f'Coefficient: {model.coef_[0][0]}')

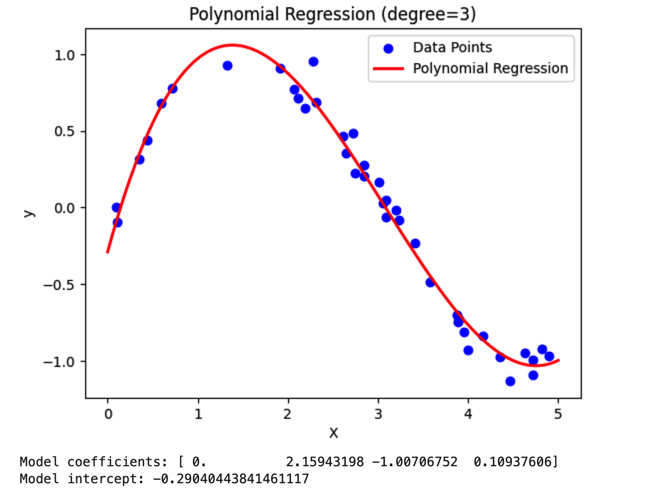

多项式回归(Polynomial Regression)是什么?多项式回归是线性回归的一种推广,它允许因变量和自变量之间存在非线性关系。通过在传统的线性回归模型中增加变量的高次项(如平方项、立方项等),来捕捉数据中的非线性关系。

如何实现多项式回归模型并进行可视化?在Python中实现多项式回归模型并进行可视化,可以使用numpy来生成数据和计算多项式特征,scikit-learn的LinearRegression来拟合模型,以及matplotlib来进行可视化。

import numpy as npimport matplotlib.pyplot as pltfrom sklearn.linear_model import LinearRegressionfrom sklearn.preprocessing import PolynomialFeatures

np.random.seed(0)X = np.sort(5 * np.random.rand(40, 1), axis=0) y = np.sin(X).ravel() + np.random.normal(0, 0.1, X.shape[0])

degree = 3

poly = PolynomialFeatures(degree)X_poly = poly.fit_transform(X)

model = LinearRegression()model.fit(X_poly, y)

X_test = np.linspace(0, 5, 100).reshape(-1, 1) X_test_poly = poly.transform(X_test)y_pred = model.predict(X_test_poly)

plt.scatter(X, y, color='blue', label='Data Points') plt.plot(X_test, y_pred, color='red', linewidth=2, label='Polynomial Regression') plt.xlabel('X')plt.ylabel('y')plt.legend()plt.title(f'Polynomial Regression (degree={degree})')plt.show()

print("Model coefficients:", model.coef_)print("Model intercept:", model.intercept_)

正则化线性回归(Regularized Linear Regression)

是什么?正则化线性回归是一种用于处理线性回归模型过拟合问题的技术。通过在模型的损失函数中引入额外的惩罚项,限制模型参数的大小,从而减少过拟合的风险。

正则化线性回归类型有哪些?岭回归侧重于通过最小化参数平方和来防止模型过拟合,尤其适用于处理共线性问题;Lasso回归则强调稀疏性,通过推动参数变为零来实现特征选择;弹性网络回归结合了岭回归和Lasso回归的特点,平衡了正则化项,既处理过拟合又进行特征选择。如何实现

正则化线性回归模型并进行可视化?在Python中实现正则化线性回归模型并进行可视化,可以使用scikit-learn库来实现岭回归(Ridge Regression)、Lasso回归以及弹性网络回归(Elastic Net Regression),并使用matplotlib库来可视化结果。import numpy as npimport matplotlib.pyplot as pltfrom sklearn.linear_model import Ridge, Lasso, ElasticNetfrom sklearn.preprocessing import StandardScalerfrom sklearn.pipeline import make_pipelinefrom sklearn.model_selection import train_test_split

np.random.seed(0)X = 2 * np.random.rand(100, 1) - 1 y = 4 + 3 * X + np.random.randn(100, 1) * 0.5

scaler = StandardScaler()X_scaled = scaler.fit_transform(X)

X_train, X_test, y_train, y_test = train_test_split(X_scaled, y, test_size=0.2, random_state=42)

alpha = 1.0

ridge = Ridge(alpha=alpha)ridge.fit(X_train, y_train)

lasso = Lasso(alpha=alpha)lasso.fit(X_train, y_train)

elastic_net = ElasticNet(alpha=alpha, l1_ratio=0.5)elastic_net.fit(X_train, y_train)

X_test_scaled = scaler.transform(X_test) y_pred_ridge = ridge.predict(X_test_scaled)y_pred_lasso = lasso.predict(X_test_scaled)y_pred_elastic_net = elastic_net.predict(X_test_scaled)

plt.scatter(X_test, y_test, color='blue', label='Data Points') plt.plot(X_test, y_pred_ridge, color='red', linewidth=2, label='Ridge Regression')

plt.plot(X_test, y_pred_lasso, color='green', linewidth=2, label='Lasso Regression') plt.plot(X_test, y_pred_elastic_net, color='purple', linewidth=2, label='Elastic Net Regression') plt.xlabel('X')plt.ylabel('y')plt.legend()plt.title('Regularized Linear Regression')plt.show()