夕小瑶科技说 原创

夕小瑶科技说 原创

作者 | 小鹿家人们,苹果一直在悄悄进步!

近期,据小鹿观察,各大科技巨头不仅在提升模型解决复杂问题的能力上竞争激烈,而且还在大语言模型应用于用户界面(UI)交互方面上暗暗发力!

最近,Anthropic对其Claude3.5 Sonnet的UI交互功能进行了升级,而微软则推出了开源工具OmniParser,旨在将屏幕内容转换为结构化数据,以便更有效地利用。

能不能一键丝滑地集成这些大语言模型到系统级应用中应该是各大巨头的下一个赛点了!

苹果公司在产品交互上一直都坚持进步,今天小鹿发现苹果做了一个专门理解和与移动用户界面交互的模型Ferret-UI 2,这个模型不仅能“看懂”屏幕上的内容,还能理解用户的指令和问题,从而执行任务或提供信息。

意思是,这个模型用起来后能时刻观察你在手机屏幕上的一举一动,并时刻准备听你召唤提供帮助,执行任务。

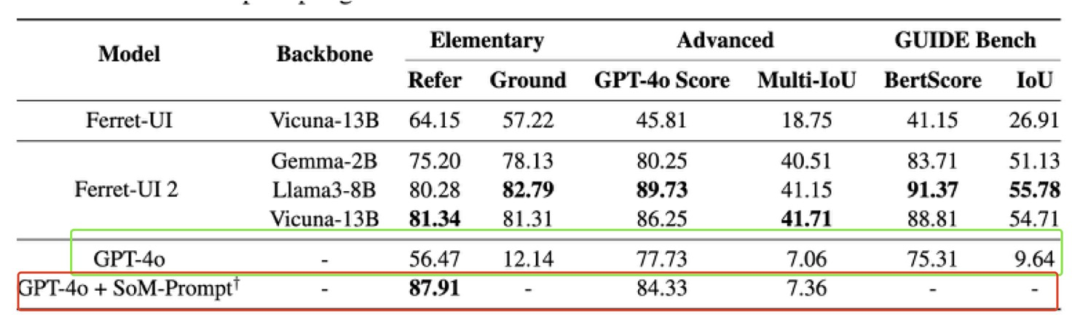

根据官方论文的实验结果,在交互页面上的元素识别、意图识别,其测试得分达到了89.73,显著领先于GPT-4o的77.73分!

创新点

Ferret-UI 2 实现了更准确地识别和理解不同设备和操作系统上的UI元素,从而执行复杂的用户中心交互任务。

主要优势有:

- 多平台、跨设备支持:早期的 Ferret-UI 主要支持移动设备(如 iPhone 和 Android 手机)的UI理解,而 Ferret-UI 2 扩展到了平板(如 iPad)、网页和智能电视(如 Apple TV)等多种平台。其中,在iPhone端基本可以运行流畅,iPad端准确率达68%,安卓设备上的成功率达到71%。

高分辨率自适应:Ferret-UI 2可以适应不同分辨率的屏幕,可以在高清大屏或手机小屏上都保持准确的UI识别效果。无论屏幕大小或清晰度如何,它都能精准识别屏幕上的按钮、图标和文本等元素。

支持更复杂的用户交互任务:Ferret-UI 2 不仅能执行基础点击和操作指令,还能理解更复杂的用户意图。模型能够根据用户的模糊指令做出准确响应。

实现方法

不同于传统的基于坐标点击的操作方式,Ferret-UI 2能够

根据用户的自然语言指令自动定位并执行相应的操作。

研究团队利用了GPT-4V生成训练数据,使得模型不仅能够识别UI元素,还能执行特定的操作,如滑动页面、填写表单和选择选项,提高了系统对界面元素之间空间关系的理解。

论文标题:《Multi-modal|UI Understanding, Multi-round Reasoning SegmentationFerret-UI 2: Mastering Universal User Interface Understanding Across Platforms》

论文链接:http://arxiv.org/abs/2410.18967v1

模型地址:https://huggingface.co/jadechoghari/Ferret-UI-Llama8b

构建数据

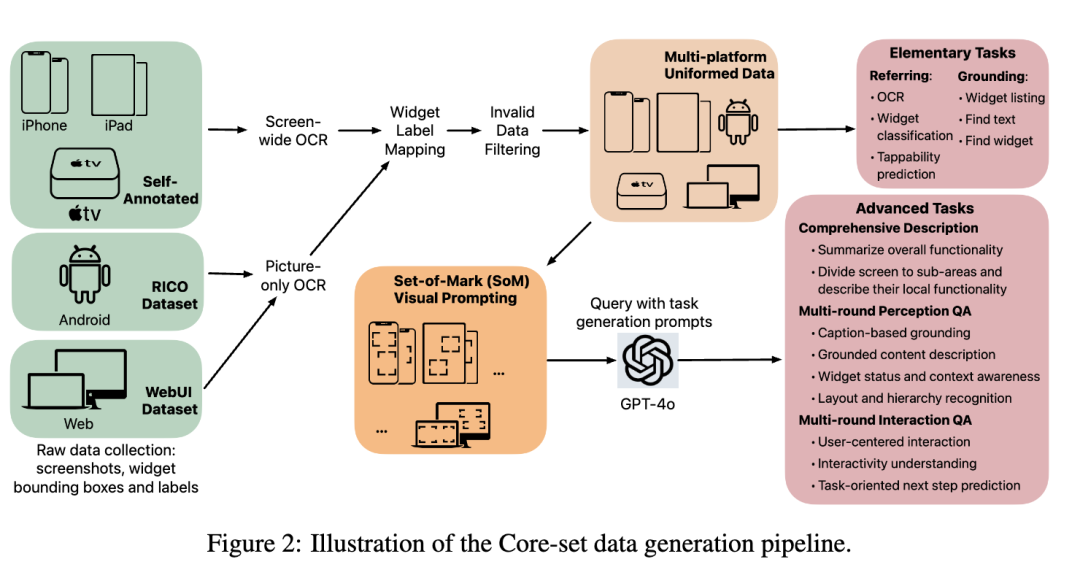

为了训练一个强大的多平台UI理解模型,研究团队构建了自己的数据集,完整的数据集生成流程图如图2所示。

原始注释收集。

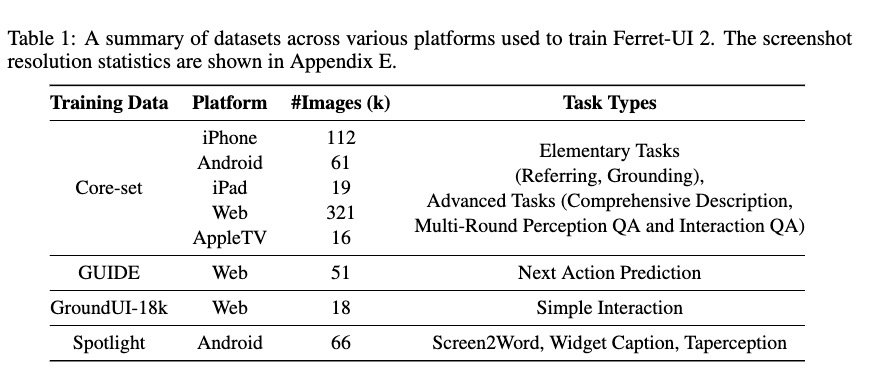

用于训练Ferret-UI 2的数据来自不同平台类型的数据的组合,包括iPhone、Android、iPad、网页和AppleTV等。

研究团队在多种使用场景下收集的iPhone、iPad和AppleTV数据,并人工标注小部件边界框坐标和标签。为了节省标注成本,不收集文本注释,文本边界框被替换为使用OCR置信度阈值为0.5的屏幕范围内OCR检测到的文本和边界框。

网页数据来源于WebUI数据集(Wu等,2023)。所有类型的UI小部件的边界框和非图片小部件的文本注释直接从源HTML视图层次结构树解析,提供高质量的注释。

Android数据的截图、边界框和文本注释是从RICO数据集转换而来的。

研究团队对所有收集的数据进行了筛选处理:

- 筛除或调整超出预设边界的边界框,并在筛选后移除那些不再包含任何边界框的空白截图

尽管数据来自不同的源头,其标签的类型也各不相同,但研究团队剔除了与研究关系不大的标签(如UI类型),并将剩余的标签统一归类到一个共有13个类别的标签体系中,包括:‘复选框’、‘按钮’、‘容器’、‘对话框’、‘图标’、‘页面控制’、‘图片’、‘分段控制’、‘滑块’、‘标签栏’、‘文本’、‘文本字段’和‘切换’,从而得到了一个包含原始UI小部件注释的跨平台统一数据集。

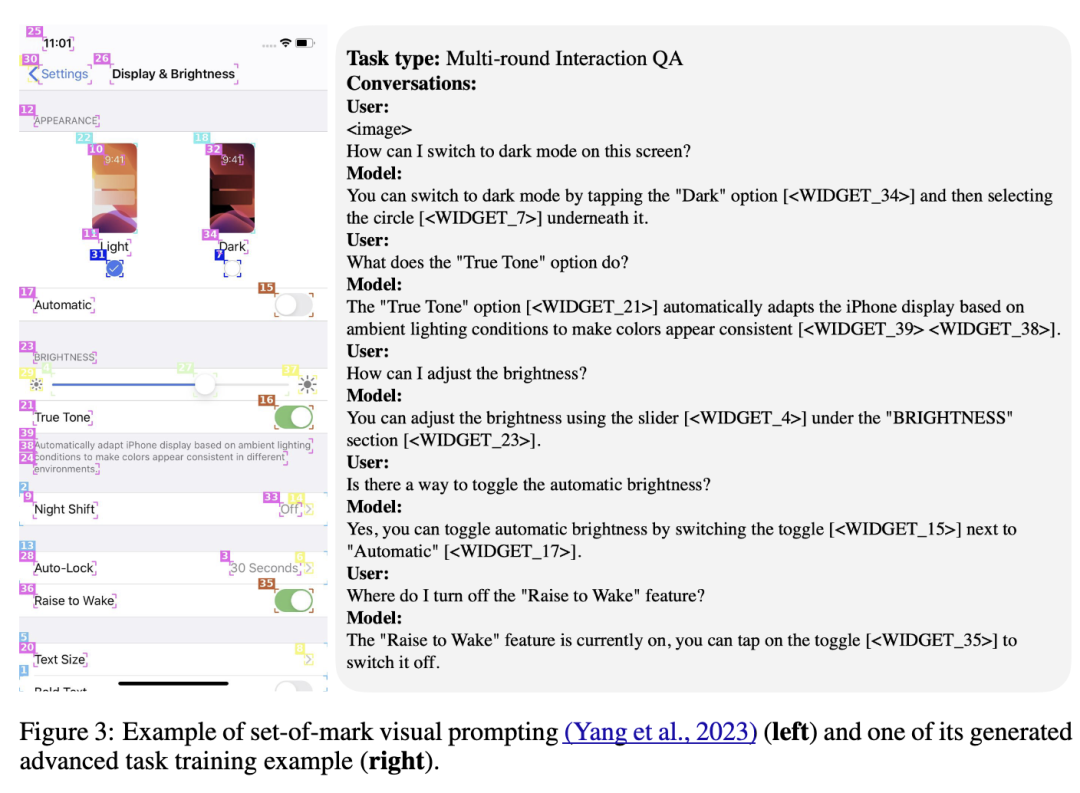

在此方法中,每个UI组件都被标记了角落式边界框和独特的数字标签,以便于识别。

此外,为了更好地区分空间接近或嵌套的组件,同一类的UI组件被标记以相同的颜色,从而增强了视觉提示的效果,帮助模型更有效地识别组件边界。

Ferret-UI2区分了基本和高级任务。

对于基本任务,Ferret-UI2将简单的引用和定位数据转换为对话形式,使模型能够对各种UI屏幕建立基本理解。

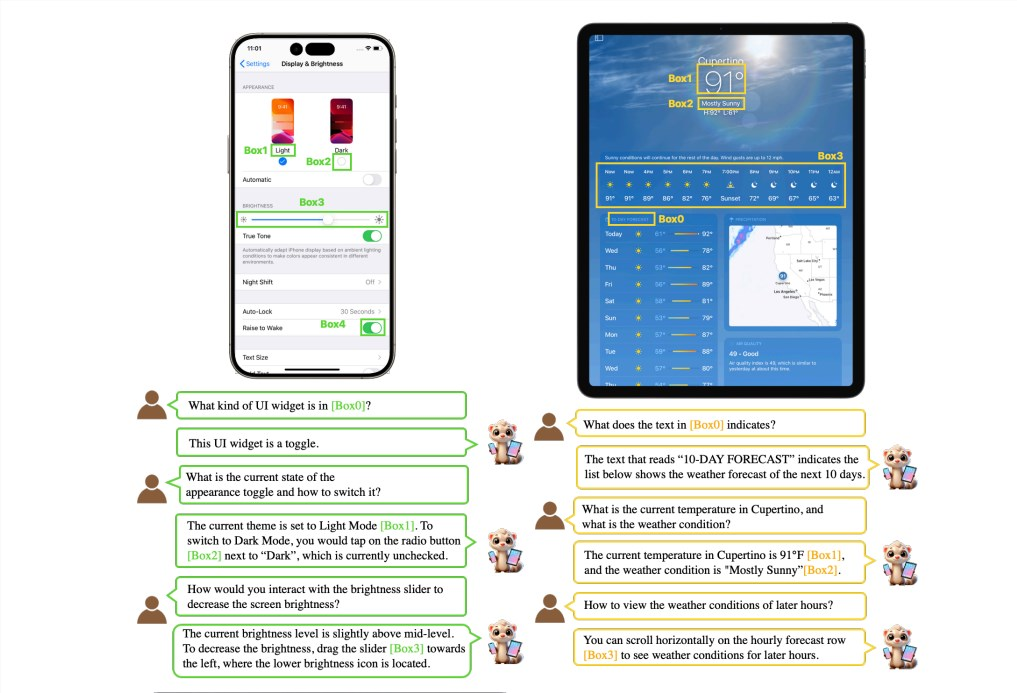

对于更侧重于用户体验的高级任务,Ferret-UI2采用了基于GPT-4o的“标记集视觉提示”技术来生成训练数据,并用单步用户中心交互取代了之前方法中简单的点击指令。在生成多轮感知和交互问答的训练样本时,他们采用了Set-of-Mark(SoM)视觉提示,如图3所示。

模型架构

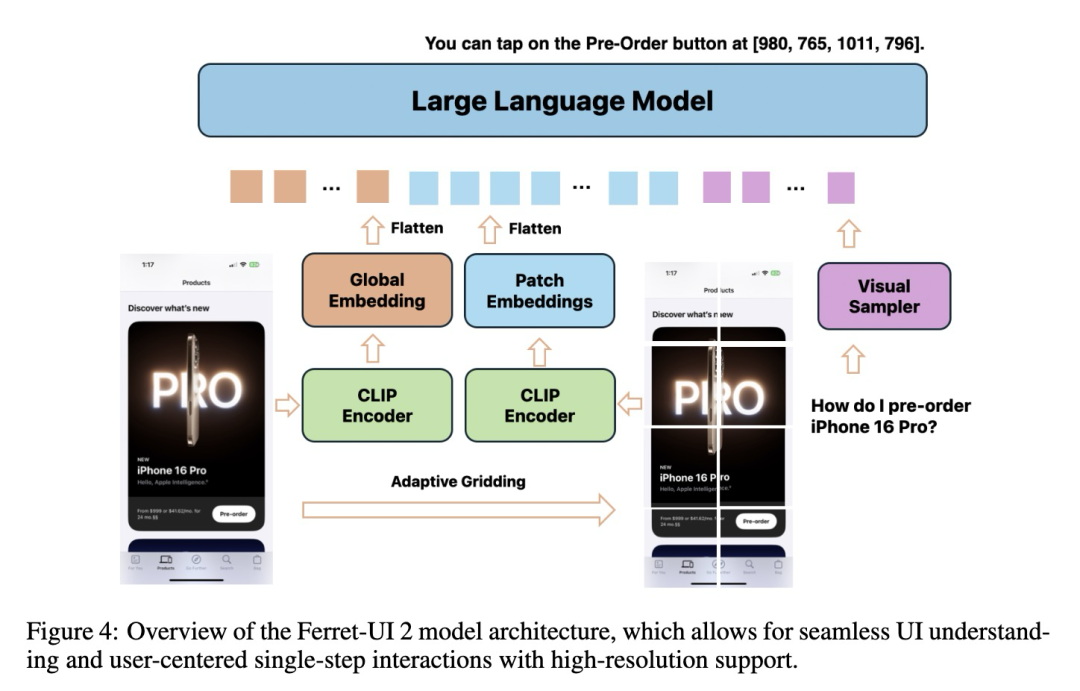

Ferret-UI 2 采用了创新的模型架构,如图4所示。

Ferret-UI 2结合了 Any-Resolution(AnyRes)方法,增强了对指代和定位的处理能力,使编码器能够捕捉不同分辨率下的图像信息。该架构采用了自适应 N 网格机制,基于算法动态确定最优网格大小,以最小的分辨率失真和像素变化对屏幕截图的每个区域进行编码。

动态高分辨率图像编码模块利用 CLIP 图像编码器提取全局和局部特征,将这些特征送入大型语言模型(LLM),实现对高分辨率图像的编码。视觉采样器能够根据用户指令识别和选择相关的 UI 区域,输出对 UI 元素的感知或交互描述。

在生成训练数据时,Ferret-UI 2 使用 Set-of-Marks(SoM)视觉提示,增强了模型对 UI 元素空间关系的理解能力。型通过端到端的训练过程,直接从原始数据注释中学习,生成高质量的训练数据,并优化模型性能。

实验结果

为了评估Ferret-UI2的性能,研究团队构建了涵盖五个平台的45个基准测试,包括每个平台的6个基本任务和3个高级任务。结果表明,Ferret-UI 2在各类任务中的表现均优于Ferret-UI和GPT-4o,尤其是在用户指向和定位任务中,其准确率显著提高,远远超过了GPT-4o。

结语

Ferret-UI 2改善了跨不同平台的用户界面(UI)理解和交互,支持多平台,具有高分辨率图像编码和自适应网格化功能,并且改进了数据生成。

大语言模型在人机交互中的体验优化确实是非常重要的!

随着技术的不断进步,人工智能系统正在朝着更加智能、自然和无缝的交互方向发展。现代应用程序已经扩展到多模态交互,包括视觉和语音识别,使用户界面能够更全面地理解用户的多维度需求。而像Ferret-UI这样的工作,就是在多模态交互的基础上,将大语言模型与设备无缝缝合,为自然语言、人类语音等原始交互信号无障碍驱动设备提供技术基础~