显存占用和GPU利用率是两个不一样的东西,显卡是由GPU计算单元和显存等组成的,显存和GPU的关系有点类似于内存和CPU的关系。显存可以看成是空间,类似于内存。GPU计算单元类似于CPU中的核,用来进行数值计算。

深度学习最吃硬件,耗资源,在本文,我将来科普一下在深度学习中:

何为“资源”

不同操作都耗费什么资源

如何充分的利用有限的资源

如何合理选择显卡

并纠正几个误区:

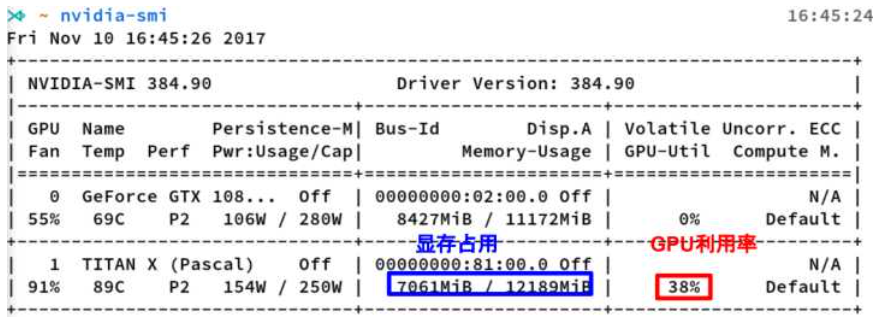

nvidia-smi是Nvidia显卡命令行管理套件,基于NVML库,旨在管理和监控Nvidia GPU设备。

nvidia-smi的输出

这是nvidia-smi命令的输出,其中最重要的两个指标:

显存占用和GPU利用率是两个不一样的东西,显卡是由GPU计算单元和显存等组成的,显存和GPU的关系有点类似于内存和CPU的关系。

这里推荐一个好用的小工具:gpustat,直接pip install gpustat即可安装,gpustat基于nvidia-smi,可以提供更美观简洁的展示,结合watch命令,可以动态实时监控GPU的使用情况。

watch --color -n1 gpustat -cpu

gpustat 输出

显存可以看成是空间,类似于内存。

显存用于存放模型,数据

显存越大,所能运行的网络也就越大

GPU计算单元

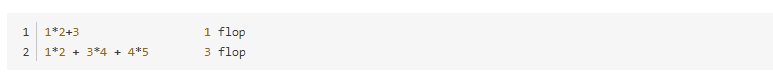

类似于CPU中的核,用来进行数值计算。衡量计算量的单位是flop: the number of floating-point multiplication-adds,浮点数先乘后加算一个flop。计算能力越强大,速度越快。衡量计算能力的单位是flops:每秒能执行的flop数量

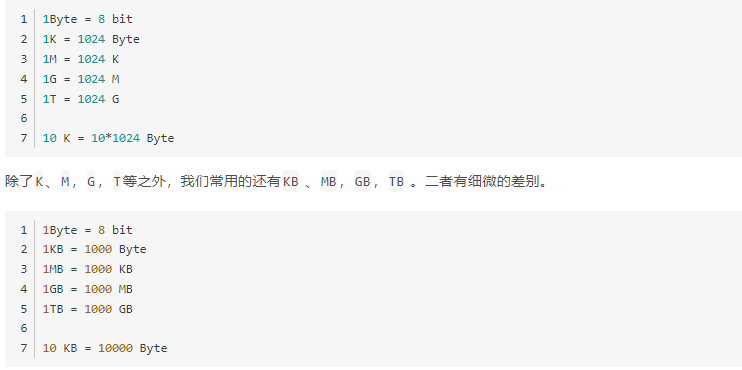

1.1 存储指标

K、M,G,T是以1024为底,而KB 、MB,GB,TB以1000为底。不过一般来说,在估算显存大小的时候,我们不需要严格的区分这二者。

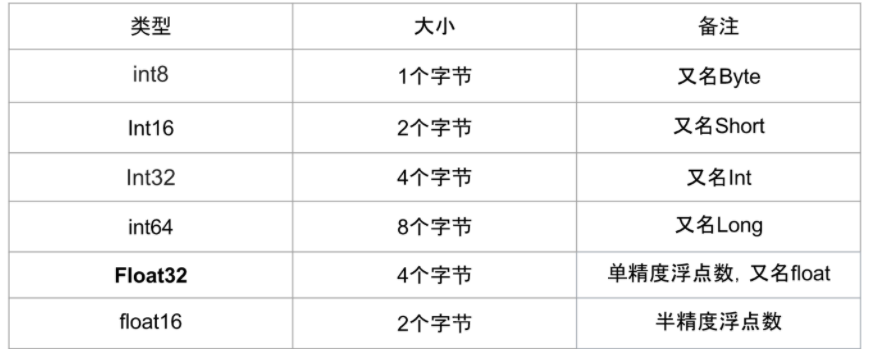

在深度学习中会用到各种各样的数值类型,数值类型命名规范一般为TypeNum,比如Int64、Float32、Double64。

常用的数值类型如下图所示:

常用的数值类型

其中Float32 是在深度学习中最常用的数值类型,称为单精度浮点数,每一个单精度浮点数占用4Byte的显存。

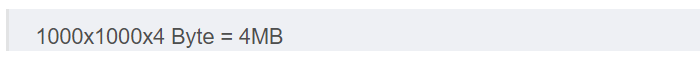

举例来说:有一个1000x1000的 矩阵,float32,那么占用的显存差不多就是

2x3x256x256的四维数组(BxCxHxW)占用显存为:24M

1.2 神经网络显存占用

神经网络模型占用的显存包括:

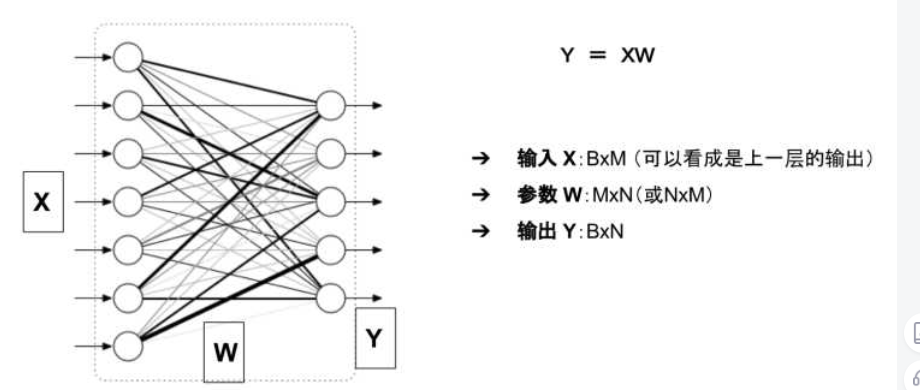

举例来说,对于如下图所示的一个全连接网络(不考虑偏置项b)

模型的输入输出和参数

模型的显存占用包括:

输入X可以看成是上一层的输出,因此把它的显存占用归于上一层。

这么看来显存占用就是W和Y两个数组?

并非如此!!!

下面细细分析。

1.2.1 参数的显存占用

只有有参数的层,才会有显存占用。这部份的显存占用和输入无关,模型加载完成之后就会占用。

有参数的层主要包括:

卷积

全连接

BatchNorm

Embedding层

... ...

无参数的层:

多数的激活层(Sigmoid/ReLU)

池化层

Dropout

... ...

更具体的来说,模型的参数数目(这里均不考虑偏置项b)为:

Linear(M->N): 参数数目:M×N

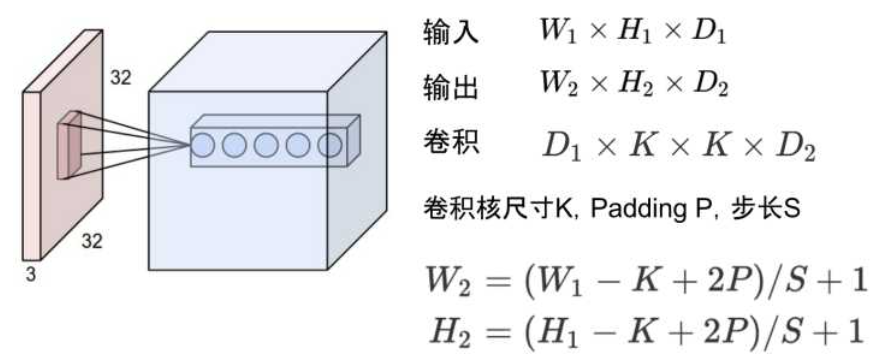

Conv2d(Cin, Cout, K): 参数数目:Cin × Cout × K × K

BatchNorm(N): 参数数目:2N

Embedding(N,W): 参数数目:N × W

参数占用显存 = 参数数目×n

n = 4 :float32

n = 2 : float16

n = 8 : double64

在PyTorch中,当你执行完model=MyGreatModel().cuda()之后就会占用相应的显存,占用的显存大小基本与上述分析的显存差不多(会稍大一些,因为其它开销)。

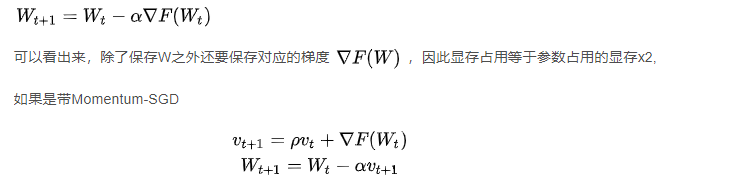

1.2.2 梯度与动量的显存占用

举例来说, 优化器如果是SGD:

这时候还需要保存动量, 因此显存x3

如果是Adam优化器,动量占用的显存更多,显存x4

总结一下,模型中与输入无关的显存占用包括:

1.2.3 输入输出的显存占用

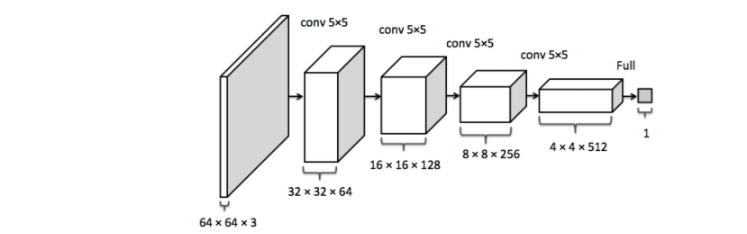

这部份的显存主要看输出的feature map 的形状。

feature map

比如卷积的输入输出满足以下关系:

据此可以计算出每一层输出的Tensor的形状,然后就能计算出相应的显存占用。

模型输出的显存占用,总结如下:

需要计算每一层的feature map的形状(多维数组的形状)

模型输出的显存占用与 batch size 成正比

需要保存输出对应的梯度用以反向传播(链式法则)

模型输出不需要存储相应的动量信息(因为不需要执行优化)

深度学习中神经网络的显存占用,我们可以得到如下公式:

显存占用 = 模型显存占用 + batch_size × 每个样本的显存占用

可以看出显存不是和batch-size简单的成正比,尤其是模型自身比较复杂的情况下:比如全连接很大,Embedding层很大

另外需要注意:

1.3 节省显存的方法

在深度学习中,一般占用显存最多的是卷积等层的输出,模型参数占用的显存相对较少,而且不太好优化。

节省显存一般有如下方法:

降低batch-size

下采样(NCHW -> (1/4)*NCHW)

减少全连接层(一般只留最后一层分类用的全连接层)

计算量的定义,之前已经讲过了,计算量越大,操作越费时,运行神经网络花费的时间越多。

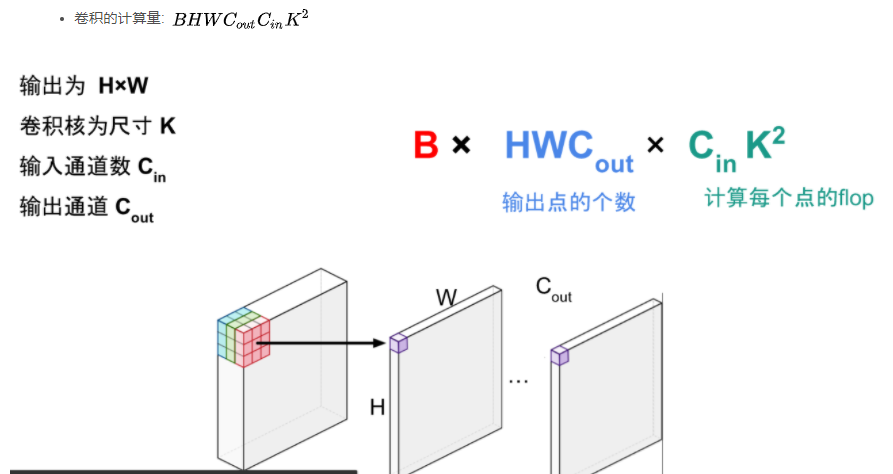

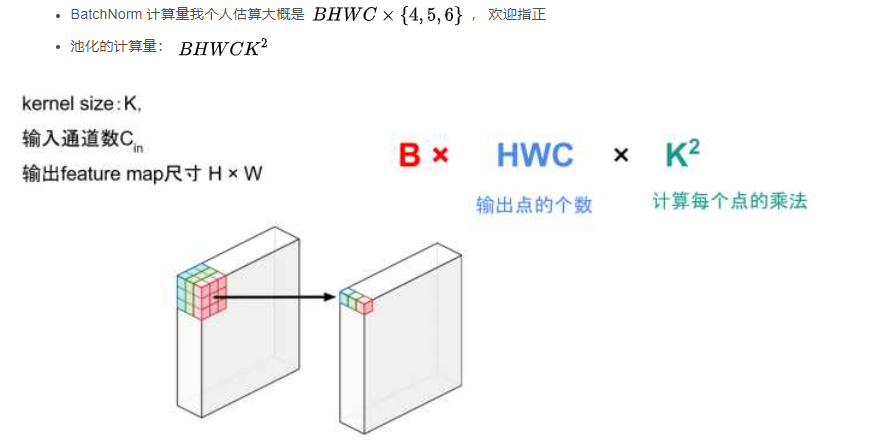

2.1 常用操作的计算量

常用的操作计算量如下:

卷积的计算量分析

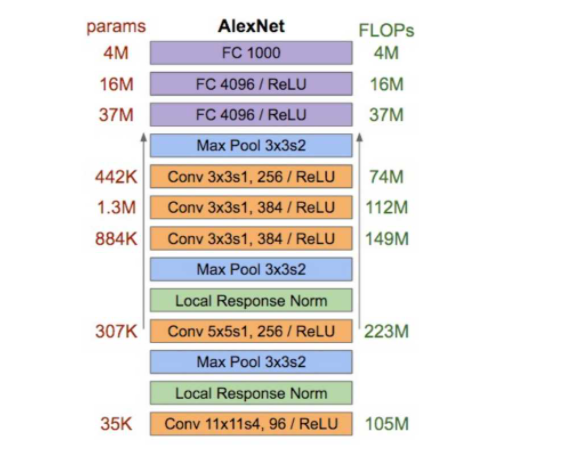

2.2 AlexNet 分析

AlexNet的分析如下图,左边是每一层的参数数目(不是显存占用),右边是消耗的计算资源

AlexNet分析

可以看出:

2.3 减少卷积层的计算量

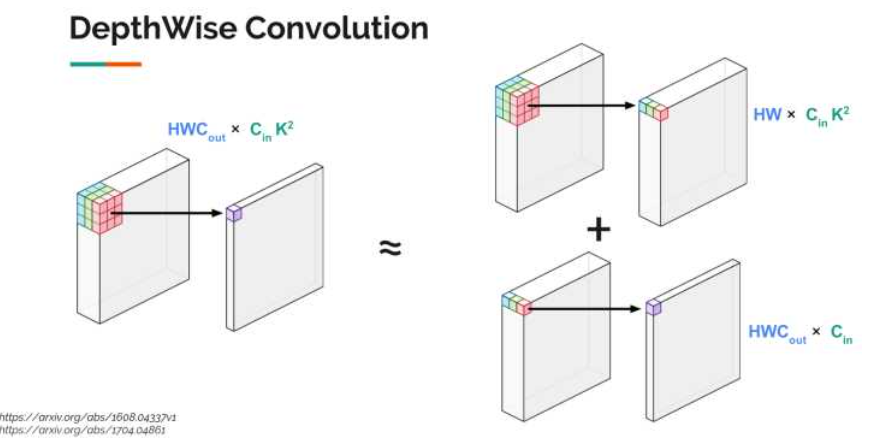

今年谷歌提出的MobileNet,利用了一种被称为DepthWise Convolution的技术,将神经网络运行速度提升许多,它的核心思想就是把一个卷积操作拆分成两个相对简单的操作的组合。如图所示, 左边是原始卷积操作,右边是两个特殊而又简单的卷积操作的组合(上面类似于池化的操作,但是有权重,下面类似于全连接操作)。

Depthwise Convolution

这种操作使得:

2.4 常用模型 显存/计算复杂度/准确率

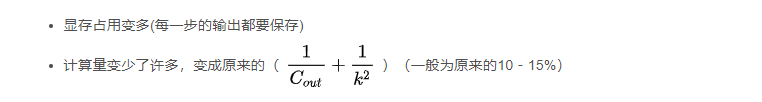

去年一篇论文(http://link.zhihu.com/?target=https%3A//arxiv.org/abs/1605.07678)总结了当时常用模型的各项指标,横座标是计算复杂度(越往右越慢,越耗时),纵座标是准确率(越高越好),圆的面积是参数数量(不是显存占用)。左上角我画了一个红色小圆,那是最理想的模型的的特点:快,效果好,占用显存小。

常见模型计算量/显存/准确率

3.1 建议

尤其是batch-size,假定GPU处理单元已经充分利用的情况下:

增大batch size能增大速度,但是很有限(主要是并行计算的优化)

增大batch size能减缓梯度震荡,需要更少的迭代优化次数,收敛的更快,但是每次迭代耗时更长。

增大batch size使得一个epoch所能进行的优化次数变少,收敛可能变慢,从而需要更多时间才能收敛(比如batch_size 变成全部样本数目)。

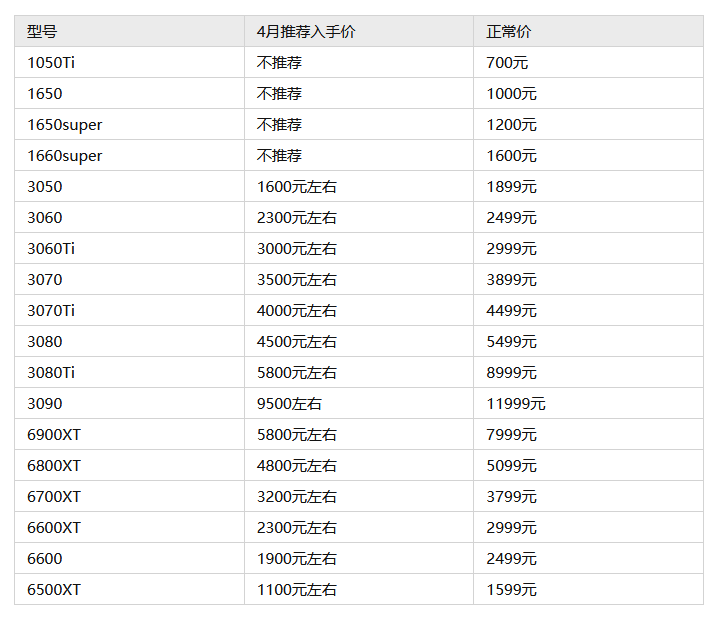

3.2 关于显卡购买

一般显卡购买渠道就是京东自营、淘宝等电商平台,线下实体店也可以购买。 正常时期,同款显卡,京东自营的价格会略高于淘宝,主要是京东自营的售后比淘宝更好,更放心,而特殊时期,比如现在部分型号淘宝和京东自营的价格比较悬殊,我建议是淘宝购买,如果价格相差不大,优先京东自营购买。像微星不支持个人送保,我不建议在淘宝和拼多多等渠道购买,售后不方便,建议天猫旗舰店及京东自营等有售后保障的渠道购买,支持个人送保的品牌在哪里买都可以。

5月推荐入手价

本文都是针对单机单卡的分析,分布式的情况会和这个有所区别。在分析计算量的时候,只分析了前向传播,反向传播计算量一般会与前向传播有细微的差别。