机器学习模型的可解释性一直是研究的热点和挑战之一,同样也是近两年各大顶会的投稿热门。

这是因为模型的决策过程不仅需要高准确性,还需要能被我们理解,不然我们很难将它迁移到其它的问题中,也很难进行算法的debug。

更重要的是,提高机器学习可解释性可以帮助我们提高模型的透明度和用户信任度,还能引导模型的开发和优化过程,有效识别和防止潜在的偏差问题,这对金融、医疗等领域至关重要。

目前这方向有四种主流方法:局部解释性方法、全局解释性方法、基于规则的解释性方法和机制性解释性方法。为了方便大家找idea,我根据这四种方法整理好了15篇最新的论文,开源代码已附,想发论文的朋友别错过。

扫码添加小享,回复“机器解释”

免费获取全部论文+开源代码

全局解释性方法:

这类方法旨在解释整个模型的行为,而不是单个预测。例如,SHAP通过合作博弈论的概念来分配每个特征对模型预测的贡献。

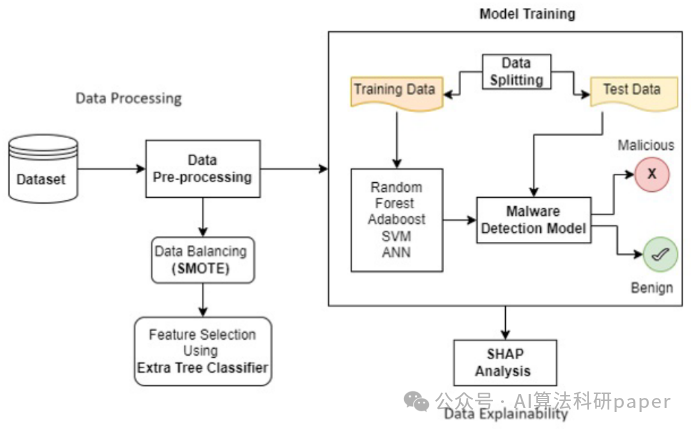

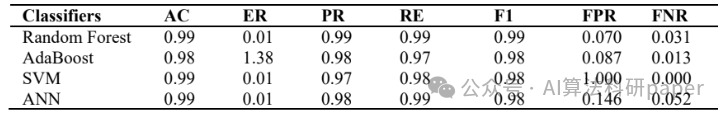

Enhancing Malware Detection through Machine Learning using XAI with SHAP Framework

方法:论文旨在通过结合机器学习和可解释的人工智能(XAI)框架,提高恶意软件检测的能力。该研究采用了SHAP方法,显著提高了机器学习模型的可解释性。这种方法可以提高模型的准确性和公平性,并限制可能发生的偏见,在恶意软件检测方面的准确率超过98%。

创新点:

- 提出了一种使用XAI(可解释的人工智能)框架的方法,结合多种机器学习模型,用于恶意软件检测。这种方法通过可视化模型结果和突出显示最可信和详细的特征来帮助理清决策步骤,从而提高模型的准确性和公正性。

-

结合SHAP分析,解释了模型的输出,揭示了每个特征对模型预测的贡献。SHAP分析通过全局和局部特征重要性的计算,提供了对模型行为的更好理解,增强了机器学习模型的可解释性和用户信任度。

局部解释性方法:

这类方法通过分析单个预测附近的模型行为来提供解释。例如,LIME通过构建一个模型的局部近似来解释为什么模型对特定输入样本做出特定的预测。

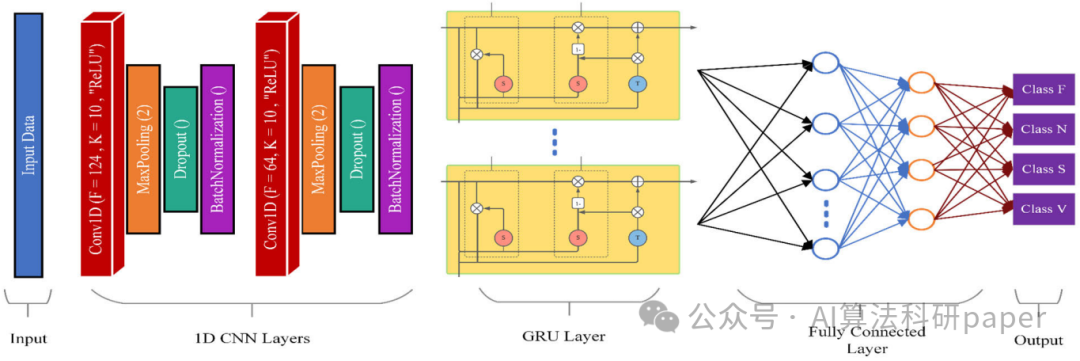

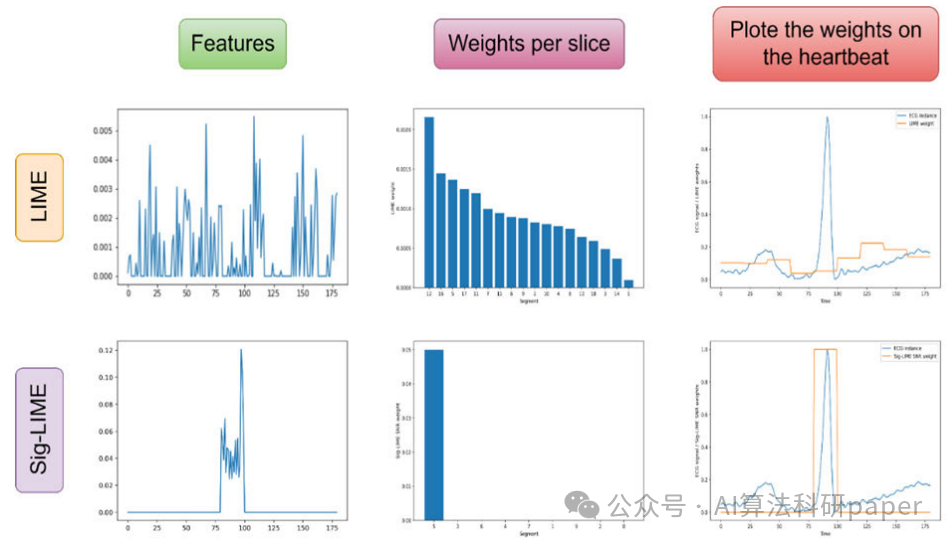

Sig-Lime: A Signal-Based Enhancement of Lime Explanation Technique

方法:论文提出了一种名为Sig-LIME的方法,它是对现有的局部可解释模型无关解释技术的信号增强改进。Sig-LIME通过引入一种新颖的数据生成技术,捕捉特征之间的时间依赖性,从而提高了解释的可信度和稳定性。

创新点:

- Sig-LIME提出了一种新的数据扰动技术,通过保留信号数据的时间依赖性,提高了解释的可信度和稳定性。

- Sig-LIME引入了高斯噪声和信噪比(SNR)的创新使用,用于生成具有实际变异性的新心跳数据,从而更准确地表示原始信号的局部结构。

- Sig-LIME结合了随机森林模型和热力图可视化,提供了对ECG信号的预测结果更透明和直观的解释。

扫码添加小享,回复“机器解释”

免费获取全部论文+开源代码

机制性解释性方法:

这类方法深入模型内部,探索其运作机制,以提供关于模型决策过程的内在见解,包括激活最大化、层析成像等技术,特别适用于深度学习模型。

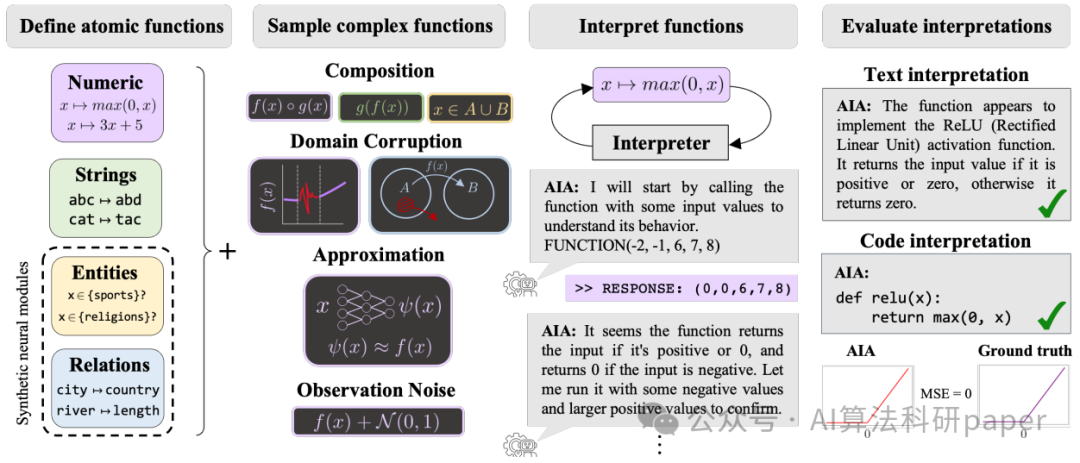

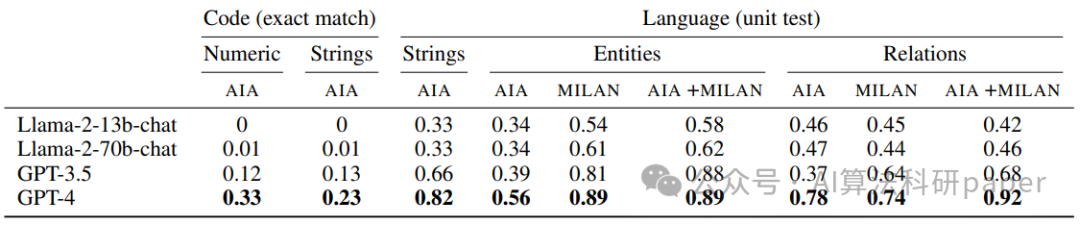

FIND: A Function Description Benchmark for Evaluating Interpretability Methods

方法:FIND是一个用于评估自动化解释方法的基准测试套件,包含了一系列预设的函数,这些函数模拟了训练有素的神经网络的组件,并提供了相应的描述。这些函数跨越文本和数值领域,涉及现实世界的复杂性,如噪声、组合、近似和偏差。

创新点:

- 提出了三种不同的解释方法,包括非交互式解释、自动解释代理和两者结合的方法。

- 使用现成的语言模型(如GPT-4、GPT-3.5和Llama-2)作为解释器,以及不需要人为干预的方式进行操作。

- 引入了一种新的交互式方法,其中自动解释代理可以独立进行实验,并根据观察到的函数输出来更新描述。

基于规则的解释性方法:

这类方法使用启发式规则或领域知识来解释模型的行为。例如,决策树和决策规则集可以直观地显示数据是如何被分类的。

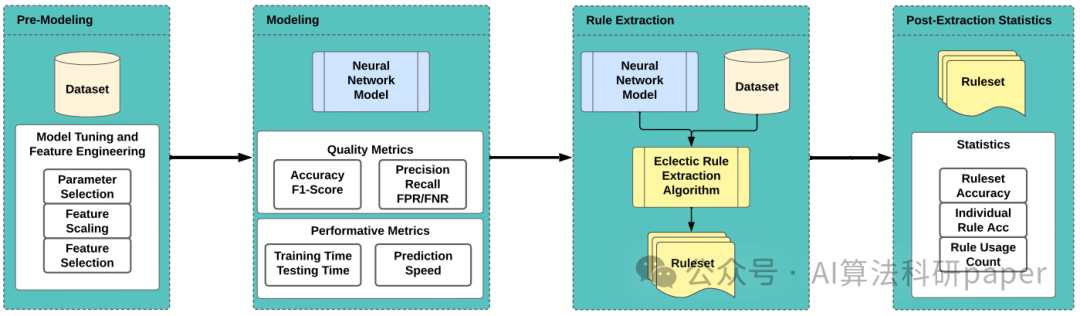

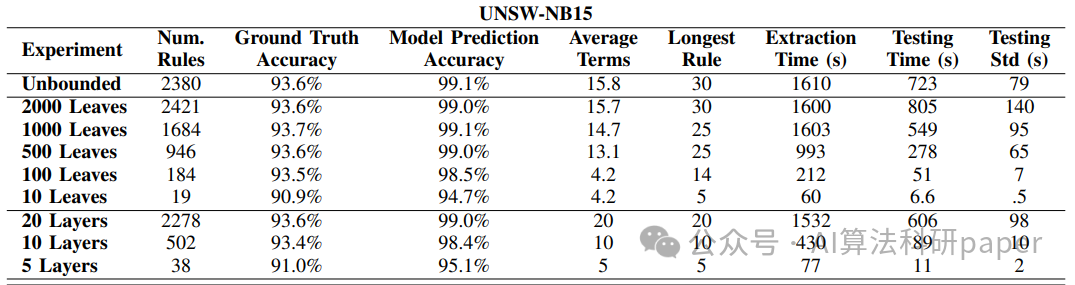

Eclectic Rule Extraction for Explainability of Deep Neural Network based Intrusion Detection Systems

方法:论文提出了一种混合型可解释入侵检测系统(X-IDS)架构,使用一种称为“折衷规则提取”的白盒算法来从深度神经网络(DNN)中提取易于理解的规则集。这种方法结合了教学法和分解法规则提取技术的优势,旨在提高可扩展性和可信度。

创新点:

- 创建了一种使用多样化规则提取的X-IDS架构,用于为DNN生成解释。通过限制规则提取算法,可以显著提高其速度,同时保持高准确性。

-

通过限制决策树生成的叶子节点数量,可以限制生成的规则集的数量和规模。这可以提高算法的速度,同时保持较高的准确性。

扫码添加小享,回复“机器解释”

免费获取全部论文+开源代码