今天我们来说说一个挺有趣的话题:阿里的面试官为什么会提到不建议在MySQL中用delete删除数据。很多人一听到“不要用delete”,第一反应都是:“咋了?DELETE是MySQL自带的,还不能用了?”

但深入分析后你就会发现,MySQL本身并没有特别说明不能用DELETE,更多的还是业务场景下的设计考量。那为什么阿里的面试官不建议用呢?咱们一块来聊聊。

首先声明,MySQL没有明确说过“不能用delete”。DELETE是SQL中最基本的操作之一,删除不需要的数据,腾出空间,这不挺正常的吗?那为啥阿里会说不建议用呢?其实,这个问题要分开看。

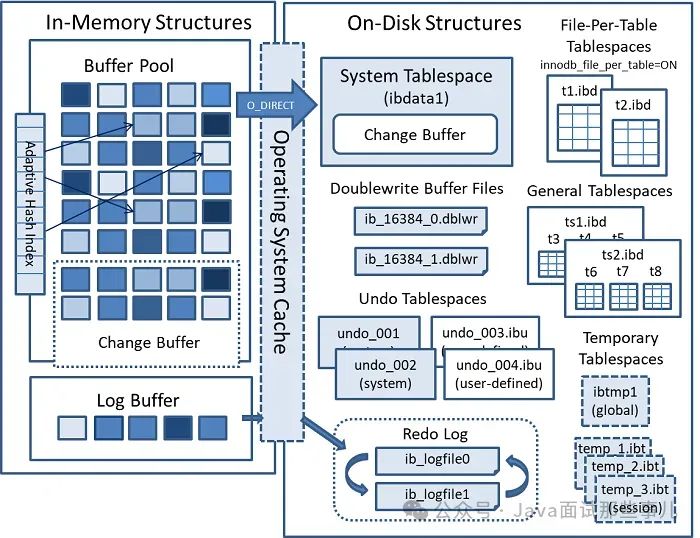

我们先从MySQL的存储引擎——InnoDB的存储结构说起。InnoDB存储是由逻辑存储结构和物理存储结构组成的,数据存储的最小单位是页(page),当我们删除数据时,MySQL并不会立马回收对应的存储空间,而是把这部分空间标记为“可用的”,也就是说,你删除的数据并没有马上消失。

这就带来了一个问题——删除的数据并不会释放物理空间!所以当你表里有很多数据需要删除时,虽然数据库看起来少了些行,但是你的表文件大小可能一点没变,甚至还会越来越大,因为删除会造成碎片。

那问题到底出在哪呢?其实吧,像阿里这种公司在业务量和数据规模都非常庞大的情况下,得有自己的一套应对策略。

大表里的数据如果你用DELETE删,可能会惹出很多问题,比如性能急剧下降,磁盘空间不释放,甚至产生大量碎片。今天就让我们从技术角度,来剖析一下为啥大表不推荐直接用DELETE。

大家都知道,阿里的系统每天要处理海量数据,动辄几亿甚至几十亿的单表数据。普通的增删改查在这样的场景下,可能会成为数据库的噩梦。

举个例子,我负责的某个系统,随着业务量的爆炸式增长,表里的数据猛增到几亿条。我一查数据库,才发现很多表的SQL性能已经掉到谷底,用户体验极差。

你说这咋办?批评业务方?骂他们不讲武德?这些都治标不治本,问题的关键还在于我们怎么处理这些“废旧数据”。

那么在这种情况下,如果继续用DELETE删数据,会发生什么?

空间不释放:当我们使用DELETE语句删除一大批数据时,InnoDB引擎实际上只是做了个“标记删除”,数据并不会从磁盘上立即消失。

文件大小也不会立刻减少,甚至很多时候删除了一大堆数据,表的文件大小却丝毫未动。这种“标记删除”的机制虽然保证了数据还能在事务回滚时恢复,但同时也意味着,数据物理上还占着地方呢。

碎片问题:DELETE数据后,表里会产生大量的“空洞”——这些被标记为已删除的数据并不会被立即重用。

下次有新的数据插入时,这些空洞未必能匹配得上新的数据大小,造成了表空间内的严重浪费。久而久之,SQL的执行速度会受这些碎片影响,变得越来越慢。

回收碎片带来的性能开销:虽然我们可以用OPTIMIZE TABLE来回收这些空间,但这会消耗大量的I/O资源。

尤其是在线上环境操作时,你可能会发现,执行这个命令相当于搞了一次大手术——它需要重建整个表,重新分配所有数据页。这一过程中会占用大量的CPU和I/O,直接影响系统性能。

那有同学可能会问:“那不就是删个数据嘛,怎么还影响查询性能呢?”这个还真得具体说说。

当我们在表中用DELETE删除了大量数据之后,这些数据虽然从逻辑上“没了”,但实际上还留在数据页里。接下来如果有查询操作,MySQL在扫描数据时,会把那些标记为“已删除”的数据也给扫描一遍。

这意味着你实际上在查询的是一张更大的表,耗费了更多的I/O。长期这样下去,表的响应时间会变得越来越慢,性能自然也就越来越差。

举个栗子:

假设我们有一个表,叫user,其中存了100万条用户数据。最开始,查询性能还不错,几秒钟就能返回结果。接着我们用了DELETE删除了50万条过期数据,但这些“过期数据”依然在文件系统里,占着数据页的位置。

结果是,即便你的查询只需要扫5万条数据,MySQL依然要扫描整个数据页的100万条记录,这就大大增加了查询时间。

更糟糕的是,当数据量继续增加的时候,MySQL要扫描的“死数据”越来越多,查询性能将直线下滑。此时,DELETE这个操作反而成了系统的累赘。

关于这个问题,技术圈里其实也一直在争论。大佬们意见不一,有的人认为应该用软删除(soft delete),即给数据打个标记,显示它“已经被删除了”,但并不真删。而另一些人则主张硬删除,直接把数据彻底清理干净。

软删除派:

软删除的好处在于你可以随时恢复数据,尤其是对于那些需要保留历史记录的业务来说,这种方式能确保数据完整性。

你可以给每条记录加一个is_deleted字段,当这条记录被“删除”时,is_deleted的值从0变成1。查询时,只需要加个条件WHERE is_deleted = 0就能过滤掉被删除的数据。

但是软删除也有它的弊端:

数据量膨胀:由于“删除”后的数据并没有真正删除,表里的数据量会持续膨胀。对某些高并发场景,这种方式显然不太适用。

索引失效:随着数据量的增加,查询性能下降。这时即使有索引,也可能变得没什么用了,毕竟MySQL还是得扫描大量“死数据”来做过滤。

硬删除派:

硬删除的支持者则主张直接把数据彻底清理掉。这样表的大小可以实时减小,不会有“死数据”影响性能。

然而,硬删除在实际操作中也有挑战,特别是数据量非常大的情况下,一次性删太多数据,数据库负载可能瞬间飙升,引发系统不稳定。

那阿里是怎么做的呢?他们的解决方案是——分区表+归档+定期清理。

在阿里这种超大规模数据场景下,DELETE已经不再是他们的首选。他们会对大表进行分区管理,把旧数据定期归档到冷存储里,然后定期清理这些冷数据。这样不仅保证了数据的完整性,还能让热数据保持高效。

你也可以这样做:

分区表:把数据按时间段或者业务类型进行分区管理。比如每天的数据就存在一个分区里,到了一定的时限,比如三个月后,把这些分区的数据直接归档到冷存储。这样你可以避免让MySQL扫描无效的过期数据。

归档表:把过期的数据移到归档表里,而不是直接删除。这样可以保证万一出现业务问题,你还能随时把这些数据还原回来。

定期清理:对那些确实已经没用的数据,定期使用批量删除的方式进行清理,别一次性删太多,控制删除频率。

最后,咱们再简单提一下碎片整理。就算你决定不直接删除数据,系统中还是会不可避免地产生碎片。

这个时候,可以考虑定期进行碎片整理,也就是使用OPTIMIZE TABLE或者ANALYZE TABLE命令来回收表中的碎片。但别忘了,这个操作非常耗资源,建议选择业务低峰期进行。

说了这么多,不是说你以后再也不能用DELETE了。只是你得根据实际情况选择合适的方案。如果你处理的是大表、或者业务要求极高的性能,那就尽量不要直接用DELETE。

相反,考虑软删除、分区表、归档数据这些更“优雅”的解决方案,才能更好地管理你的数据,也让数据库运行得更顺畅。

还有,别拿阿里的面试题当圣经!阿里的做法适合它的业务场景,但未必适合你们的系统。那么你们怎么看呢?欢迎评论区留言分享!

对编程、职场感兴趣的同学,可以链接我,微信:yagebug 拉你进入“程序员交流群”。