不知不觉间,距离掀起全球新一轮 AI 革命的 ChatGPT 出道,已经过去一周年了。在这场颠覆性的 AI 革命中,许多企业和程序员们逐渐形成了一个共识:“不会用 AI 就将被淘汰”。

为了避免“被淘汰”,这一年来众多企业和程序员全力拥抱 AI、开发各种 AI 应用——连程序员自己都不禁要吐槽一句:“我们是为数不多喜欢革自己命的群体。”

作为一位(上学时候)接触过代码的技术编辑,最近,我的程序员朋友们给我安利了一个产品,说 10 分钟就能用它开发一个 AI 应用!

程序员:“你可以随时用它做一个’证件照‘应用、一个专属 AI 秘书或一个 AI 心理咨询师……你就说你想做啥,咱现在就缺需求和创意。”

我:“啥玩意儿???”

10 分钟开发一个 AI 应用,是

真的!

讲句实话,听到 “10 分钟开发一个 AI 应用”时,我的第一反应是:你就吹吧!虽然本人并不从事开发工作,但基本常识还是有的——光是部署个 AI 应用的开发环境,就不止 10 分钟了。

但是本着 FOMO(fear of missing out)的心态,我还是去体验了一下。

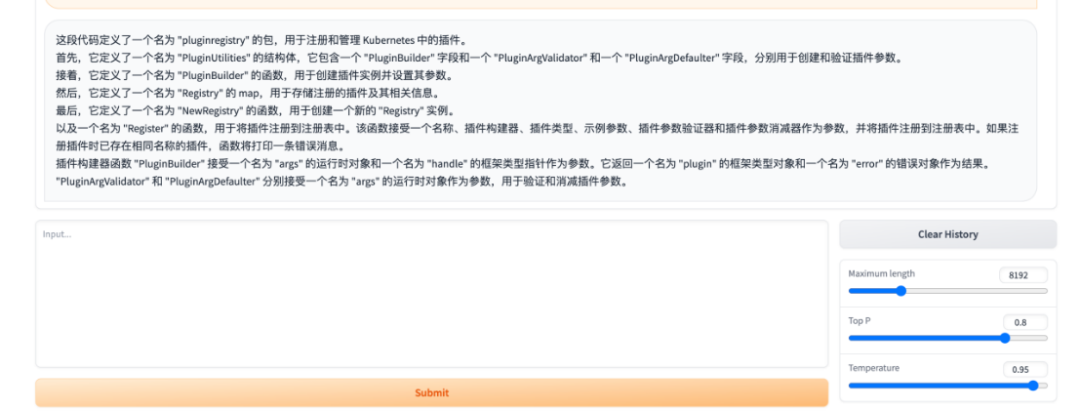

结果,跟着官网上的文档和操作手册,我真的花了不到 10 分钟做了一个“程序员小助手”:程序员可以将自己想要阅读的代码复制给它,并给出指令“解释代码”,“程序员小助手”即可给出每行代码的意思和整体逻辑。

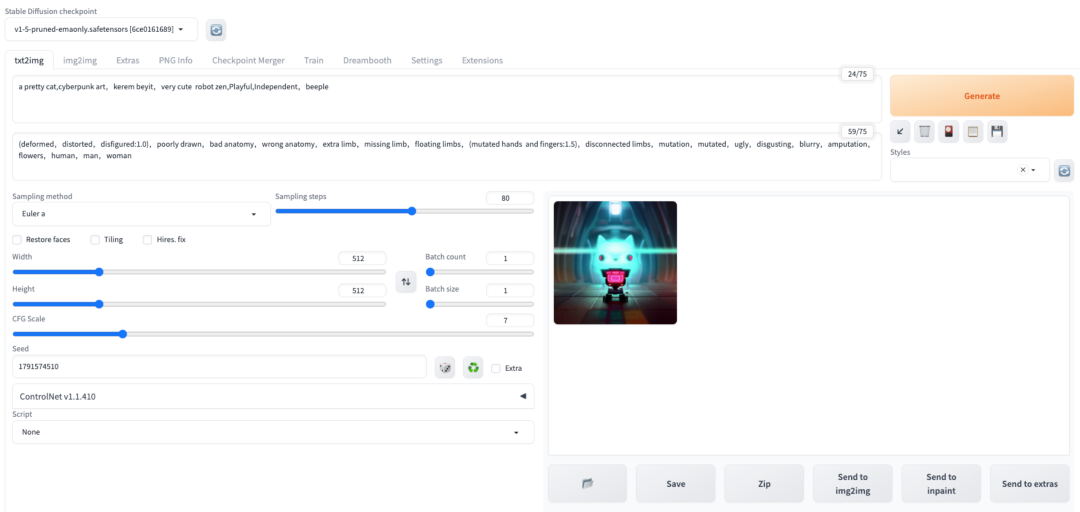

不仅如此,我还用同样短的时间做出了一个设计助手,实现“AI 爆改灵魂画手”,开了一个类似于妙鸭相机的“个人专属照相馆”。

体验至此,我满脑子都是:这也太香了吧!

连我这样的菜鸡,都可以轻易做到“10 分钟开发一个 AI 应用”:除了等待两个模型初始化,我几乎没再花费其他时间——而这个产品,就是腾讯云高性能应用服务(Hyper Application Inventor,简称 HAI)。

开发 AI 应用难,腾讯云 HAI 来破局

许多企业和开发者全力拥抱 AI、积极开发或接入各种 AI 应用,但在这个过程中却发现,这件事似乎并没有想象中简单:硬件选型、环境部署复杂、开发门槛高、技术人才不足等一系列问题,都在阻碍着 AI 应用的落地。

首先,你要过的第一关:硬件选型。

原来,要开发一款 AI 应用,你要先有 GPU 算力。先别说 GPU 有多贵,就说一卡难求的今天,云几乎是最佳选择。

然而,先要仔细评估业务场景需要配置什么类型的 GPU、CPU、内存,再从一大堆产品类目中分别挑出合适的存储、网络、安全产品,并且自行选择 CPU 内存配比、GPU 卡型。

第二个难关:环境部署复杂。

举个例子。相信对于不少开发者而言,进入开发工作之前的模型环境部署,是一件十分繁琐却又无法绕开的事情。以部署和安装 ChatGLM2-6B 模型环境为例,开发者通常需要准备好以下工具和环境:

- Python 3.6 及以上版本

- TensorFlow 2.4 及以上版本

- PyTorch 1.6 及以上版本

- CUDA 10.0 及以上版本

- CUDNN 7.6 及以上版本

- Git

- wget

- unzip

- vim 或 emacs 编辑器

准备好之后,开发者要从 GitHub 上下载 ChatGLM2-6B 源代码、安装依赖项、配置模型路径等等。

当然,以上这一切对于经验丰富的开发者而言自然不在话下,但如果是初次接触的新手小白,情况可能迥然不同——好不容易把模型环境部署完了,结果抬头一看天都黑了,只能叹口气:要是谁能帮我把这些准备工作都做了就好了……

在这种背景下,近期腾讯云推出了“开箱即用”的高性能应用服务 HAI 平台,希望解决开发者的难题。

HAI 能够提供即插即用的算力与常见环境,可帮助中小企业、开发者及个人用户快速部署语言模型(LLM)、AI 作画、数据科学等高性能应用,原生集成配套的开发工具与组件,从而大幅提高应用的开发生产效率,并大幅降低开发门槛。

腾讯云 HAI 支持智能选型,可根据 AI 应用自动匹配推选 GPU 算力资源,实现最高性价比,减轻了开发者在选型上的负担。

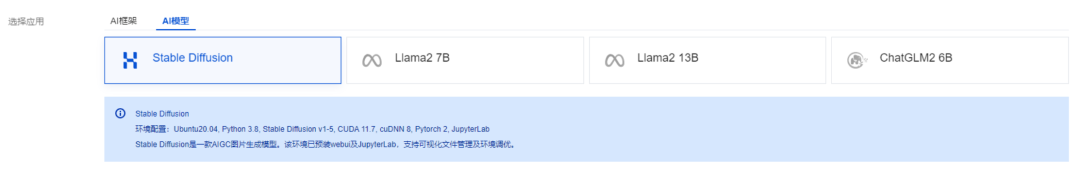

针对上面提到的复杂环境部署,腾讯云 HAI 为开发者事先预置了 StableDiffusion、ChatGLM2-6B、Llama2 7B 等热门模型及常用插件,用户只需要点选,几分钟即可自动构建 LLM、AI 作画等应用环境,降低了开发者的技术门槛。

如果 HAI 上面预装的模型满足不了你的天马行空,你也可以根据自身需要,将最新的开源模型下载部署到 HAI。比如最近很火的 Stable Video Diffusion 模型,让图片动起来。

HAI 还支持了"学术加速"能力,线路自动择优,大幅提升对部分主流学术资源平台的资源访问、下载速度。

腾讯云甚至还想帮你降低第三道难关:开发难度高。

原来大部分的云服务器操作系统,大部分是基于码农常用的 Linux 内核研发。开机之后基本需要通过使用命令进行交互,没有代码基础的同学可谓“一脸懵逼”。

在操作界面上,HAI 提供 WebUI 等直观、易用的可视化算力连接方式,一键进入服务,对开发者友好、即开即用的图形界面容易上手,让开发者能更好地进行理解和操作。

有了以上这些特点,也难怪能 10 分钟就搞定一个 AI 应用——HAI 不仅把 AI 应用开发的前期准备工作全部简化,其提供的 WebUI 等可视化界面更是大幅降低了开发门槛。

需要更多爆款应用,AIGC 时代才会来

现在的 AIGC 时代,最不缺的是大模型,最缺的是算力、创意与应用场景。

基于此,我们跟腾讯云异构计算产品负责人宋丹丹聊了聊。她表示,ChatGPT 出现了之后,引爆了大家的想象,但目前更多的探索还是在大模型等技术层面,实际落地的应用、实用的工具,还没有真正落地以及被广泛使用。腾讯云推出 HAI 的初衷,就是希望可以降低 AIGC 应用的开发门槛,不让代码阻碍创意的落地。

“我们希望让更多的人可以参与进来,而不是围观甚至被落下。”

如果不让越来越多的人学会使用 AI 或者创造 AIGC 应用,其实 AIGC 应用会变成一种特权,而不是让技术真正地“赋能”每一个人,也只有在这样的情况下,才会有更多创意与爆款应用落地,我们所期待的 AIGC 时代才会真的到来。

基于这样的理解,腾讯云 HAI 的产品团队首先筛选出:哪些人,被技术门槛挡在了外面?答案显然不是大厂,也不是完全的小白用户。

HAI 所面向的用户,腾讯云将其分成两类:

一类是研发类用户,原来可能是做前端等岗位,虽然有研发经验,但是在 AI 领域的知识和工程经验比较少。他们感兴趣、也希望尝试开发应用,但算力的获取、部署运维的复杂,都成为了挡在前面的门。正如前文所及,部署一个 AI 开发环境,是如此复杂,足以劝退大部分有想法的开发者们。

另一类是应用型、或可称为设计类用户,主要是学生和设计师等。这类用户的技术不强,需要可视化的交互界面来操作,但他们的创造力和应用场景需求很强:市面上丰富的 Stable Diffusion 模型,可以让他们的作品变得更加精美。针对这类用户,腾讯云会提供比较详细的文档教他们怎么换模型,且不需要懂代码。

另一问题是:为什么是现在推出 HAI?

“之前的图像识别、语音识别、自动驾驶等传统的模型,对于长尾用户来说意义不大,更多还是被大公司所使用,个人应用不起来。”宋丹丹解释,“但去年火起来的大语言模型或者说通用人工智能浪潮,对很多个人开发者来说是有使用价值的。”

在这波浪潮中,腾讯云看到了许多丰富的开源模型,规模在 7B 和 13B 不等,用户无需对模型进行重新训练,只需对模型做微调即可创建一个独立的应用。此外几个爆款应用的出现,也让业界看到了应用生态的巨大想象空间。

在内测阶段,已经有不少用户使用了 HAI,开发出一些比较有意思的应用,比如儿童照相馆、“看图识成语”小游戏、小学语文教案制作、英文润色专家、AI 周公等。

“我们相信产品正式上线之后,会看到更多用户的创造。”宋丹丹表示。

AI 不只绘画与对话,未来会聚焦 ModelOps

目前,HAI 产品刚刚上线,主要针对常见的应用场景与使用人群,做了相关环境与模型的预装,包括:

(1)AI 作画/设计

在如今迅速发展的 AI 领域中,投身于 AI 作画的设计师和开发者们越来越多。为此,HAI 预装了主流的 AI 作画模型,如 Stable Diffusion 等,并内置了常用插件等,使开发者、甚至是非专业技术背景的创作者,都能轻松部署和优化 AI 绘画模型,专注于创意的表达而无需深入研究底层技术和繁琐的技术配置。

(2)AI 对话/写作

ChatGPT 的一炮走红,让语言模型技术也在不断进步,基于此,HAI 预置了一系列强大的语言模型,如 Llama2、ChatGLM2 等,确保开发者能在最短时间内完成语言模型的部署工作,并保持高度的稳定性和可靠性,便于研究者和开发者更好地适应不同的语言处理任务,不在技术细节上再耗费时间。

(3)AI 开发测试

除了 AI 大模型外,HAI 还为开发者提供了一个理想的工作平台:预置了主流的 AI 框架和工具,如 TensorFlow、PyTorch 等,使开发者能更轻松地进行算法设计和模型优化(如新算法的原型开发、模型微调与迁移学习、深度学习框架的交叉测试等等),无需过多关注底层的硬件兼容性和软件配置问题。不仅如此,HAI 还预置了 Notebook、Python 环境以及主流分析软件,因此数据科学家也能在 HAI 上快速进行数据分析和图标处理。

当然,以上这些应用场景只是围绕 HAI 预置的某个模型,而它还支持让开发者自行下载开源模型部署到环境中,也支持多种模型同时使用,开发者可根据项目需求灵活选择组合,实现应用的快速扩展和迭代,以此发掘新的业务模式和机会。

关于 HAI 的未来产品规划,宋丹丹也进行了分享:针对 AI 场景,HAI 的整体思路是要匹配模型的发展阶段,为用户提供他们最需要的产品能力。

现阶段许多开发者需要通过多个模型组合,做出一个 MVP 来快速推向市场,测试用户的反应。因此,HAI 目前聚焦在如何让用户最快速、最省事、最低门槛地完成这个“快速验证”的过程。

一旦这个 MVP 经过验证获得了巨大成功,开发者就会有大规模部署需求。因此,未来不排除 HAI 会往大规模集群部署方向规划与优化:目前需求弱,是因为爆款应用还没出现;而未来一旦出现,多种能力势必要持续完善。

此外,未来 HAI 可能会围绕开发者的需求、ModelOps 的路径来构建应用服务,在高性能算力的基础上,可能还会上类似开源模型聚合、数据集等服务。

当然,HAI 也并非只能满足 AI 场景的需求,例如科学计算、视觉渲染等,也将是 HAI 会陆续完善的方向之一。

结语

AIGC 发展至今,开源和闭源的“路线之争”持续不断。

开源模型有着强烈的生命力,且发展速度很快。已有的爆款应用很多也基于开源模型,但其商业化落地一直备受挑战;另一方面,大型互联网公司与国内部分重要行业,都有着使用自研或闭源模型的需求。

作为平台型企业的腾讯云,自然是“成年人不做选择”,开源、闭源两条腿走路,同时满足大型企业与开发者等不同用户的场景需求:

面向大型企业级客户,腾讯云已经构建了全栈生态。在 IaaS 层,腾讯云提供了面向大模型训练的 HCC 高性能算力集群与通用 GPU 算力;在 PaaS 层面,提供云原生数据湖仓和向量数据库,以及面向大规模训练加速的 TI 平台;在模型层,通过模型商店 MaaS,支持接入腾讯混元大模型及 20 多个主流开源模型。

面向开发者,腾讯云此前推出了 Coding DevOps、云开发、Cloud Studio、轻量云服务器 LightHouse 等产品,希望降低开发者构建应用的部署、运维和开发成本。如今,HAI 的推出进一步丰富了腾讯云面向开发者侧的 AIGC 产品矩阵。

随着 HAI 这类平台出现,AIGC 出现越来越多爆款应用的可能性似乎正在增加:HAI 提高效能、降低门槛、对开发者友好的特点,让越来越多程序员能无缝体验 AI,有关 AI 应用的无限创意将快速落地……正如 HAI 平台的产品愿景所说:让每个开发者都能开发自己的 AI 应用。

在这种趋势下,AI 技术必将进一步发展并日益普及,同时这也将为 AI 对未来世界的影响赋予更多可能性。

HAI 平台体验地址:

https://cloud.tencent.com/product/hai