本文转自机器之心。

AI 生成内容已经成为当前人工智能领域的最热门话题之一,也代表着该领域的前沿技术。近年来,随着 Stable Diffusion、DALL-E3、ControlNet 等新技术的发布,AI 图像生成和编辑领域实现了令人惊艳的视觉效果,并且在学术界和工业界都受到了广泛关注和探讨。这些方法大多基于扩散模型,而这正是它们能够实现强大可控生成、照片级生成以及多样性的关键所在。

然而,与简单的静态图像相比,视频具有更为丰富的语义信息和动态变化。视频能够展示实物的动态演变过程,因此在视频生成和编辑领域的需求和挑战更为复杂。尽管在这个领域,受限于标注数据和计算资源的限制,视频生成的研究一直面临困难,但是一些代表性的研究工作,比如 Make-A-Video、Imagen Video 和 Gen-2 等方法,已经开始逐渐占据主导地位。

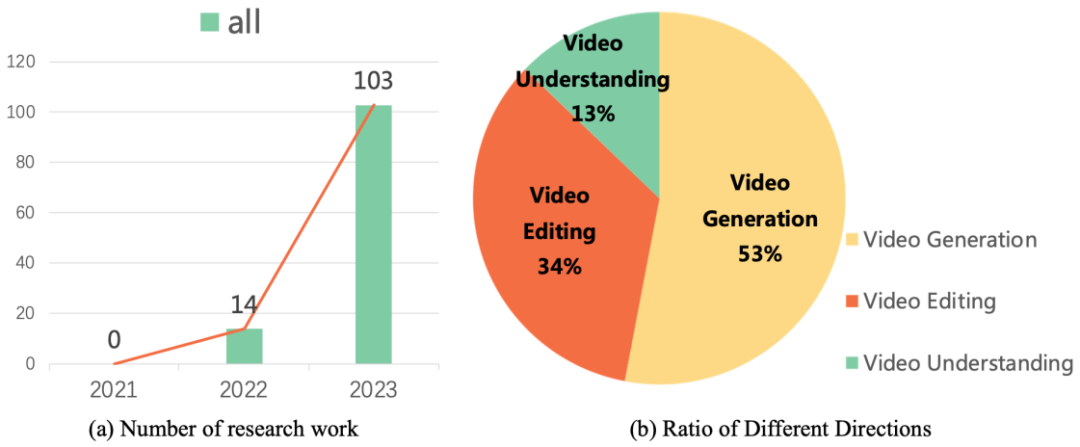

这些研究工作引领着视频生成和编辑技术的发展方向。研究数据显示,自从 2022 年以来,关于扩散模型在视频任务上的研究工作呈现出爆炸式增长的态势。这种趋势不仅体现了视频扩散模型在学术界和工业界的受欢迎程度,同时也凸显了该领域的研究者们对于视频生成技术不断突破和创新的迫切需求。

近期,复旦大学视觉与学习实验室联合微软、华为等学术机构发布了首个关于扩散模型在视频任务工作的综述,系统梳理了扩散模型在视频生成、视频编辑以及视频理解等方向的学术前沿成果。

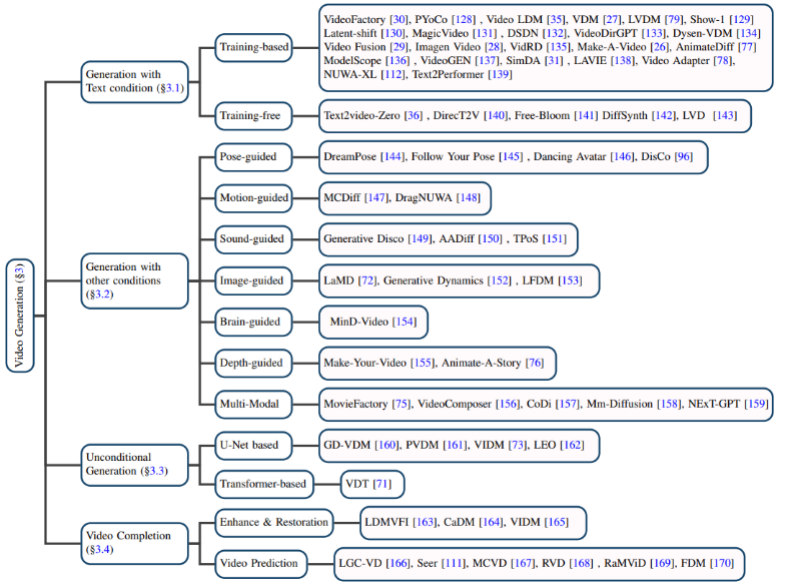

视频生成

基于文本的视频生成:自然语言作为输入的视频生成是视频生成领域最为重要的任务之一。作者首先回顾了扩散模型提出之前该领域的研究成果,然后分别介绍了基于训练的和无需训练的文本 - 视频生成模型。

Christmas tree holiday celebration winter snow animation.

基于其他条件的视频生成:细分领域的视频生成工作。作者将它们归类为基于以下的条件:姿势(pose-guided)、动作(motion-guided)、声音(sound-guided)、图像(image-guided)、深度图(depth-guided)等。

无条件的视频生成:该任务指的是在特定领域中无需输入条件的视频生成,作者根据模型架构主要分为基于 U-Net 和基于 Transformer 的生成模型。

视频补全:主要包括视频增强和恢复、视频预测等任务。

数据集:视频生成任务所用到的数据集可分为以下两类:

1.Caption-level:每个视频都有与之对应的文本描述信息,最具代表性的就是 WebVid10M 数据集。

2.Category-level:视频只有分类标签而没有文本描述信息,UCF-101 是目前在视频生成、视频预测等任务上最常用的数据集。

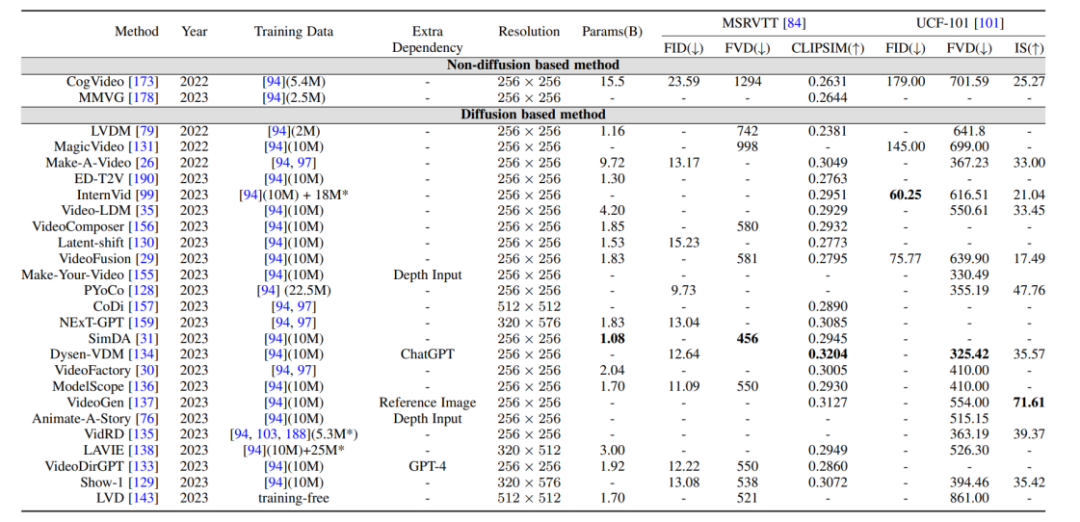

评价指标与结果对比:视频生成的评价指标主要分为质量层面的评价指标和定量层面的评价指标,质量层面的评价指标主要是基于人工主观打分的方式,而定量层面的评价指标又可以分为:

1. 图像层面的评价指标:视频是由一系列的图像帧所组成的,因此图像层面的评估方式基本上参照 T2I 模型的评价指标。

2. 视频层面的评价指标:相比于图像层面的评价指标更偏向于逐帧的衡量,视频层面的评价指标能够衡量生成视频的时序连贯性等方面。

此外,作者还将前述提到的生成模型在基准数据集上的评价指标进行了横向比较。

视频编辑

通过对许多研究的梳理,作者发现视频编辑任务的核心目标在于实现:

1. 保真度(fidelity):编辑后的视频的对应帧应当与原视频在内容上保持一致。

2. 对齐性(alignment):编辑后的视频需要和输入的条件保持对齐。

3. 高质量(high quality):编辑后的视频应当是连贯且高质量的。

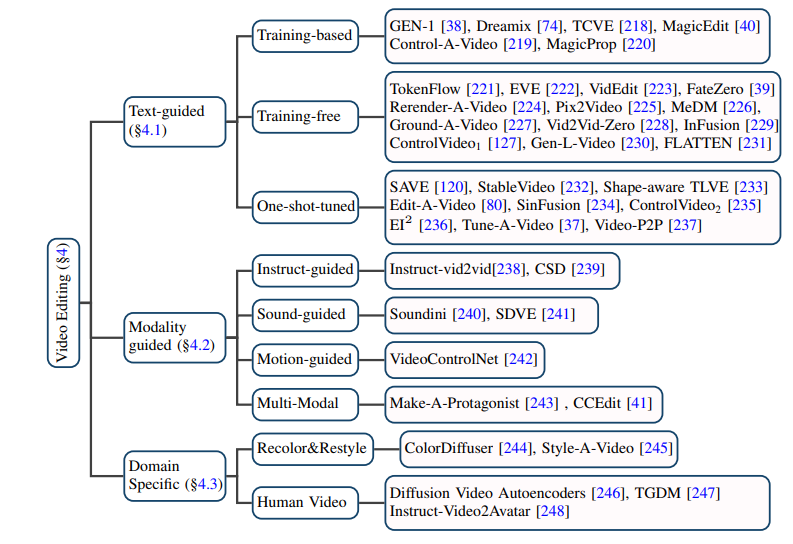

基于文本的视频编辑:考虑到现有文本 - 视频数据规模有限,目前大多数基于文本的视频编辑任务都倾向于利用预训练的 T2I 模型,在此基础上解决视频帧的连贯性和语义不一致性等问题。作者进一步将此类任务细分为基于训练的(training-based)、无需训练的(training-free)和一次性调优的(one-shot tuned)方法,分别加以总结。

基于其他条件的视频编辑:随着大模型时代的到来,除了最为直接的自然语言信息作为条件的视频编辑,由指令、声音、动作、多模态等作为条件的视频编辑正受到越来越多的关注,作者也对相应的工作进行了分类梳理。

特定细分领域的视频编辑:一些工作关注到在特定领域对视频编辑任务有特殊定制化的需求,例如视频着色、人像视频编辑等。

视频理解

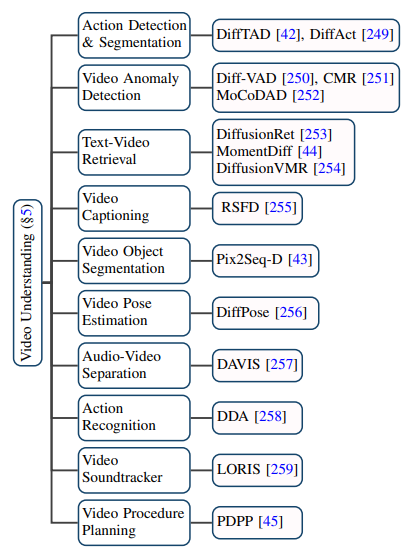

扩散模型在视频领域的应用已远不止传统的视频生成和编辑任务,它在视频理解任务上也展现了出巨大的潜能。通过对前沿论文的追踪,作者归纳了视频时序分割、视频异常检测、视频物体分割、文本视频检索、动作识别等 10 个现有的应用场景。

未来与总结

该综述全面细致地总结了 AIGC 时代扩散模型在视频任务上的最新研究,根据研究对象和技术特点,将百余份前沿工作进行了分类和概述,在一些经典的基准(benchmark)上对这些模型进行比较。此外,扩散模型在视频任务领域也还有一些新的研究方向和挑战,如:

1. 大规模的文本 - 视频数据集收集:T2I 模型的成功离不开数以亿计高质量的文本 - 图像数据集,同样地,T2V 模型也需要大量无水印、高分辨率的文本 - 视频数据作为支撑。

2. 高效的训练和推理:视频数据相比于图像数据规模巨大,在训练和推理阶段所需要的算力也呈几何倍数增加,高效的训练和推理算法能极大地降低成本。

3. 可靠的基准和评价指标:现有视频领域的评价指标往往在于衡量生成视频与原视频在分布上的差异,而未能全面衡量生成视频的质量。同时,目前用户测试仍然是重要的评估方式之一,考虑到其需要大量人力且主观性强,因此迫切需要更为客观全面的评价指标。