广泛使用机器学习不仅仅是它是否有效的问题 - 即使它工作得很好,也很难信任这些模型。当我们的生命、健康或金钱受到威胁时,社会自然会对机器学习持谨慎态度。随着生成型人工智能的突然出现,人们也可能发现很难对生成的内容建立信任。

随着机器学习技术在实际产品和解决方案中的应用,出现了新的挑战。模型在分布发生细微变化时出乎意料地无法泛化;有些模型被发现利用了可能对某些人群造成不公平对待的敏感特征;模型对从未见过的新数据往往表现出过高的自信,或者模型不能有效地与最终用户(如医疗人员)交流其决策背后的理由,从而最大化人机协同的效果。总的来说,我们面临着对当前机器学习技术的信任度问题。目前大部分机器学习研究都致力于扩展“值得信赖的机器学习”(Trustworthy Machine Learning, TML)的研究边界。自2020年以来,TML已成为ICML会议征文的明确主题,还出现了其他与TML主题相关的相对较新的会议,如FAccT和AIES。

此TML教材是图宾根大学同名课程的最终成果,该课程首次提供是在2022/23年的冬季学期。该书覆盖了TML关键主题的理论和技术背景以及潜在的直觉。我们对与相关主题有关的重要的经典和现代研究论文进行了批判性的审查。本书旨在成为一个独立的产品,并伴随有代码片段以及指向TML主题的其他资源的多个指针。

本书的目标是为读者准备批判性地阅读、评估和讨论TML的研究工作。通过提供的代码片段,读者将获得实现基本TML技术的技术背景,并最终在TML中进行自己的研究。本书有以下先决条件:• 熟悉Python和PyTorch编码。• 对机器学习概念和深度学习的基本知识。• 基础数学:多元微积分、线性代数、概率、统计和优化。

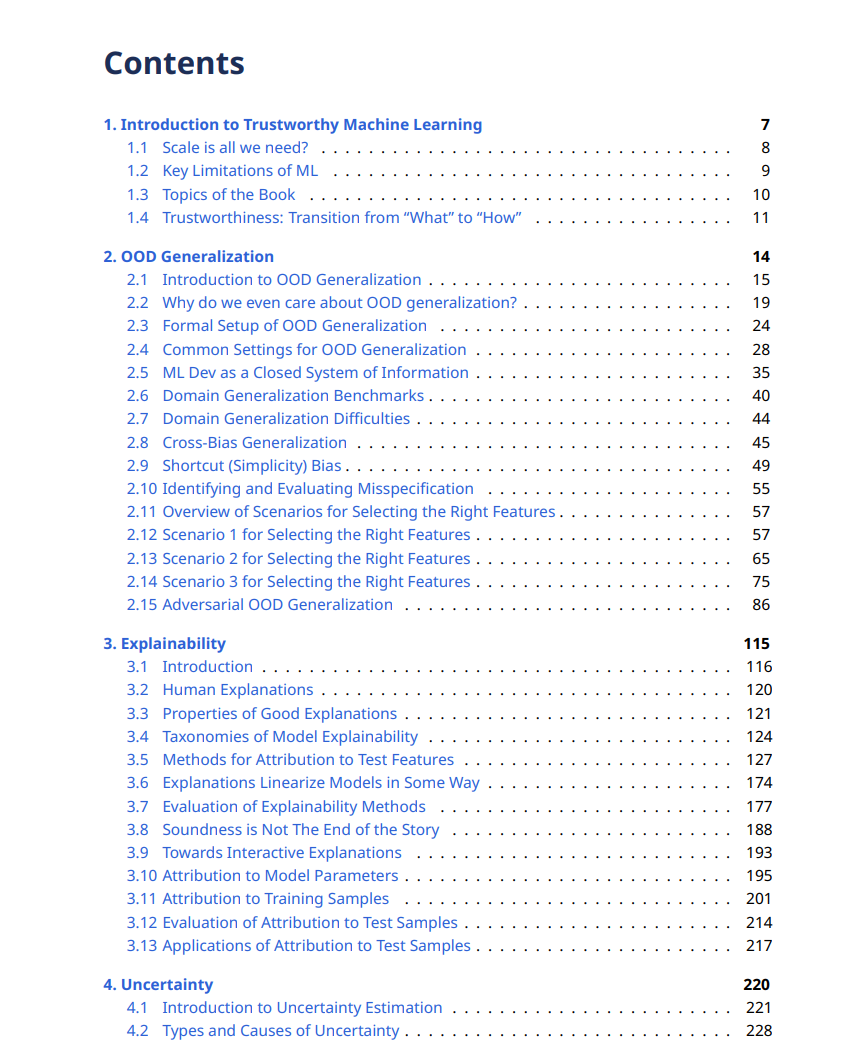

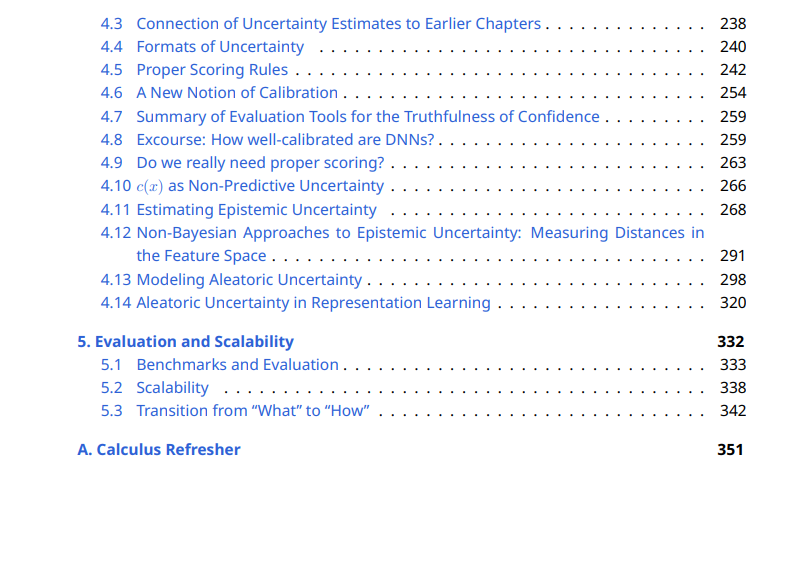

本书涵盖的主题如下:

- 超出分布(OOD)的泛化。我们可以训练一个模型在超出训练分布的情况下表现良好吗?

我们没有涵盖的主题,但也是值得信赖的机器学习的核心部分:

- 公平性。人口差异是公平性的核心关注点,即每个人口亚组的拒绝和接受比例之间的差异。敏感属性的使用(通常是隐式的)也是一个与信任度有关的重要问题。

- 隐私和安全。数据往往是专有的和私有的。如何保护数据安全?我们经常可以反向工程训练集的原始样本,例如在语言模型中。这样,人们也可以获得敏感的私人信息,例如病人的医疗记录。

- 滥用AI工具。人们可以使用ML创建深度伪造,例如交换人们的面孔。通过大型语言模型(LLMs)传播虚假信息也是一个令人担忧的问题。

- 治理。规范AI的使用和明确AI使用的边界非常重要。

作者:

https://trustworthyml.io/

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎注册登录专知www.zhuanzhi.ai,获取100000+AI(AI与军事、医药、公安等)主题干货知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程资料和与专家交流咨询!点击“阅读原文”,了解使用专知,查看获取100000+AI主题知识资料