从Stable Diffusion ChatGPT,再到Midjour-ney V5和GPT-4,过去的一年多里,生成式人工智能在全世界刮起了一股旋风。每一张极度逼真的生成图像、每一段高度类人的生成文本,都昭示着人工智能生成内容(Artificial Intelligence Generated Content,AIGC)时代的到来。人们在为见证生产力革新感到激动的同时,也难免心生忧虑:快速发展的AIGC 技术正在撼动已有的社会信任体系,我们该如何与AIGC“共存”,实现在AIGC时代的“突围”?

在不远的未来,普通人的一天可能是这样度过的(见图1):早上7:00被AI作曲的闹铃叫醒;8:00,听着AI合成语音播报AI撰写的新闻;10:00,开始工作,用AI作画生成创意草图;15:00会议结束时,直接用AI快速总结要点,生成摘要、报表甚至PPT;18:00下班后,在沉浸式AI生成场景中“自娱自乐”;22:00,在夜深人静的时候,与最懂自己的专属AI 数字人畅聊人生……我们未来的所见、所思、所想、所交互,可能都是AI生成的。

图1 AIGC时代普通人的一天畅想

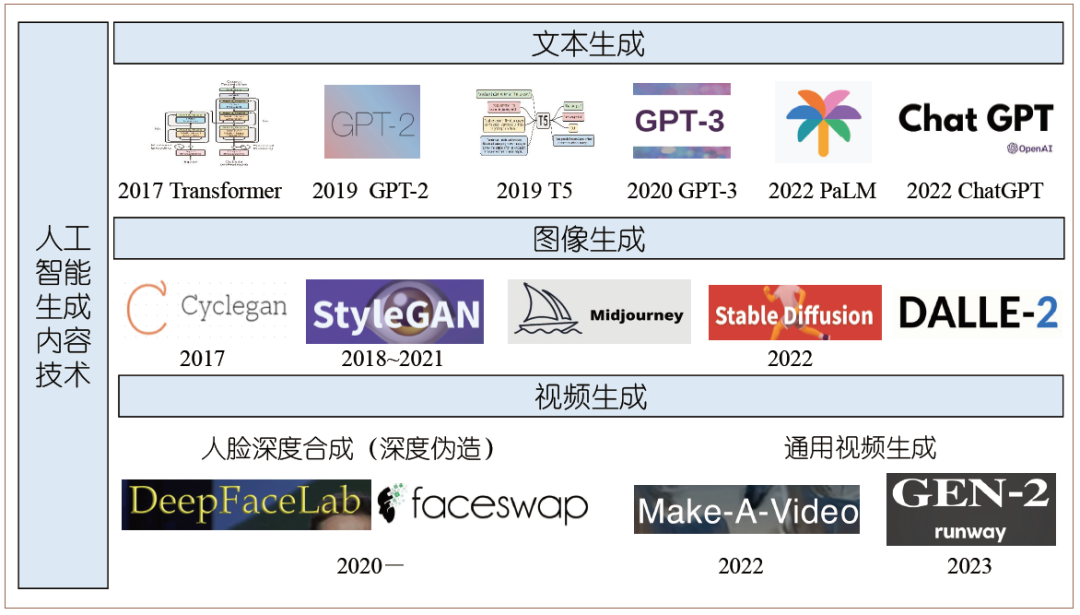

支撑如此多应用快速出现的,正是快速发展的AIGC技术。如图2所示,它包括文本生成技术,从2017年的Transformer网络到最近的ChatGPT服务,文本生成模型甚至已经出现智能“涌现”现象;也包括图像生成技术,从2017年的Cycle-GAN、StyleGAN一直发展到近期火热的扩散模型DALLE-服务等;视频生成方面也从最初专用于人脸深度合成的 DeepFaceLab发展到最新的通用视频生成服务Gen-2。从智能程度来看,视觉生成尚未达到文本生成的效果,但在视觉模态出现“涌现”现象可能也不会太远。

图2 人工智能生成内容技术代表性工作

在短短几年内,生成式人工智能逐渐走到了舞台中央。行业调研机构据此对AIGC时代作出了大胆预测。Gartner公司预测,七年后(2030年),合成数据将成为新增AI训练数据的主要来源,即我们身边的新数据多数将是机器生成的,少数才是人类产生的。《中国AIGC产业全景报告》预测,2023年AIGC市场规模将达人民币170亿元,到2030年市场规模有望达到万亿级。有人直言“未来,得AIGC者得天下”,甚至说“不懂AIGC的人都会被世界淘汰”。虽然可能不至于像上述说法那样夸张,但各种迹象表明:我们正在迈入AIGC时代。

尽管AIGC的正向作用得到了普遍认可,但其负面影响同样引起了关注。由约书亚·本吉奥(Yoshua Bengio)、埃隆·马斯克(Elon Musk)等人联名签署的《AI风险声明》(Statement on AI Risk),将人工智能给人类带来的风险与核战争并列——显然,核武器是不能乱用的。因此,AIGC催生的新兴行业注定是需要强监管的。可以说,AIGC的安全决定了AIGC的应用边界。

与以往的技术相比,AIGC带来了更大的安全风险。不法分子可以基于生成式人工智能技术实现更难防范的伪造:通过人脸生成,可以伪造身份骗过门禁;通过人脸替换,可以借公众人物素材制作色情视频;通过表情操控,可以让任何人说任何话;通过视频生成,可以从无到有捏造并定义所谓的“真相”。

面对这样的信任危机,众多学者表达了对人工智能发展的担忧。2023年3月,数万人签名呼吁,要暂停训练比GPT-4更强的AI系统至少6个月;图灵奖得主杰弗里·辛顿(Geoffrey Hinton)也提到AI对人类生存的威胁,认为AI会变得比人更加聪明并控制人类;考虑到机密泄露和科研诚信风险,三星、软银等大型企业和香港浸会大学等学术机构也禁止员工和学生在工作和学习中使用ChatGPT类服务。

AIGC安全问题可分为两个方面:第一是如何监管AIGC的违规应用,如何应对AIGC给社会、政治、金融、教育带来的危害,这是维护国家安全、社会安全的关键;第二是如何保护AIGC的行业应用成果,如何保障行业有序竞争,保障AI创作成果(如游戏、文学作品、多媒体内容和数字人等)的合理权益,这是行业存亡的关键。可以说,AIGC安全市场是规模较大、门槛较高的蓝海市场。

应对AIGC安全风险,要从技术、应用和制度三个层面突围

在AIGC这条路上,眼前是如此多的富有挑战性的安全问题,远处则是人们向往的美好未来。要想在AIGC时代成功突围,应对这一系列的潜在安全风险,技术、应用和制度三个层面的准备缺一不可。

技术层面:AIGC检测能力尽快基座化,用大模型对抗大模型

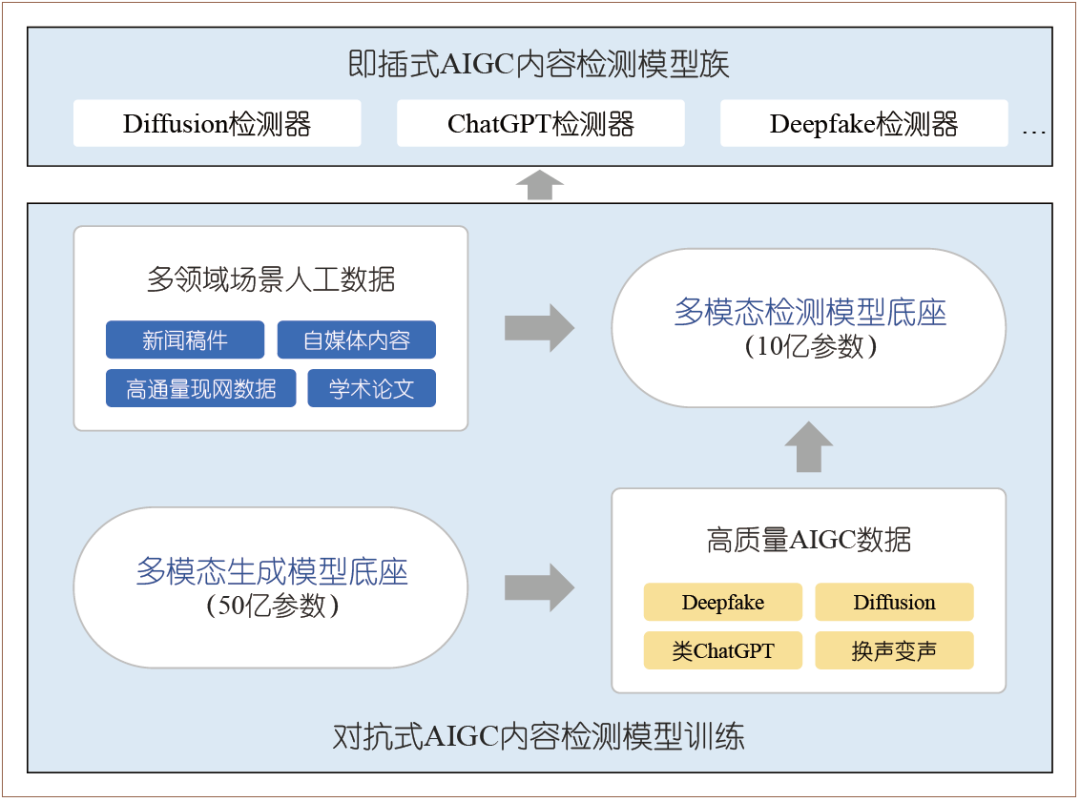

为什么要将检测能力基座化?我们发现,现有伪造检测系统对之前伪造内容检测准确率达到90%以上,但是对基于大模型的Midjourney服务生成的图像,检测效果并不好。这是大模型给现有伪造检测技术体系带来的挑战。上述现象不仅出现在伪造检测任务中,大模型给现有的所有内容安全技术体系也带来了挑战。如何应对?一种可行的思路是用大模型对抗大模型。这一体系包含数据、算法、应用三个层面。如图3所示,我们团队首先构建了一个训练数据自动生成平台,能够快速生成TB级的训练数据,构建了数据底座;其次,基于“生成—检测—对抗”的模型自进化流程,构建了50亿参数多模态生成模型底座和10亿参数多模态检测模型底座;最后,针对行业落地部署,通过快速微调实现了多个行业高精度的伪造检测服务,形成行业数据闭环。基于上述大模型体系,团队构建了一系列针对人工智能生成文本、图像和视频的检测模型:目前,生成文本检测支持跨生成模型和跨领域数据检测,并针对生成新闻以及生成科技文献检测需求开发了行业专用版本;生成图像检测不仅支持检测已有深度伪造内容,也支持检测扩散模型等新技术生成的内容;生成视频检测已在现网环境下规模化部署,实测精度、性能都位居全国前列。

图3 AIGC检测基座示意图

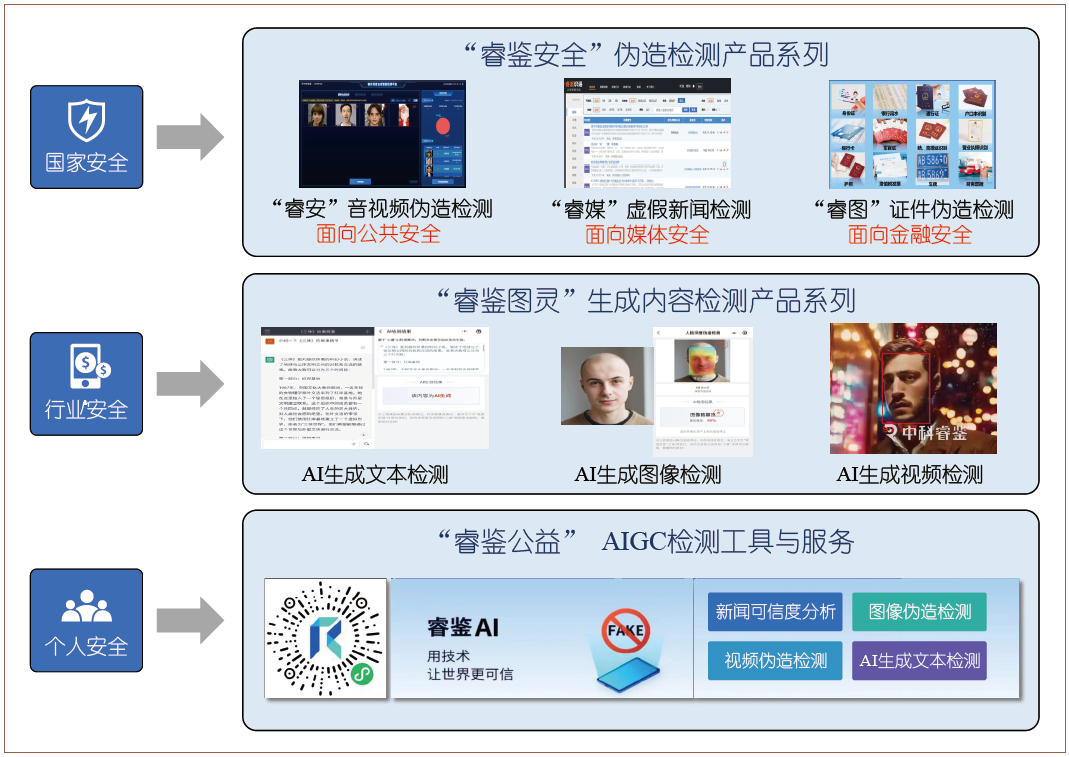

应用层面:像普及AIGC应用一样普及AIGC检测工具,用AI守护AI

针对各类需求研发并普及便捷、高效的AIGC检测工具,是让AIGC安全治理迈向实用的关键。我们从国家安全、行业安全和个人安全三个层面入手,构建了睿鉴AIGC检测工具体系(见图4):面向国家安全需求,推出“睿鉴安全”伪造检测系列产品,包括针对公共安全领域的音视频伪造检测系统、针对媒体安全领域的虚假新闻检测系统和针对金融安全领域的证件伪造检测系统;面向行业安全需求,开发了针对行业大模型生成内容的系列检测产品,包括AI生成文本检测、AI生成图像检测和AI生成视频检测;面向个人安全需求,开发了“睿鉴AI”小程序,让用户可以随时随地查询事件、图片和视频的真伪。普及AIGC检测工具将会有效提高全民的真伪分辨意识,提升公众“安全免疫力”,降低AIGC应用安全风险。

图4 睿鉴AIGC检测工作体系

制度层面:借助法律法规的力量,保障AIGC行业有序繁荣

生成式人工智能应该“有所为、有所不为”。2023年,我国出台的《互联网信息服务深度合成管理规定》和《生成式人工智能服务管理暂行办法》分别自1月10日和8月15日起施行。制度方面的突围对应两大趋势。

第一大趋势是监管覆盖全面化,分阶段、全流程规范AIGC相关要素,具体包括:模型层面,需要进行充分的安全评估;应用层面,需要进行上线前备案;数据层面,需要对生成内容提供明确标识。

第二大趋势是制度层面多样化,不仅仅是依靠技术安全规章制度,还要进一步丰富AIGC制度体系。相关行业将在规章制度基础上提出行业倡议,规范行业秩序。例如,抖音发布了《关于人工智能生成内容的平台规范暨行业倡议》;Adobe公司发起了“内容真实性计划”(Content Authentici-ty Initiative);德国学者倡议使用“AI使用记录卡”主动汇报生成内容使用等。再进一步,甚至可以缔结人类国际公约,以约束AIGC在人类可控的范围内安全发展。2023年5月22日,OpenAI三位联合创始人发表署名文章,希望各国政府考虑按照核武器监管模式,组建人工智能行业的“国际原子能机构”,为该行业制定全球规则。

面对AIGC应用迅猛的发展势头,AIGC安全治理必须快速跟进。学术界、产业界和管理机构要通力合作,打出技术、应用和制度的组合拳,快速精准地建立起AIGC安全防护体系,为行业、国家乃至人类社会保驾护航。

CCF高级会员。中国科学院计算技术研究所研究员。中科睿鉴科技有限公司创始人。主要研究方向为数字内容合成与伪造检测、人工智能安全。caojuan@ict.ac.cn

CCF学生会员。中国科学院计算技术研究所特别研究助理。主要研究方向为虚假新闻检测、大模型内容安全治理。shengqiang18z@ict.ac.cn