本文研究内容来自加州大学尔湾分校(UC Irvine)的一个专攻自动驾驶和智能交通的安全研究团队。该团队一项工作的成果报告在8月13日正式发表在USENIX Security 2021(计算机安全四大顶会之一),且该工作的早期版本获得了NDSS 2020(计算机安全四大顶会之一)Best Technical Poster Award。

研究主要展示了产品级L2自动驾驶系统中的自动车道居中辅助系统(ALC,Automated Lane Centering)的安全。L2自动驾驶车通常利用深度神经网络(DNN)的车道检测来实现ALC。由于DNN模型对对抗性样本攻击的脆弱性已被广泛报道,该团队首次在物理世界对抗性样本攻击下对最先进的基于DNN的ALC系统在其运行设计域(即具有完整车道线的道路)中进行了安全分析。

研究发现,DNN模型层面的漏洞可以导致整个 ALC 系统层面的攻击效果。团队设计了脏路补丁(DRP)攻击,即通过在车道上部署,添加了对抗样本攻击生成的路面污渍图案的道路补丁,便可误导OpenPilot (开源的产品级驾驶员辅助系统) ALC系统,并使车辆在1秒内就偏离其行驶车道,远低于驾驶员的平均接管反应时间(2.5 秒),造成严重交通危害。相关材料详见本文最后。

作者:Takami Sato*, Junjie Shen*, Ningfei Wang, Yunhan Jack Jia, Xue Lin, Qi Alfred Chen (* Co-first Authors)

研究工作概览和亮点

ALC是一种L2自动驾驶技术,可自动控制车辆方向盘以使其保持在车道中心。由于其提供的高度便利性,现如今它被广泛应用于各种车型中,例如特斯拉、通用凯迪拉克、本田雅阁、丰田RAV4、沃尔沃XC90等。尽管方便,但ALC系统需要具有较高的安全性:当ALC系统做出错误的转向决策时,人类驾驶员可能没有足够的反应时间来防止即将发生的安全隐患,例如开出路面或与相邻车道上的车辆相撞。因此,了解ALC系统的安全属性势在必行。

在ALC系统中,最关键的一步是车道线检测,它通常由基于深度神经网络(DNN)的车道线检测模型来实现。最近很多研究表明,DNN容易受到物理世界对抗性攻击,例如在交通标志上贴恶意贴纸。然而,由于两个主要的设计挑战,这些方法不能直接应用于攻击ALC系统。

(1) 在ALC系统中,由于车辆行驶轨迹受攻击影响,相机的视角会逐渐向左或右偏移,捕捉不同的道路区域。所以在攻击生成的过程中需要考虑相机图片中每帧之间的相互依赖性。

(2) 前人研究中的攻击优化目标函数主要针对图像分类或目标检测模型,并不能直接应用到车道线检测的这类回归模型上。

为了填补这一关键的研究空白,在这项工作中,该团队首次在物理世界对抗性攻击下对最先进的基于DNN的ALC系统在其「运行设计域(即具有完整车道线的道路)」中进行了安全分析。用一个新颖的领域特定的攻击向量:「脏路补丁(DRP,Dirty Road Patches)」(如图1所示)。

之所以选择脏路补丁是因为现实生活中这类路面污渍非常普遍,如果攻击生成的脏路补丁类似此类路面污渍,就会较难引起人类驾驶员注意,从而让攻击更加隐蔽。图2是研究团队在加州尔湾市附近收集到的一些路面污渍图片。

图1:易于部署的路面补丁和现实生活中常见的路面污渍图案

图2:加州尔湾市附近的路面污渍例子

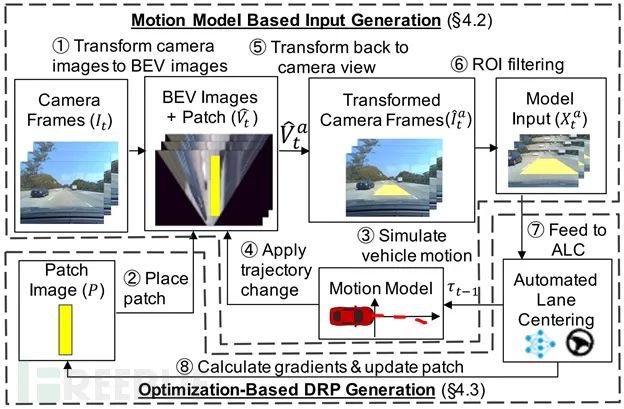

为了系统地生成脏路补丁,团队采用基于优化的方法并克服上述设计挑战。图3展示了DRP攻击生成脏路补丁的流程。为了实现更高的隐蔽性和易部署性,在脏路补丁生成过程中添加多种限制,包括(1)限制路面污渍图案为灰度图案,(2)限制亮度,(3)保证车道本身的道路线不被改变,(4)限制路面污渍图案区域等。

图3:DRP攻击的脏路补丁生成流程

为了了解DRP攻击在物理世界中的可实现性和严重性,团队在一个微缩测试场景中放置了打印的脏路补丁,并用OpenPilot官方设备(EON)进行评估(图4)。

发现DRP攻击可以导致OpenPilot的道路线检测严重出错,例如图3中,添加了脏路补丁后,车道线会非常明显地偏向左边,而正常道路下检测出来的车道线和真实车道线重合度非常高。为了验证DRP攻击的鲁棒性,团队成员测试了27种不同驶入角度和横向偏移的组合,发现DRP攻击仍能保持非常高(>=95%)的攻击成功率。

图4:微缩测试场景和结果(攻击演示视频)

为了了解针对L2自动驾驶系统端到端的安全影响,研究团队使用产品级的自动驾驶模拟器LGSVL进一步评估DRP攻击(图5)。在100次运行中,脏路补丁对部署了OpenPilot的自动驾驶车造成100%的车辆碰撞率。相比之下,正常道路的碰撞率为0%。

图5:仿真验证结果(攻击演示视频)

为了了解现有的车辆主动安全技术对DRP攻击的影响,如图6所示,团队成员将攻击数据(即受攻击时的到路线检测结果)直接注入到部署了OpenPilot的真车(2019年款丰田凯美瑞)上,测试车辆受攻击情况下能否真正偏出车道并撞上障碍物(纸箱)。

尽管该车本身自带车道偏移预警(LDW),自动紧急刹车(AEB)和前方碰撞预警(FCW)等主动安全技术,在10次试验中我们发现DRP攻击可以造成100%的碰撞率,并且LDW从未被触发。其中,FCW被触发了5次,但是由于FCW只起到预警作用,并未能防止碰撞的发生。另外FCW的平均触发时间是在碰撞发生前0.46秒,相比于人类驾驶员的2.5秒平均反应时间,绝大部分驾驶员就算想要接管车辆也太晚了。

图6:基于注入攻击数据的真车碰撞试验(演示视频)

在该团队的论文中,还探讨可能的防御措施,比如基于DNN对抗样本攻击的防御措施和基于传感器/数融合的防御措施。团队评估了DRP在五种常见的防御DNN对抗样本攻击的方法下的有效性,比如添加高斯噪声、JPEG的压缩等等,但发现由于这些防御都是针对像素级别人眼不可见的DNN攻击的,他们对于物理世界模仿自然污渍的攻击并不奏效。

对于基于传感器/数据融合的防御措施,主要问题是成本太高且难以扩展,比较难在短期内部署。由于需要更多的研究来实现这样的防御措施,该团队提出了短期缓解措施:建议至少应该把路面污渍和脏路补丁放到ALC系统现阶段不可处理的场景列表中。

该团队检查了11家公司的ALC手册(例如特斯拉、通用Cruise、OpenPilot、本田Sensing和丰田LTA),目前没有一家公司在他们不可处理的场景列表中列出 路面污渍或脏路补丁。该团队认为,这种明确在手册中提及的方法至少可以有助于用户提前认识到风险,从而更可能主动观察去避免遭到DRP攻击。

常见问题与解答

(以下是整理出的最常被问到的问题,团队的目网站上还有更多Q&A)

Q:DRP攻击仅针对OpenPilot ALC吗?

A:并不是。我们认为我们的研究成果可以帮助提高大家对于目前产品级ALC系统安全性的理解。此外,由于 DNN 通常被认为易受对抗性攻击,如果其他厂商的 ALC 系统也采用基于 DNN 的设计,至少在设计层面它们也会受DRP攻击影响。

Q: 攻击者能否直接在路面上画假的车道线来实现相同的攻击效果?

A: 基于车道线检测的本质,在道路上画一条线确实可以成为有效的攻击方式。但是,驾驶员可以很容易地识别这类绘制的车道线并立即接管驾驶。此外,我们的实验过程中将这类直接画车道线的攻击手段作为对比,发现DRP攻击的攻击成功率远高于这类攻击手段(比如同样情况下DRP成功率是82.5%时该攻击手段只有13.75%成功率),详见论文的第5.2节。

Q:如何防御DRP攻击?

A:正如我们研究中发现,目前还没有一种基于模型的防御手段能够有效防御DRP攻击而不降低ALC 在正常驾驶场景中的性能。其他可能的防御手段还包括类似L4自动驾驶系统所使用的多传感器融合。但目前激光雷达对于L2自动驾驶车辆的商用来说仍然太贵。此外,车道线检测与地图数据的融合也是比较有希望的防御手段。但是,目前L2自动驾驶系统的定位无法实现像L4一样的厘米级定位精度。因此,一个后续研究问题是如何有效地检测DRP攻击而不造成太多误报。

Q:我们有对无人车公司进行漏洞报告吗?他们是怎么答复的?

A:我们于 2020 年 8 月向 13 家正在研发 ALC 系统的公司进行了第一轮漏洞报告。这个过程中,我们把该漏洞的攻击方式和可能的防御手段详细告知了每家公司。其中 10 家公司回复说他们已经开始着手调查该漏洞,有些公司已经与我们开会以实施该调查。我们目前正在跟进这些公司的最新评估结果。

关于我们

本次研究作者团队,来自加州大学尔湾分校、字节跳动和美国东北大学,一共6名研究人员。其中两位共同第一作者Takami Sato和Junjie Shen。三作Ningfei Wang和Qi Alfred Chen教授均来自加州大学尔湾分校Yunhan Jack Jia研究员任职于字节跳动,Xue Lin教授任职于美国东北大学。

相关材料

项目网站和攻击演示视频:https://sites.google.com/view/cav-sec/drp-attack

USENIX Security文章页面:https://www.usenix.org/conference/usenixsecurity21/presentation/sato

arXiv版本:https://arxiv.org/abs/2009.06701

演讲视频:https://drive.google.com/file/d/1VXQkyU1BTZdDGqmSZjsJ4VMdWNqYmwEG/vi

ew?usp=sharing

PPT:https://drive.google.com/file/d/1dQWcbFVQ4v2YSEpc_OXAM4Oqtz-zIlNr/view?u

sp=sharing