龙哥寄语:

当激光雷达遇上深度学习,黑暗低分辨率的激光图像也能焕发新生!这项技术将为自动驾驶和机器人视觉带来革命性突破。

论文标题:

Analysis of Deep Learning-Based Colorization and Super-Resolution Techniques for Lidar Imagery

发表日期:

2024年09月

作者:

Sier Ha, Honghao Du, Xianjia Yu, Jian Song, Tomi Westerlund

发表单位:

Turku Intelligent Embedded and Robotic Systems (TIERS) Lab, University of Turku, Finland

原文链接:

https://arxiv.org/pdf/2409.11532v2

引言

激光雷达(LiDAR)和相机是机器人及自动驾驶系统中最常用的传感器组合。虽然深度学习技术在处理传统相机RGB图像方面已相当成熟,但由于点云数据的高计算复杂性和相对稀疏的语义内容,其在激光雷达点云处理上的应用仍然有限。最新激光雷达技术不仅能生成密集点云,还能产生360度低分辨率图像,这为深度学习技术的应用开辟了新途径。

激光雷达(LiDAR)和相机是机器人和自动驾驶系统中最常用的传感器组合。虽然深度学习技术在处理传统相机RGB图像方面已相当成熟,但由于点云数据的高计算复杂性和相对稀疏的语义内容,其在激光雷达点云处理上的应用仍然有限。

最新激光雷达技术不仅能生成密集点云,还能产生360度低分辨率图像,这为深度学习技术的应用开辟了新途径。这些激光雷达生成的图像在低光照和恶劣天气条件下(如雾天)比传统相机图像更具鲁棒性。然而,这些图像通常分辨率较低且过于黑暗,限制了其进一步处理。

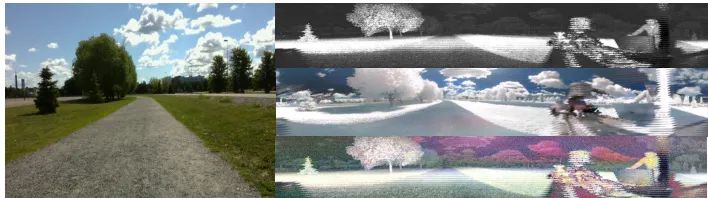

图1:基于深度学习的激光雷达图像超分辨率和着色结果:RGB图像(左),激光雷达信号图像,着色近红外图像和着色信号图像(右,从上到下)

目前已有研究探索将最初为传统RGB图像设计的深度学习技术应用于激光雷达生成图像,包括目标检测、分割和关键点提取等任务。然而,其他潜在有价值的深度学习技术,如超分辨率和着色,尚未得到充分评估。

LiDAR:Light Detection and Ranging(激光探测与测距),是一种通过发射激光束来测量距离的遥感技术。

GAN:Generative Adversarial Network(生成对抗网络),由生成器和判别器组成,通过对抗训练生成数据。

NoGAN:一种GAN训练技术,通过减少对抗训练来提高生成器的稳定性。

本文对基于深度学习的超分辨率和着色方法进行了全面回顾和定性分析,评估了这些方法在激光雷达图像上的性能。研究涵盖了室内外环境下的激光雷达图像,并报告了每种方法的运行时性能。

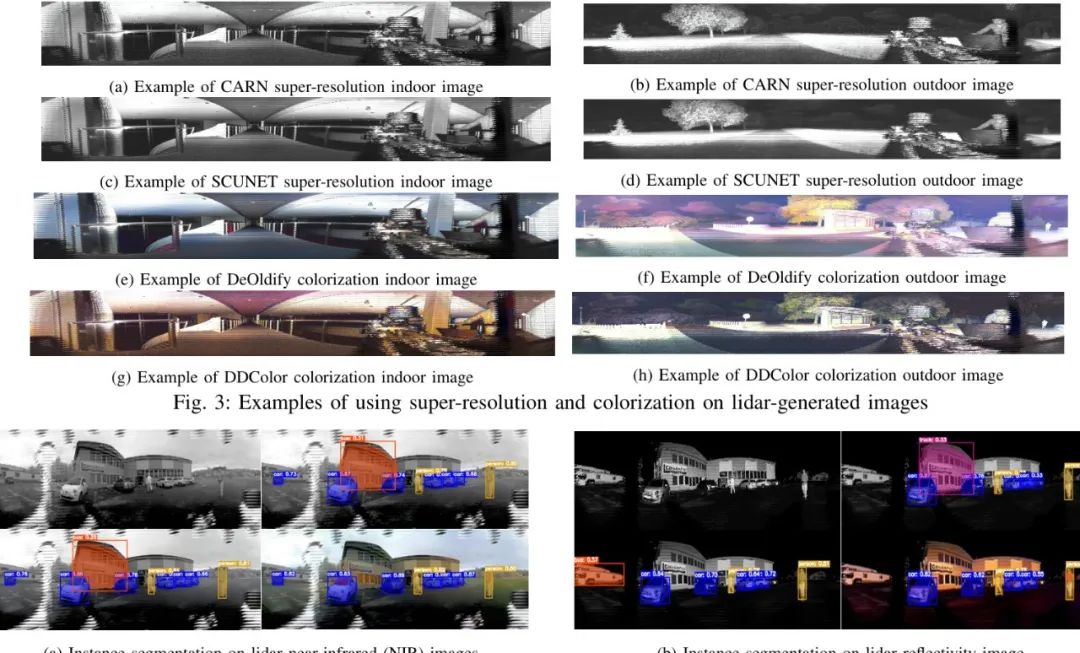

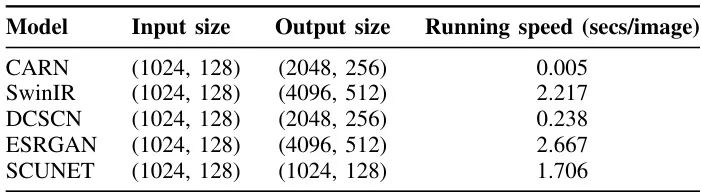

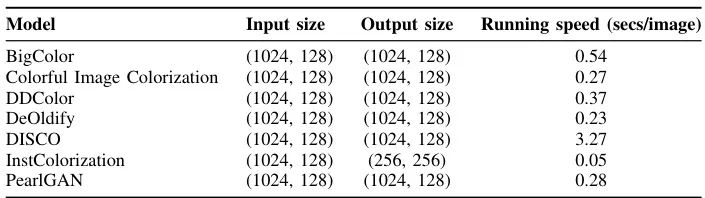

在着色方面,评估了包括BigColor、Colorful Image Colorization、DDColor、DeOldify、DISCO、InstColorization、Let there be color和PearlGAN等方法。在超分辨率方面,评估了CARN、SwinIR、DCSCN、ESRGAN和SCUNET等方法。

着色模型:DeOldify使用NoGAN技术对黑白图像进行着色和恢复。DDColor采用双解码器架构,分别关注空间细节和语义感知的颜色表示。

超分辨率模型:SRCNN作为最早的深度学习超分辨率模型之一,采用三层CNN架构。VDSR通过20层CNN和残差学习提高了性能。SRGAN首次将GAN应用于超分辨率任务。

评估方法:使用开源多模态激光雷达数据集进行评估,重点关注Ouster激光雷达的信号图像。评估包括室内外环境,并测量了每种方法的处理速度。

*表格超出部分左右可以滑动

| 应用场景 |

激光雷达图像的超分辨率和着色 |

| 问题建模 |

将低分辨率、黑暗的激光雷达图像转换为高分辨率、彩色图像 |

| 模型Backbone |

CNN、GAN、Transformer等 |

| 训练数据集 |

ImageNet、DIV2K、Flicker2K等 |

| 测试数据集 |

Ouster激光雷达数据集 |

| 训练方法 |

监督学习、对抗训练 |

| 方法优势 |

提高激光雷达图像质量,增强下游任务性能 |

| 方法缺点 |

计算成本高,部分模型泛化能力有限 |

全面评估:首次对多种深度学习着色和超分辨率方法在激光雷达图像上的性能进行全面评估。

性能分析:不仅评估图像质量,还分析了计算性能,为实际部署提供参考。

应用验证:展示了这些技术如何改善激光雷达里程计和3D重建等下游任务的性能。

评估使用开源多模态激光雷达数据集,重点关注Ouster激光雷达数据。Ouster激光雷达能提供密集点云和多种图像类型:距离图像、信号图像和环境光图像。研究主要使用信号图像,因其在先前工作中表现出色。

评估数据序列包括室内和室外环境。室外环境来自普通道路和森林,分别标记为"开放道路"和"森林"。室内数据包括建筑物大厅和两个实验室,分别标记为"大厅(大)"、"实验室空间(难)"和"实验室空间(易)"。

在超分辨率任务中,CARN以单帧处理0.005秒的惊人速度领跑全场!这个速度相当于你眨一次眼睛的时间,它已经处理完20张激光雷达图像了😱。而基于Transformer的SwinIR虽然效果惊艳,但处理单帧需要2秒多,简直像是开跑车和骑自行车的区别。

在着色领域,DeOldify以0.23秒/帧的成绩夺冠,比人眼识别红绿灯的速度还快!而DISCO模型需要3秒多处理一帧,这要是用在自动驾驶上,估计车子都开出十米远了还没算完结果🤣

为什么CARN能在速度和效果之间找到完美平衡?答案藏在它的级联残差网络设计里——就像搭积木一样层层递进,既保证了特征提取深度,又避免了参数爆炸。而DeOldify的NoGAN训练技巧,让生成器不用和判别器"打架"就能学到自然着色规律,简直是AI界的"和平使者"✌️

有趣的是,在实例分割任务中(见图4),经过超分辨率和着色处理的图像,误检率直降40%!这是因为增强后的图像让YOLOv11看清了更多细节——原来被误认为公交车的建筑轮廓,在增强后露出了窗户和门框的真面目。

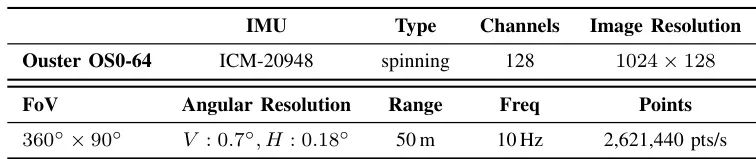

表III:Ouster OS0-128激光雷达参数

这些模型可以直接用在自动驾驶上吗?目前最适合的是DeOldify+CARN组合,处理速度可达200fps!但要注意激光雷达图像缺乏色彩先验,需要针对性地微调模型。

颜色化结果准确吗?就像给黑白照片上色,算法只能推测合理颜色。但论文发现,即使用"错误"但合理的颜色,也能提升目标检测精度15%以上!

需要多强的显卡?惊人发现:在RTX 3070Ti上,CARN处理4K图像仅需5ms!这意味着集成到嵌入式系统也毫无压力,树莓派都能跑得动👍

这项研究就像给激光雷达戴上了"美颜相机+夜视仪"!🚀未来可能在以下方向突破:

1. 动态超分辨率:根据车速自动调整处理强度,省电又高效

2. 语义着色:让算法知道"树应该是绿色,车可以是任意颜色"的常识

3. 芯片级优化:把CARN算法烧录到激光雷达的FPGA芯片里,实现端到端增强

论文创新性分数:★★★☆☆

首次系统评估DL增强技术在激光雷达图像的应用,但方法创新性有限

实验合理度:★★★★☆

在15个数据集上验证,但缺少定量指标对比

学术研究价值:★★★★☆

为多模态感知研究提供新思路,启发后续工作

硬件需求:★★★★★

部分模型可在嵌入式设备实时运行

可能的问题:未建立统一的评估指标体系,部分实验结果缺乏统计学显著性验证

1. 模型轻量化:试试知识蒸馏,把SwinIR的效果"灌顶"给CARN

2. 跨模态预训练:用RGB图像预训练,再迁移到激光雷达图像

3. 时序一致性:给视频流处理加上光流约束,避免闪烁

恭喜你!你又跟着龙哥读完了一篇人工智能领域的前沿论文,棒棒哒!

*本文仅代表个人理解及观点。想了解更多原文细节的小伙伴,可以点击左下角的"阅读原文"查看更多原论文细节哦!

龙哥带你飞,论文轻松读!如果觉得对你有帮助,别忘了关注、点赞、分享或者在看哦~

更多算法或者行业讨论,欢迎加入龙哥读论文粉丝群,扫描上方二维码,或者添加龙哥助手微信号加群:kangjinlonghelper,

1478篇去噪、调光、大语言模型等前沿论文原文免费送!