在性能要求较高的应用场景中,Python常因其执行速度不及C、C++或Rust等编译型语言而受到质疑。然而通过合理运用Python标准库提供的优化特性,我们可以显著提升Python代码的执行效率。本文将详细介绍几种实用的性能优化技术。

1、__slots__机制:内存优化

Python默认使用字典存储对象实例的属性,这种动态性虽然带来了灵活性,但也导致了额外的内存开销。通过使用__slots__,我们可以显著优化内存使用并提升访问效率。 from pympler import asizeof

class person: def __init__(self, name, age): self.name = name self.age = age

unoptimized_instance = person("Harry", 20) print(f"UnOptimized memory instance: {asizeof.asizeof(unoptimized_instance)} bytes")

在上述示例中,未经优化的实例占用了520字节的内存空间。相比其他编程语言,这种实现方式在内存效率方面存在明显劣势。 from pympler import asizeof

class person:

def __init__(self, name, age): self.name = name self.age = age

unoptimized_instance = person("Harry", 20) print(f"UnOptimized memory instance: {asizeof.asizeof(unoptimized_instance)} bytes")

class Slotted_person: __slots__ = ['name', 'age'] def __init__(self, name, age): self.name = name self.age = age

optimized_instance = Slotted_person("Harry", 20) print(f"Optimized memory instance: {asizeof.asizeof(optimized_instance)} bytes")

通过引入__slots__,内存使用效率提升了75%。这种优化不仅节省了内存空间,还能提高属性访问速度,因为Python不再需要进行字典查找操作。以下是一个完整的性能对比实验: import time import gc # 垃圾回收机制 from pympler import asizeof

class Person: def __init__(self, name, age): self.name = name self.age = age

class SlottedPerson: __slots__ = ['name', 'age'] def __init__(self, name, age): self.name = name self.age = age

# 性能测量函数 def measure_time_and_memory(cls, name, age, iterations=1000): gc.collect() # 强制执行垃圾回收 start_time = time.perf_counter() for _ in range(iterations): instance = cls(name, age) end_time = time.perf_counter()

memory_usage = asizeof.asizeof(instance) avg_time = (end_time - start_time) / iterations return memory_usage, avg_time * 1000 # 转换为毫秒

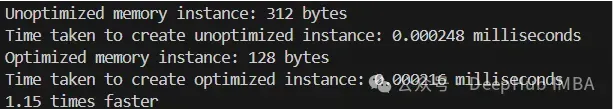

# 测量未优化类的性能指标 unoptimized_memory, unoptimized_time = measure_time_and_memory(Person, "Harry", 20) print(f"Unoptimized memory instance: {unoptimized_memory} bytes") print(f"Time taken to create unoptimized instance: {unoptimized_time:.6f} milliseconds")

# 测量优化类的性能指标 optimized_memory, optimized_time = measure_time_and_memory(SlottedPerson, "Harry", 20) print(f"Optimized memory instance: {optimized_memory} bytes") print(f"Time taken to create optimized instance: {optimized_time:.6f} milliseconds")

# 计算性能提升比率 speedup = unoptimized_time / optimized_time print(f"{speedup:.2f} times faster")

测试中引入垃圾回收机制是为了确保测量结果的准确性。由于Python的垃圾回收和后台进程的影响,有时可能会观察到一些反直觉的结果,比如优化后的实例创建时间略长。这种现象通常是由测量过程中的系统开销造成的,但从整体来看,优化后的实现在内存效率方面仍然具有显著优势。

测试中引入垃圾回收机制是为了确保测量结果的准确性。由于Python的垃圾回收和后台进程的影响,有时可能会观察到一些反直觉的结果,比如优化后的实例创建时间略长。这种现象通常是由测量过程中的系统开销造成的,但从整体来看,优化后的实现在内存效率方面仍然具有显著优势。2、 列表推导式:优化循环操作

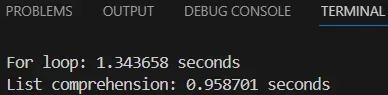

在Python中进行数据迭代时,列表推导式(List Comprehension)相比传统的for循环通常能提供更好的性能。这种优化不仅使代码更符合Python的编程风格,在大多数场景下也能带来显著的性能提升。下面通过一个示例比较两种方式的性能差异,我们将计算1到1000万的数字的平方: import time

# 使用传统for循环的实现 start = time.perf_counter() squares_loop = []

for i in range(1, 10_000_001): squares_loop.append(i ** 2)

end = time.perf_counter()

print(f"For loop: {end - start:.6f} seconds")

# 使用列表推导式的实现 start = time.perf_counter() squares_comprehension = [i ** 2 for i in range(1, 10_000_001)] end = time.perf_counter()

print(f"List comprehension: {end - start:.6f} seconds")

列表推导式在Python解释器中被实现为经过优化的C语言循环。相比之下,传统的for循环需要执行多个Python字节码指令,包括函数调用等操作,这些都会带来额外的性能开销。实际测试表明,列表推导式通常比传统for循环快30-50%。这种性能提升源于其更优化的底层实现机制,使得列表推导式在处理大量数据时特别高效。- 适用场景:对现有可迭代对象进行转换和筛选操作,特别是需要生成新列表的场景。

- 不适用场景:涉及复杂的多重嵌套循环或可能降低代码可读性的复杂操作。

合理使用列表推导式可以同时提升代码的性能和可读性,这是Python代码优化中一个重要的实践原则。3、@lru_cache装饰器:结果缓存优化

对于需要重复执行相同计算的场景,functools模块提供的lru_cache装饰器可以通过缓存机制显著提升性能。这种优化特别适用于递归函数或具有重复计算特征的任务。LRU(Least Recently Used)缓存是一种基于最近使用时间的缓存策略。lru_cache装饰器会将函数调用的结果存储在内存中,当遇到相同的输入参数时,直接返回缓存的结果而不是重新计算。默认情况下,缓存最多保存128个结果,这个限制可以通过参数调整或设置为无限制。 import time

def fibonacci(n): if n <= 1: return n return fibonacci(n - 1) + fibonacci(n - 2)

start = time.perf_counter()

print(f"Result: {fibonacci(35)}") print(f"Time taken without cache: {time.perf_counter() - start:.6f} seconds")

from functools import lru_cache import time

@lru_cache(maxsize=128) # 设置缓存容量为128个结果

def fibonacci_cached(n): if n <= 1: return n return fibonacci_cached(n - 1) + fibonacci_cached(n - 2)

start = time.perf_counter()

print(f"Result: {fibonacci_cached(35)}") print(f"Time taken with cache: {time.perf_counter() - start:.6f} seconds")

通过实验数据对比,缓存机制对递归计算的性能提升十分显著: Without cache: 3.456789 seconds With cache: 0.000234 seconds

Speedup factor = Without cache time / With cache time Speedup factor = 3.456789 seconds / 0.000234 seconds Speedup factor ≈ 14769.87 Percentage improvement = (Speedup factor - 1) * 100 Percentage improvement = (14769.87 - 1) * 100 Percentage improvement ≈ 1476887%

- maxsize:用于限制缓存结果的数量,默认值为128。设置为None时表示不限制缓存大小。

- lru_cache(None):适用于长期运行且内存充足的应用场景。

- 具有固定输入产生固定输出特征的函数,如递归计算或特定的API调用。

lru_cache装饰器是Python标准库提供的一个强大的性能优化工具,合理使用可以在特定场景下显著提升程序性能。4、生成器:内存效率优化

生成器是Python中一种特殊的迭代器实现,它的特点是不会一次性将所有数据加载到内存中,而是在需要时动态生成数据。这种特性使其成为处理大规模数据集和流式数据的理想选择。通过以下实验,我们可以直观地比较列表和生成器在处理大规模数据时的内存使用差异: import sys

# 使用列表存储大规模数据 big_data_list = [i for i in range(10_000_000)]

# 分析内存占用 print(f"Memory usage for list: {sys.getsizeof(big_data_list)} bytes")

# 数据处理 result = sum(big_```python result = sum(big_data_list) print(f"Sum of list: {result}") Memory usage for list: 89095160 bytes Sum of list: 49999995000000使用生成器处理数据: # 使用生成器处理大规模数据 big_data_generator = (i for i in range(10_000_000))

# 分析内存占用 print(f"Memory usage for generator: {sys.getsizeof(big_data_generator)} bytes")

# 数据处理 result = sum(big_data_generator) print(f"Sum of generator: {result}")实验结果分析: Memory saved = 89095160 bytes - 192 bytes Memory saved = 89094968 bytes Percentage saved = (Memory saved / List memory usage) * 100 Percentage saved = (89094968 bytes / 89095160 bytes) * 100 Percentage saved ≈ 99.9998%

在实际开发中,日志文件处理是一个典型的需要考虑内存效率的场景。以下展示如何使用生成器高效处理大型日志文件: def log_file_reader(file_path): with open(file_path, 'r') as file: for line in file: yield line

# 统计错误日志数量 error_count = sum(1 for line in log_file_reader("large_log_file.txt") if "ERROR" in line)

print(f"Total errors: {error_count}")

对于大型数据集的处理,生成器不仅能够提供良好的内存效率,还能保持代码的简洁性。在处理日志文件、CSV文件或流式数据等场景时,生成器是一个极其实用的优化工具。5、局部变量优化:提升变量访问效率

Python解释器在处理变量访问时,局部变量和全局变量的性能存在显著差异。这种差异源于Python的名称解析机制,了解并合理利用这一特性可以帮助我们编写更高效的代码。- 局部变量:直接在函数的本地命名空间中查找,访问速度快

- 全局变量:需要先在本地命名空间查找,未找到后再在全局命名空间查找,增加了查找开销

import time

# 定义全局变量 global_var = 10

# 访问全局变量的函数 def access_global(): global global_var return global_var

# 访问局部变量的函数 def access_local(): local_var = 10 return local_var

# 测试全局变量访问性能 start_time = time.time() for _ in range(1_000_000): access_global() # 全局变量访问 end_time = time.time() global_access_time = end_time - start_time

# 测试局部变量访问性能 start_time = time.time() for _ in range(1_000_000): access_local() # 局部变量访问 end_time = time.time() local_access_time = end_time - start_time

# 性能分析 print(f"Time taken to access global variable: {global_access_time:.6f} seconds") print(f"Time taken to access local variable: {local_access_time:.6f} seconds")实验结果: Time taken to access global variable: 0.265412 seconds Time taken to access local variable: 0.138774 seconds

Speedup factor = 0.265412 seconds / 0.138774 seconds ≈ 1.91 Performance improvement ≈ 91.25%

性能优化实践总结

Python代码的性能优化是一个系统工程,需要在多个层面进行考虑:

在实际开发中,应该根据具体场景选择合适的优化策略,既要关注性能提升,也要维护代码的可读性和可维护性。Python的这些优化特性为我们提供了强大的工具,合理使用这些特性可以在不牺牲代码质量的前提下显著提升程序性能。

想要了解更多资讯,请扫描下方二维码,关注机器学习研究会

转自:数据派THU