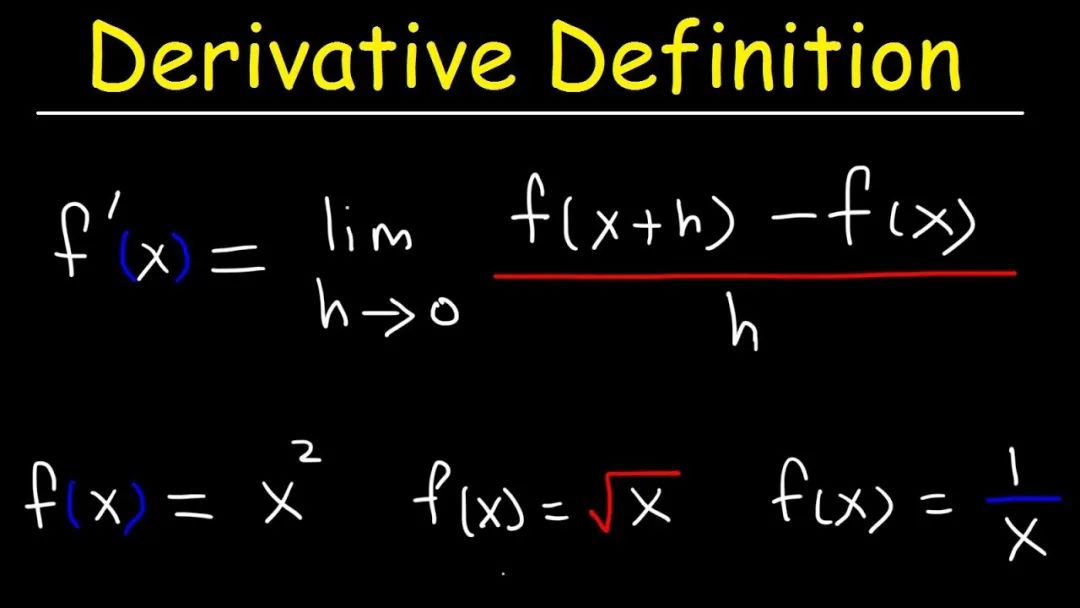

导数计算的是损失函数关于单个参数的瞬时变化率,即在该参数点处,损失函数值随参数微小变化而变化的快慢。而梯度则是一个向量,它综合了损失函数关于所有参数的偏导数,指示了在参数空间的当前位置上,损失函数值增加最快的方向。在梯度下降法中,我们关注的是梯度的反方向,因为这个方向是损失函数值减小最快的方向。通过沿着这个方向迭代地更新参数,我们可以逐渐逼近损失函数的最小值,从而优化模型。导数(Derivative)是什么?在数学中,导数表示一个函数在某一点的变化率,即函数值随自变量变化的瞬时速率。对于一元函数,导数通常表示为 f'(x) 或 df/dx,其中 f 表示函数,x 表示自变量。对于一元函数,导数表示函数图像在某一点的切线斜率,反映了函数在该点沿坐标轴方向的变化快慢。

在梯度下降法中,导数(或偏导数)用于计算损失函数关于模型参数的梯度。偏导数是描述多变量函数在某一点处,当其他变量保持恒定时,关于其中一个变量的变化率。在梯度下降算法中,偏导数指示了函数在该点沿各个变量方向的局部变化趋势。为了有效地计算这些偏导数,特别是在多层神经网络中,链式法则被广泛应用,它允许我们通过反向传播过程逐层计算损失函数关于模型参数的偏导数。

“导数对一元函数表示切线斜率,反映变化快慢;偏导数对多变量函数表示固定其他变量时某变量的变化率,两者在梯度下降中指导参数更新方向。”

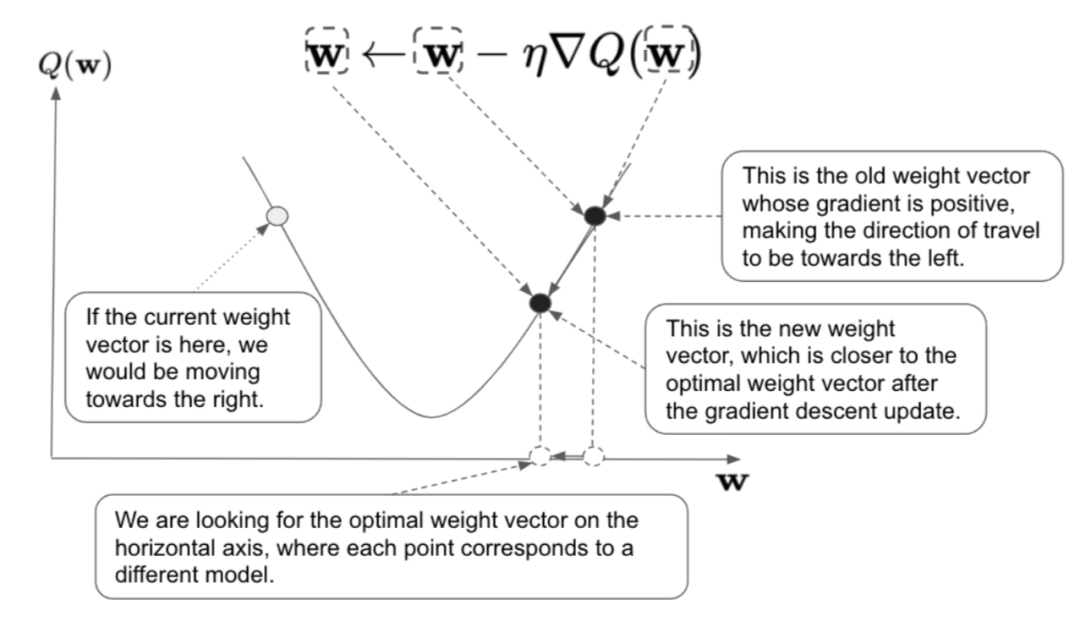

梯度(Gradient)是什么?梯度是一个向量,它表示某一函数在该点处的方向导数沿着该方向取得最大值,即函数在该点处沿着该方向变化最快,变化率最大。

梯度反映了函数在某一点上的最快变化方向和变化程度。方向性:梯度的方向就是函数在该点处取得最大变化率的方向。对于多元函数,这个方向是函数值增加最快的方向。

大小性:梯度的模(或大小)表示函数在该点处沿着梯度方向的变化率的大小。梯度的长度反映了函数曲面的变化剧烈程度,梯度的值越大说明函数曲面越陡峭,梯度的值越小说明函数曲面越平缓。

多维性:在多维空间中,梯度是一个由各个自变量的偏微分组成的向量。函数有多少个自变量,它就有多少个偏微分,这些偏微分共同构成了梯度向量。

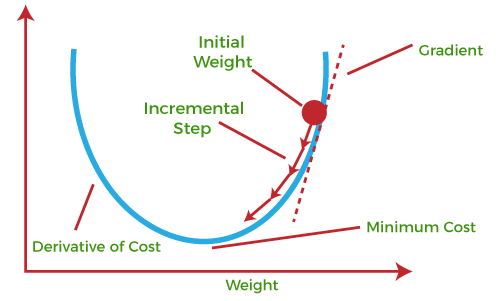

梯度是一个向量,它指向函数值增加最快的方向。在梯度下降算法中,我们需要找到函数值减小的方向,因此沿着梯度的反方向进行迭代更新参数是一个有效的策略。通过不断沿着梯度的反方向移动,算法可以逐步逼近函数的最小值点。

“一图 + 一句话”彻底搞懂梯度。

“梯度是一个向量,它表示多元函数在某点处变化最快的方向和该方向上的变化率大小,由各个自变量的偏微分组成。它是描述函数在某点处变化最快的方向和程度的向量,梯度下降算法通过沿其反方向迭代更新参数来逼近函数的最小值点。”