这个概念对至少三个重要学科产生了巨大的影响:统计物理、计算机科学与人工智能,以及神经科学。

作者 | 王启隆

出品丨AI 科技大本营(ID:rgznai100)10 月 8 日,瑞典皇家科学院在瑞典首都斯德哥尔摩揭晓了今年(2024)的诺贝尔物理学奖,获奖者为美国普林斯顿大学 John J. Hopfield 和加拿大多伦多大学 Geoffrey E. Hinton,以表彰他们“基于人工神经网络实现机器学习的基础性发现和发明”。两位科学家使用物理学方法训练人工神经网络。今年的获奖者从 1980 年代开始就在人工神经网络方面开展了重要的工作。

对于关注 AI 领域的朋友来说,Geoffrey Hinton 的名字并不陌生。人称”人工智能教父“和“深度学习教父”的他是加拿大认知心理学家和计算机科学家,1947 出生,现年 77 岁,有两任妻子,两个孩子。早在 2018 年,他就已经获得了计算机领域的终极奖项「图灵奖」。

今年人工智能领域的先驱拿了物理学的诺贝尔奖,让全球的网友都因此摸不着头脑,很多中国网友还引用了《三体》的名场面调侃:“物理学不存在了!”

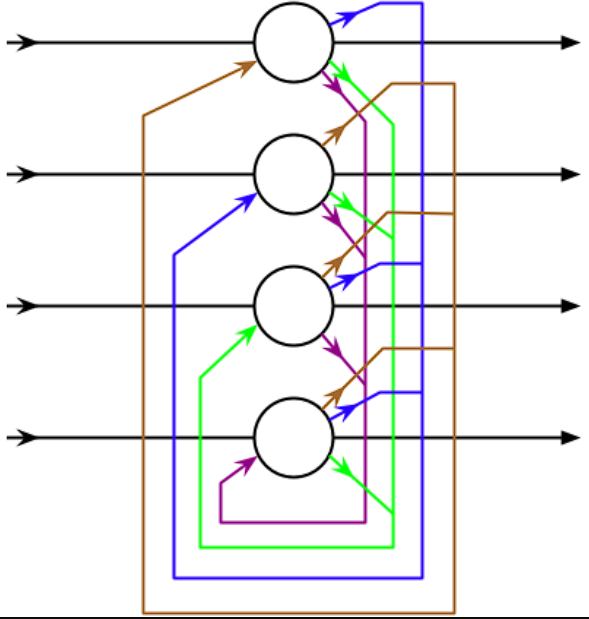

这次获奖的起源,是美国普林斯顿大学的科学家 John Hopfield 在 1982 年发明了“霍普菲尔德神经网络”(Hopfield neural network),而这个 Hopfield 网络是一种结合存储系统和二元系统的神经网络。它保证了向局部极小的收敛,但收敛到错误的局部极小值(local minimum),而非全局极小(global minimum)的情况也可能发生。Hopfield 网络也提供了模拟人类记忆的模型。

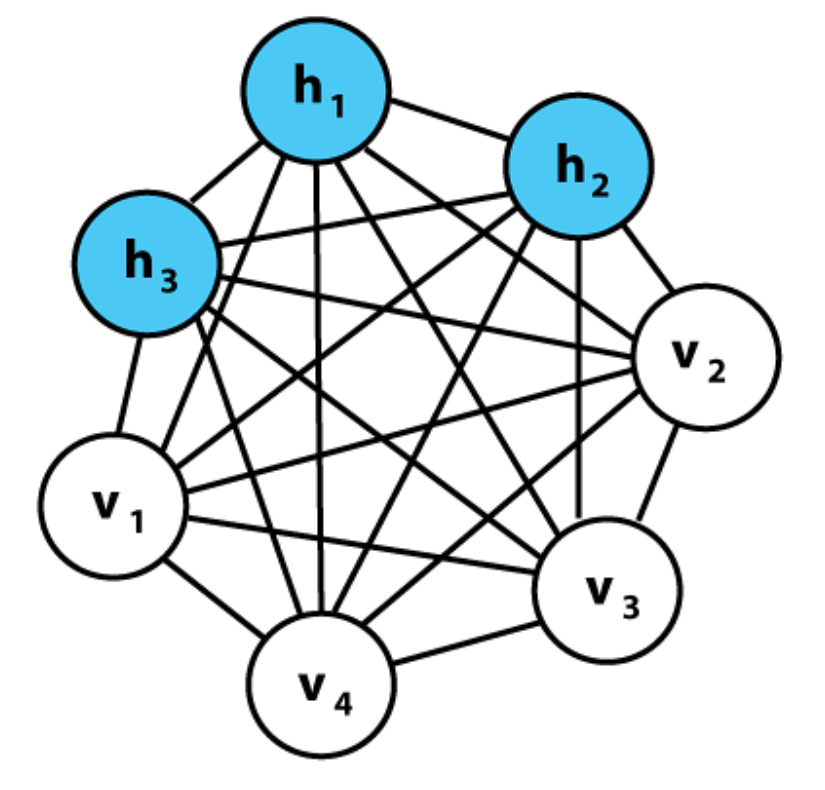

随后,Geoffrey Hinton 在 1985 年使用 Hopfield 网络作为新网络的基础,它采用了一种不同的方法——玻尔兹曼机。它可以学习识别给定类型数据中的特征元素。Hinton 使用了统计物理学的工具,通过给机器输入在实际运行时很可能出现的例子来训练它。玻尔兹曼机可以用来对图像进行分类,或者为它所训练的模式类型创建新的例子。Hinton 在这项工作的基础上,帮助开启了当前机器学习的爆炸性发展。

你可能会觉得这段故事很熟悉:没错,这里提到的“玻尔兹曼机”,就是 Hinton 曾在今年的采访中提到的“一生中最满意的失败作品”,欢迎回顾《深度学习之父 Hinton 万字访谈录:中美 AI 竞赛没有退路可言》一文,下图便是节选自 Hinton 当时的回答。

这一次诺贝尔获奖,Hinton 是否圆了自己曾经在玻尔兹曼机上的梦呢?

此外,作为 AI 领域最具影响力的人物, Hinton 曾经培养了许多优秀的学生,其中不仅包括了 2018 年和他同获图灵奖、并称“人工智能三大教父”的 Yann LeCun,还有 OpenAI 的前首席科学家、ChatGPT 背后的功臣 Ilya Sutskever。恩师获奖,满天下的桃李都出来贺喜,直接把这两天的推特变成了 AI 界的“名人回忆录”。

教父

首先是上文提到的 Yann LeCun,他不仅是 2018 年的图灵奖得主,还是 Hinton 的博士后,现今在 Meta 公司任首席 AI 科学家,为开源模型 Llama 作出了巨大贡献。LeCun 昨天早早就发表祝贺,表示自己和获奖的两位都曾共事:

Yann LeCun:

恭喜 John 和 Geoff!

两位都是我的前同事。我曾在多伦多 Geoff 的实验室读博士后。之后,我加入了贝尔实验室(Bell Labs),John 当时在那里担任兼职科学家(也是加州理工学院的教授)。事实上,我加入的部门会研究神经网络就是因为 John。

我第一次见到他们两人是在 1985 年。1985 年初,我在莱苏什 (Les Houches) 的一个研讨会上认识了 John。1985 年 6 月,我在巴黎的 Cognitiva 会议上认识了 Geoff。

随后,麻省理工学院 - IBM 沃森 AI 实验室的 Dmitry Krotov 用一系列推文引起了许多人的回忆,同时从专业视角一语道破了神经网络可以拿到物理学奖的原因。这位 Krotov 曾和获奖者之一的 John Hopfield 一起开发了一种神经网络的生物合理性学习算法,也是 AI 领域的前沿研究者。

Dmitry Krotov:

鉴于今天 #诺贝尔奖2024 带来的重大新闻,我想分享一些关于 Hopfield 网络的个人想法。

这个概念对至少三个重要学科产生了巨大的影响:统计物理、计算机科学与人工智能,以及神经科学。

在统计物理学中,Hopfield 模型成为了最常研究的哈密顿量之一。围绕这一理论已经发表了成千上万篇论文,并出版了多本专著。这一理念为数百位物理学家进入神经科学和人工智能领域提供了切入点,我就是其中之一。

在计算机科学领域,Hopfield 网络是结束 AI 寒冬(1974-1981)并引领后续人工神经网络复兴的主要驱动力。Hopfield 1982 年的论文标志着现代神经网络时代的开始。

现在,汇聚了超过 15000 名顶尖 AI 研究人员的主要 AI 会议 NeurIPS 的历史可以追溯到 1984 年至 1986 年间在加州理工学院举行的“Hopfests”会议,详见 John Moody 编写的 1991 年 NeurIPS 会议录。

Hopfield 网络为受限玻尔兹曼机的发展提供了重要的灵感,而后者在深度学习的早期阶段起到了关键作用。基于能量的建模这一在人工智能领域内突出的范式,正是从 Hopfield 的能量记忆模型发展而来的。

在神经科学中,Hopfield 网络成为许多后续记忆计算模型的基础。将记忆回溯比喻为在能量景观中滚下山丘的概念,已经成为神经科学中的经典隐喻。

最后,再次祝贺两位获奖者!@JohnHopfield @GeoffreyHinton

这几则推文让 Yann LeCun 得到共鸣,他又新开一帖转发了 Krotov 的内容,开始了他自己的相关回忆:

Yann LeCun:

雇用我到贝尔实验室的 Larry Jackel 曾在 1986 年到 1996 年期间负责“雪鸟研讨会”(该研讨会又名“计算神经网络”)。

到了 1997 年,他的兴趣发生了变化。他告诉我:“我不想再经营雪鸟了。要么你来接管它,要么它就此消失。”所以我将研讨会的名称改为“会学习的机器”,并于 1997 年开始举办,最终邀请了 Yoshua Bengio 来帮忙。

到了 2000 年代后期,该研讨会已经成为日益壮大的深度学习社区的主要聚会场所。2013 年,我们将研讨会变成了一个会议,并将其命名为“国际学习表征会议”(ICLR)。

LeCun 在这段回忆中提到的「ICLR」,与 NeurIPS 和 ICML 并称机器学习和人工智能研究领域影响最大的三个主要会议之一。而和他一起成立 ICLR 的 Yoshua Bengio,正是“人工智能三大教父”中的最后一位,和 Hinton、LeCun 一起获得了 2018 年的那座图灵奖。Bengio 自然也在祝贺的队列中,慷慨陈词、文采飞扬,同时提到了 AI - 物理之间的联系,为诺贝尔奖做了个解释:

Yoshua Bengio:

@JohnHopfield 和 @GeoffreyHinton 及其合作者们,在物理与人工智能之间建立了一座美丽而富有洞察力的桥梁。他们发明的神经网络不仅受到了大脑的启发,也受到了物理学中的核心概念如能量、温度、系统动力学、能垒、随机性和噪声的作用等的启发,这些理论将局部属性(例如原子或神经元的属性)与全局属性如熵和吸引子联系起来。并且,他们超越了物理学范畴,展示了这些观念如何能够产生记忆、学习以及生成模型;这些概念至今仍是现代人工智能研究的前沿课题。

他们的思想对我产生了深远的影响,以至于我在研究生阶段选择神经网络中的学习作为自己的研究方向。他们激励我去寻找那些像物理定律一样简单的抽象原则,但同时也能解释生物智能及人工智能。我为他们也为我们的领域感到由衷的高兴。

如此看来,给神经网络颁发诺贝尔物理学奖是不是还真有些道理呢?

谈及 Yoshua Bengio,就不得不提他的弟弟 Samy Bengio 也是 AI 领域的先驱人物。这位 Bengio 弟弟和 Geoffery Hinton 当年都在谷歌大脑(Google Brain

)一起工作,建立了深度学习大厦的“地基”。

回顾深度学习历史最浓墨重彩的一页,就是谷歌大脑的两位传奇人物 Jeff Dean 和吴恩达(Andrew Ng)等通过深度学习技术,成功让 16000 台电脑学习 1000 万张图片后,在 YouTube 视频中“认出”了猫。这次 Hinton 获奖,自然也唤起了吴恩达对过往光辉岁月的回忆,他表示,自己就是第一个给 Hinton 取“深度学习教父”绰号的人。

吴恩达(Andrew Ng):

我是第一个称 Geoff Hinton 为“深度学习教父”的人,后来他被称作“人工智能教父”。很高兴看到他和 John Hopfield 一起获得人工智能诺贝尔奖。恭喜 @geoffreyhinton !

Hinton 在谷歌工作了十年后于 2023 年辞职,以便能够“自由地谈论人工智能的风险”。而恰好是在他离职的一个月前,谷歌大脑与谷歌旗下的另一个 DeepMind 实验室合并,成立 Google DeepMind。在昨天的一系列祝贺中,DeepMind 的联合创始人 & CEO Demis Hassabis 也是不容忽视的名字。在这次奖项正式公布之前,很多人都猜测 Demis 在 DeepMind 主导的 AlphaFold2 项目才是热门选择。而现在直接颁给了定义更广泛的神经网络,AlphaFold 得奖的可能性却大大降低了。

Demis Hassabis:

热烈祝贺我的好友兼前 Google 同事 @geoffreyhinton 与 John J. Hopfield 共同获得诺贝尔物理学奖!Geoff 当之无愧,他为现代 AI 领域的深度学习革命奠定了基础。

此外,在 Hinton 活跃于谷歌的那段时光中,还有一位举足轻重的科学家与他有着深刻的交集,那就是李飞飞(Fei-Fei Li)。李飞飞在计算机视觉领域以其开创性的工作而著称,特别是她主导创建了大规模图像数据库 ImageNet,这项工作极大地推动了机器视觉技术的发展。2012 年,Hinton 和他的学生 Alex Krizhevsky 和 Ilya Sutskever 共同开发的 AlexNet 在李飞飞所创建的 ImageNet 大规模视觉识别挑战赛(ILSVRC)中取得了突破性的成绩,显著降低了图像分类错误率,被广泛认为是深度学习新时代的开端。两人的研究轨迹一直交汇着,令李飞飞在祝贺之余也连连感叹:

李飞飞(Fei-Fei Li):

这太令人兴奋了!#AI的深远影响才刚刚开始。祝贺 @geoffreyhinton 和 John Hopfield!

不到一年前,@geoffreyhinton 还和我公开讨论过 AI 的历史及其对未来的影响。我非常荣幸并感谢 @geoffreyhinton 对我的科学工作和新书《我所看到的世界》的支持。

上文已经提及了两次 Ilya,作为今年推特 AI 圈最火且最忙的男人之一,他自然不会忘记对恩师的道贺。这也是 Ilya Sutskever 自离开 OpenAI 创业以来唯一一条和新公司无关的推文,意简言骇,这爷俩的关系应该也是不需要多少繁文琐节了:

Ilya Sutskever:

恭喜 @geoffreyhinton 获得诺贝尔物理学奖!!

MIT 物理学终身教授、未来生命研究所创始人 Max Tegmark 也在推特上发表了祝贺,笔者还记得 2023 年的北京智源大会上他和 Hinton 同框登场,两人讨论的还都是 AI 安全问题。后面在演讲上,Tegmark 当时预告了会和另一位“AI 教父” Yann LeCun 来一场关于 AI 的辩论,最终他以 63% 支持率打过了 LeCun。这次 Tegmark 的祝贺也是相当耐人寻味:

Max Tegmark:

祝贺 @geoffreyhinton 和 John Hopfield 获得 2024 年诺贝尔物理学奖!您的出色工作有助于证明智能是一个物理过程 - 最终是我们宇宙中最强大的过程。

27 岁天才创始人 Joel Hellermark 在今年为 Geoffery Hinton 做了一场相当成功的采访,成功到他自己“吹了一年”,这次也是不例外,在祝贺之余也进行了宣传:

Joel Hellermark:

恭喜 @geoffreyhinton 获得诺贝尔物理学奖!您不仅在工作上堪称楷模,而且在好奇心和善良方面也堪称楷模。

紧接着是 Aidan Gomez,我们曾经翻译过两篇关于这位“狠人”的采访,他不仅在谷歌实习期间参与 Transformer 论文的撰写,是“Transformer 八子之一”,现在创立的公司 Cohere 还成功融资了 5 亿美元。

Aidan Gomez:

非常感谢 @geoffreyhinton。他是我们这个领域(人工智能)和加拿大真正的英雄。

Aidan 祖籍加拿大安大略省的布莱顿,所以他也是众多 AI 大佬里唯一一个从加拿大角度夸赞 Hinton 的,画风比较清奇。值得一提的是,和 Aidan 一起创业的 Cohere 创始人 Nick Frosst 则是 Hinton 的博士生,可见世界真的很小:

Nick Frosst:

恭喜 @geoffreyhinton :) 我想不出还有比他更值得的科学家了

他对探索和发明的热情永远激励着我。但他的善良、幽默和指导让我受益最多。

感谢 Geoff 所做的一切!恭喜!

Russ Salakhutdinov,现在 Meta 公司下属的人工智能部门 GenAI 担任研究副总裁的职位。2004 年,当 Salakhutdinov 初遇 Hinton 的时候,他其实正考虑退出人工智能领域。但在 Hinton 邀请他参与一个专注于研究一种训练人工神经网络的新方法的项目后,他就此改变了主意,后来成为了贝叶斯程序学习的开发者。Russ 连转了好几条相关推文,可见心情真的很激动:

Russ Salakhutdinov:

衷心祝贺 Geoff Hinton @geoffreyhinton 获得诺贝尔奖!这是多么不可思议的荣誉啊!

对于能够成为您的博士生,与您一起工作并向您学习,我感到非常荣幸。

最后是 Jim Fan,他是英伟达的高级研究经理兼具身智能 (GEAR 实验室) 负责人,同时也是推特上相当活跃的博主,在祝贺的同时进行了一些考据:

Jim Fan:

从现在开始,我将把机器人技术重新定义为 *深度物理计算*

恭喜第二位图灵奖和诺贝尔奖得主!我刚刚查了一下,第一位是 Herbert A. Simon,他曾获得了图灵奖和诺贝尔经济学奖。

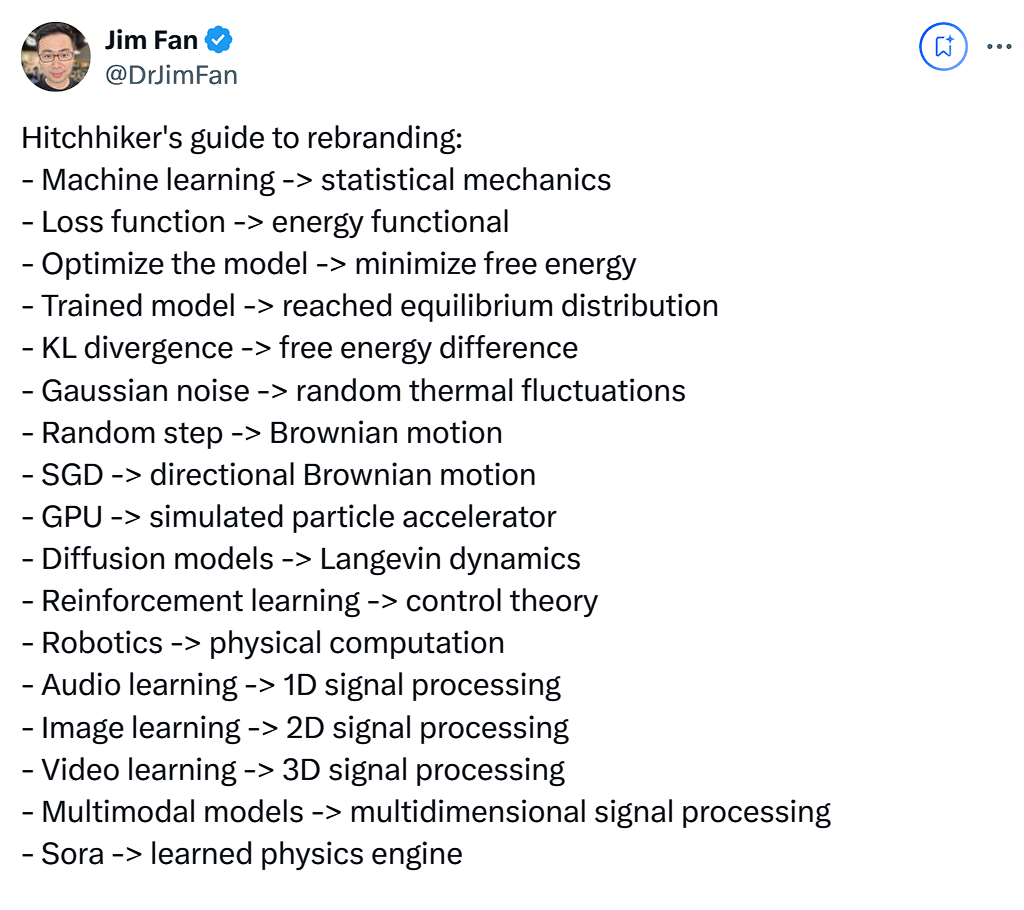

Jim 所提到的这位 Herbert A. Simon 便是大名鼎鼎的通才“司马贺”。他是包括人工智能在内现代许多重要学术领域的创建人之一,是第一个分析复杂性架构(architecture of complexity)的人,获得了 1975 年图灵奖。司马贺是这位大神曾作为美国计算机科学代表团访华时取得的汉名。此外,Jim 还整了个特别有意思的活。因为这次人工智能先驱得了物理学奖引起争议,所以他把 AI 领域相关名词全部翻译成了“物理”版本,做了个「AI 术语的物理学翻译指南」:

这活你能打几分?给神经网络颁发诺贝尔物理学奖究竟合不合适呢?欢迎在评论区留下你的看法。