当代机器学习算法,通过特定任务的训练数据进行梯度下降,将网络权重设置为单个优化配置,以训练人工神经网络。由此产生的网络,可在自然语言处理、图像分析和基于代理的任务上,达到人类水平的性能,但缺少人类智能的灵活性和鲁棒性。

近日,美国 加州理工学院(California Institute of Technology)Guruprasad Raghavan,Matt Thomson等,在Nature Machine Intelligence上发文,报道了微分几何框架——功能不变路径——提供了训练神经网络的灵活和连续适应,可实现主要机器学习目标之外的次要任务,包括增加网络稀疏化和对抗性鲁棒性。将神经网络的权空间公式化为配备有度量张量的弯曲黎曼流形,其谱定义了权空间中的低秩子空间,该低秩子空间在不损失先验知识的情况下适应网络自适应。将自适应形式化为沿着权重空间中的最短geodesic路径移动,同时搜索适应次要目标的网络。利用适度的计算资源,功能不变路径算法实现了最先进方法相当或超过最先进方法的性能,包括连续学习的低秩自适应、大型语言模型(来自转换器的双向编码器表示)、视觉转换器(ViT和DeIT)和卷积神经网络的稀疏化和对抗性鲁棒性任务。

Engineering flexible machine learning systems by traversing functionally invariant paths.

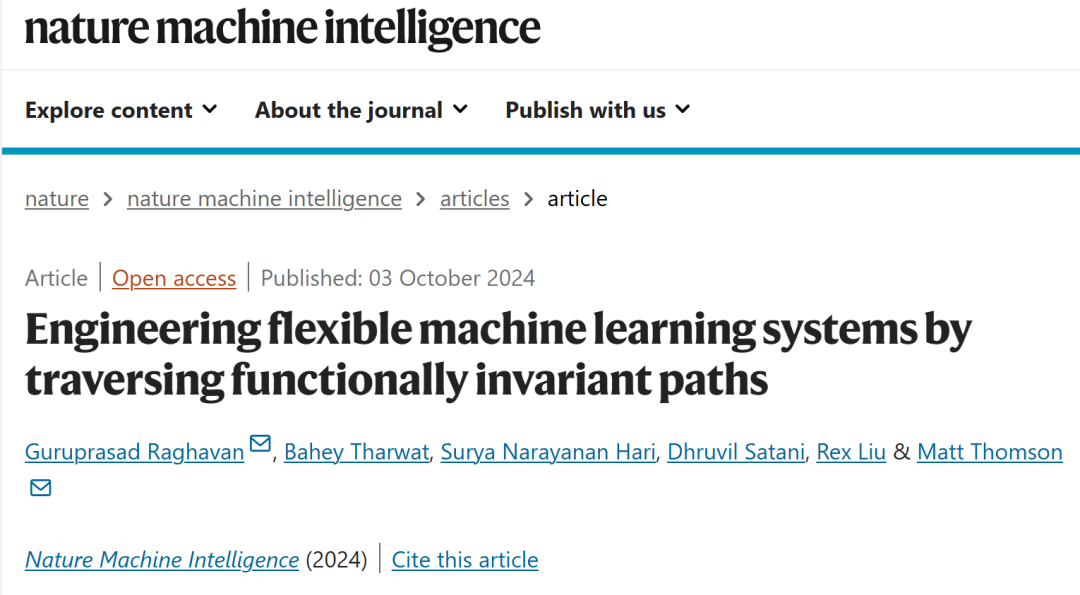

图1: 在权空间中,构造功能不变路径functionally invariant paths,FIPs微分几何框架。

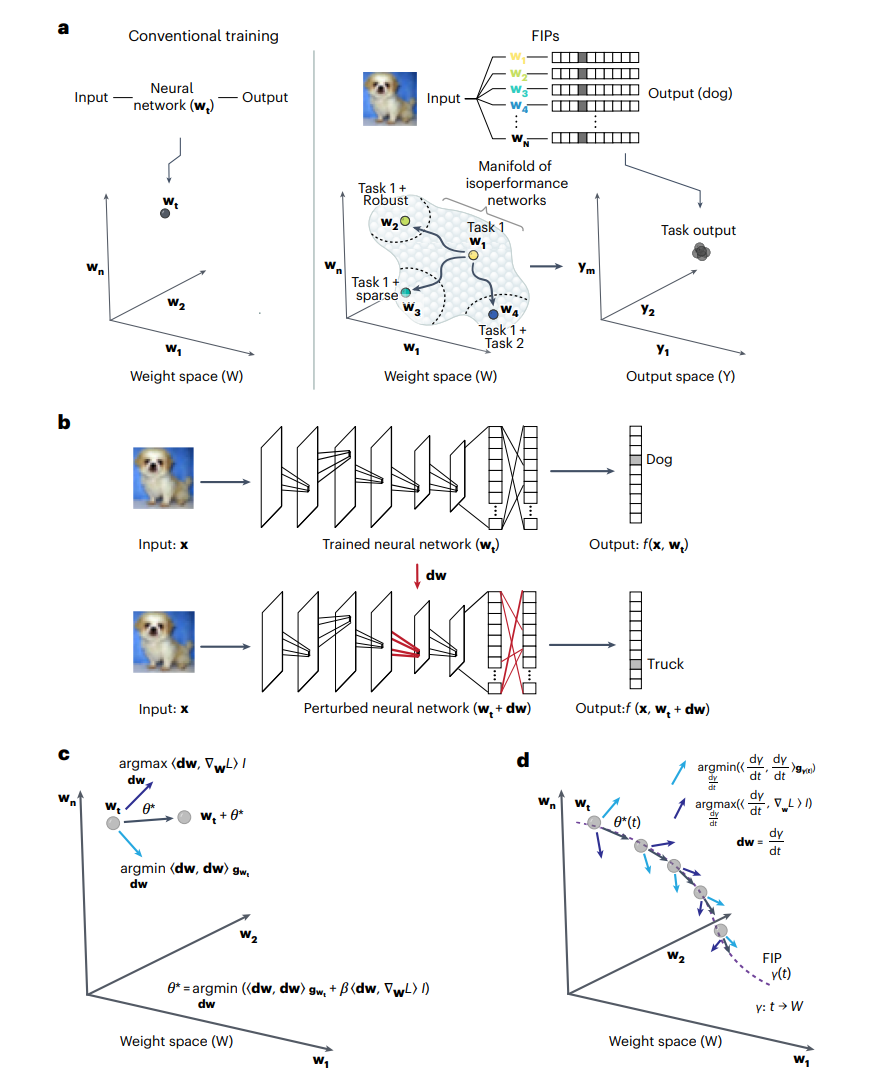

图2: Vision Transformers通过遍历FIPs来学习顺序任务。

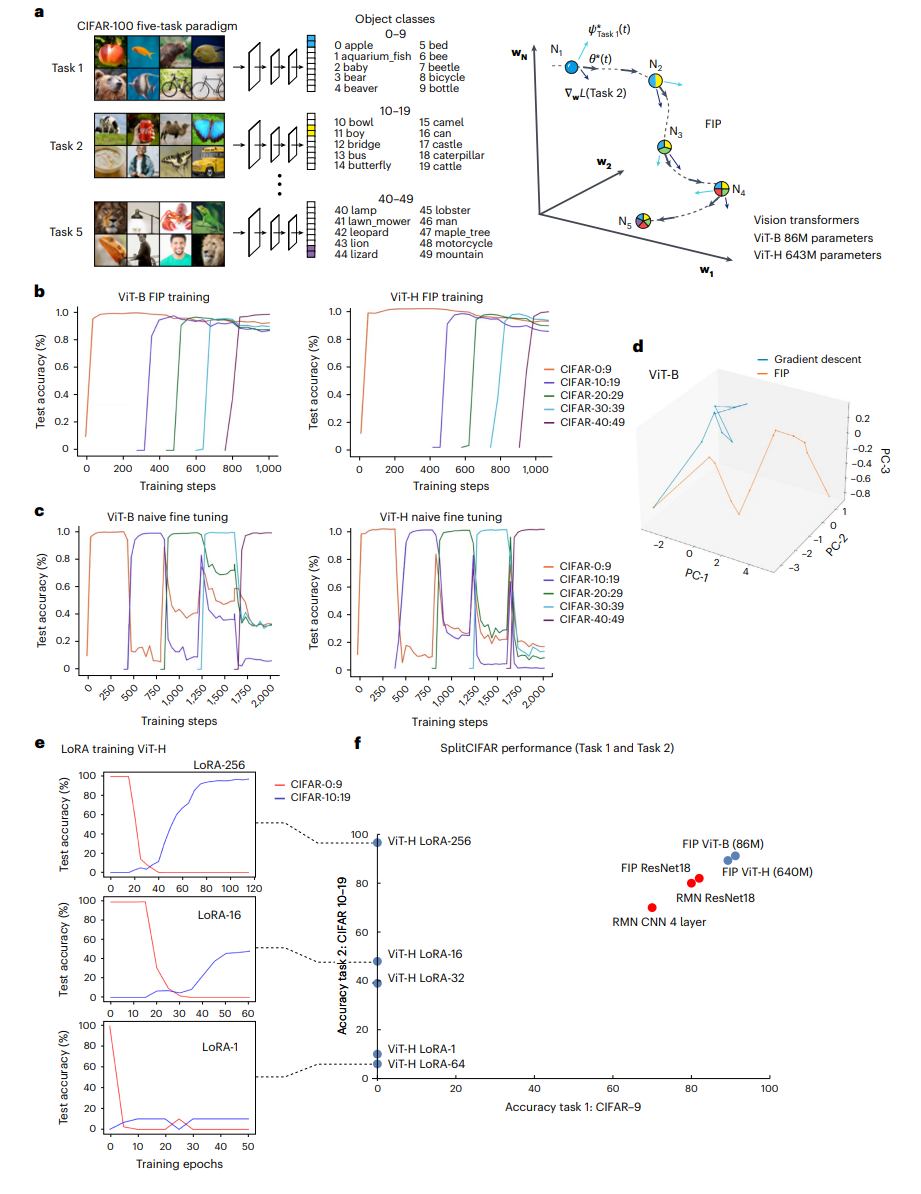

图3: Bert Transformer通过遍历FIP来学习连续的情感分析任务。

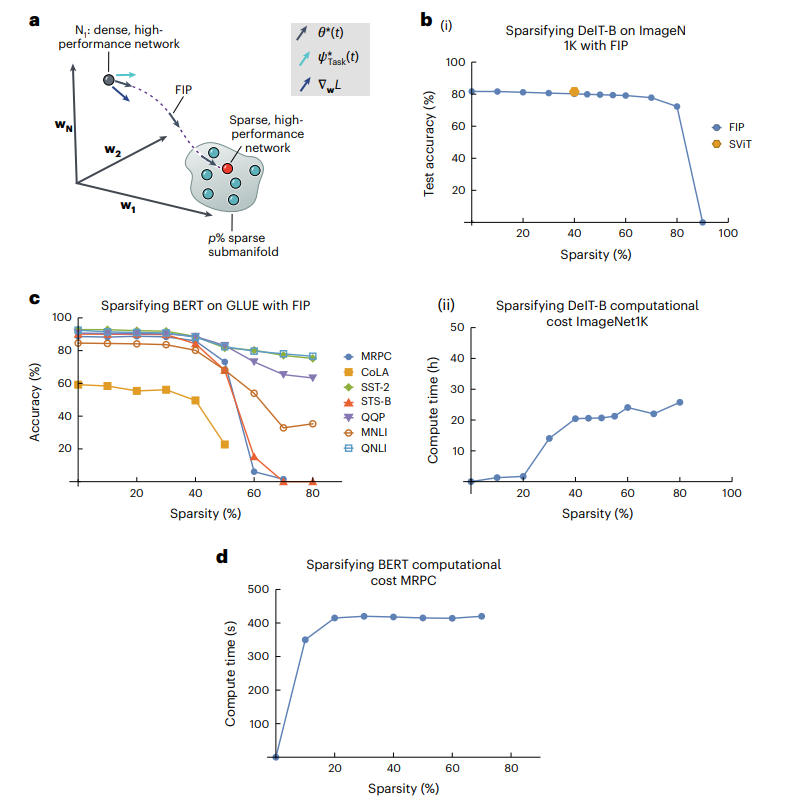

图4: 使用FIP视觉和语言转换器的稀疏化。

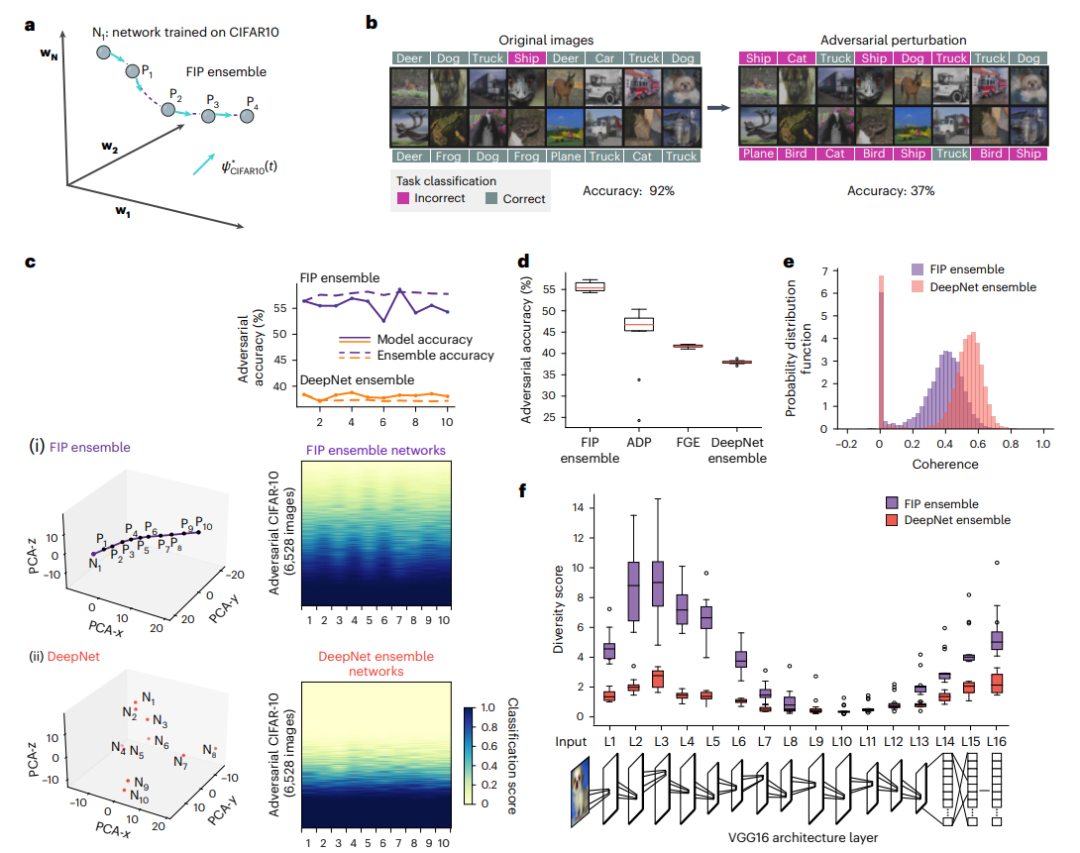

图5:在权重空间中,FIPs生成赋予对抗性鲁棒性的网络集合。

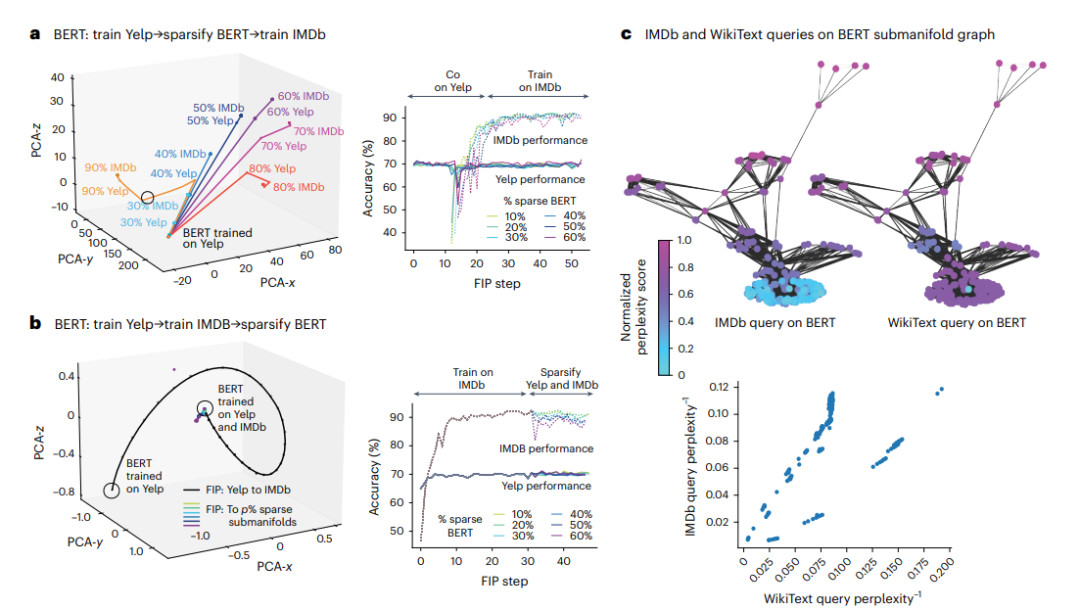

图6: 通过FIP合成的双向编码器表示bidirectional encoder representations from transformers,BERT非阿贝尔迭代变换。

Raghavan, G., Tharwat, B., Hari, S.N. et al. Engineering flexible machine learning systems by traversing functionally invariant paths. Nat Mach Intell (2024). https://doi.org/10.1038/s42256-024-00902-xhttps://www.nature.com/articles/s42256-024-00902-x声明:仅代表译者观点,如有不科学之处,请在下方留言指正!