👇 连享会 · 推文导航 | www.lianxh.cn

🍓 课程推荐:2024 空间计量专题

主讲老师:范巧 (兰州大学)

课程时间:2024 年 10 月 2-4 日 (三天)

课程咨询:王老师 18903405450(微信)

课程特色 · 2024空间计量:

👉 一、从“零基础”到“高水平”的课程设计

- 既考虑软件安装、程序编写以及空间权重矩阵设计等 基础知识 讲授,更强调时空面板地理加权回归模型、贝叶斯空间计量模型、矩阵指数模型、空间计量交互模型与空间面板似不相关回归模型等 前沿模型 的传授。

👉 二、“保姆级”的空间计量代码

- 编写与校准所有模型的MATLAB代码,简化实操环节

- 模型的估计与检验等 仅按照提供的Excel数据版式 搜集与整理原始数据,即可一次性出结果并作图。

👉 三、“最多上新” 的内容体系

- 新增 矩阵指数模型、短面板空间似不相关模型、空间计量交互模型、贝叶斯空间计量模型等

- 新增 前沿应用案例,包括空间计量与索洛余值法、随机前沿分析与数据包络分析等的互嵌研究,阐释基于空间计量的产业空间结构优化评价方法。

- 新增 Dagum空间基尼系数、核密度估计、空间马尔科夫链与空间收敛性等内容,阐释现实研究中对空间收敛性的应用“谬误”。

温馨提示: 文中链接在微信中无法生效。请点击底部

「阅读原文」。或直接长按/扫描如下二维码,直达原文:

作者:米书颖 (南京大学)

邮箱:201830106@smail.nju.edu.cn

编者按:本文整理自下文,特此致谢!

Source:Kapoor S, Cantrell E, Peng K, et al. Reforms: Reporting standards for machine learning based science[J]. arXiv preprint arXiv:2308.07832, 2023. -PDF-

1. 引言

目前,机器学习在科学研究中的应用逐渐增多。然而,采用机器学习方法可能会伴随有效性、可重复性和普适性等方面的挑战,从而可能损害基于机器学习的科学研究的可信度。基于这些观察,Sayash Kapoor 等人提出了一套清晰的报告标准,并发布了 REFORMS (Reporting Standards For Machine Learning Based Science) 检查清单。这份清单包含 32 个问题和一系列技术指南,为广大科研工作者在研究设计中提供了参考依据。

2. 适用范围

本文提供的检查清单主要适用于基于机器学习的科学研究,其中包括但不限于应用机器学习进行预测、计算等以回答一个科学问题。需要注意的是,该检查清单不适用于以下两类研究:

- 机器学习方法研究:这类研究致力于改进和完善机器学习方法本身。

- 预测分析:在许多实际应用情境中,对机器学习的应用主要侧重于预测的准确性,而非科学的前瞻性。例如,许多社交平台利用机器学习来预测用户是否会点击广告。这类研究通常局限于特定公司或组织内部,缺乏普适性,因此本文提供的检查清单同样不适用于这类研究。

除此之外,适用本检查清单的研究应该是利用机器学习方法的研究,传统的因果模型和模拟计算不包括在内。即使有些模拟计算中使用了机器学习算法,但这只是将这些算法应用于现有模型中,与探索一个科学问题存在根本区别。

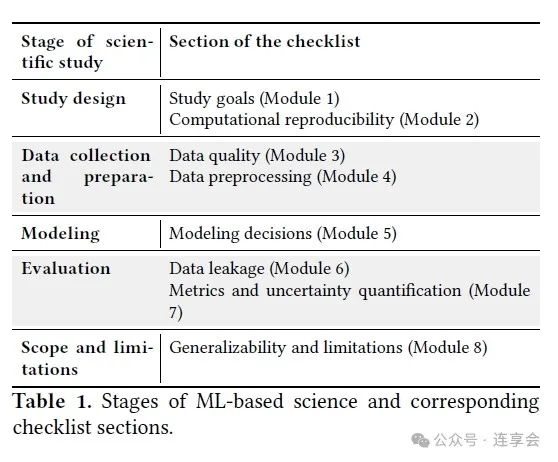

3. REFORMS 检查清单

本文提供的检查清单是按研究阶段划分的,不同的研究阶段具有不同的目标和要求。

3.1 研究设计

3.1.1 模块 1:研究目标确定

在正式开始研究之前,首先需要确定研究目标,重点关注以下几个方面:

- 确定研究针对的群体或分布。这里所指的群体是指研究人员希望能够将研究结果推广的对象。

- 确定本研究选择此研究群体或分布的原因。选择特定受众可能源于科学兴趣或应用知识的需求。清楚解释研究该群体的动机有助于读者理解研究的背景和重要性。

- 确定本研究选择机器学习方法的原因。基于机器学习的研究问题与传统统计方法下的问题有所不同。Breiman 曾提出统计建模存在“两种文化”:数据建模文化和算法建模文化。在传统统计方法的数据建模文化中,研究人员关注估计函数参数,用于描述输入数据生成输出数据的过程;而基于机器学习的研究则关注构建一个可靠的输入到输出映射模型,其中并非所有参数都需要解释和有意义。解释采用机器学习方法的动机有助于读者更好理解研究目标。

3.1.2 模块 2:计算的可重复性

计算的可重复性是计算研究中一个基本部分,指的是其他研究人员能够复现并获得与论文中报告的结果一致的结果。为了确保计算的可重复性,研究开始前需要做好以下准备工作:

- 确定用于训练和评估模型的数据集,并提供唯一标识链接或 DOI。数据集的说明文档同样重要,应包含数据基本属性和格式细节。

- 确定用于训练、评估模型和生成论文结果的代码,并提供唯一标识链接或 DOI。作者可通过提供 DOI、Github、Gitlab 或 BitBucket 等代码库,或其他文档来准确标识用于训练、评估模型和生成论文结果的代码版本。

- 描述所用的计算设备。不同的计算实验需不同的资源。作者应报告所用硬件 (CPU、RAM、磁盘空间)、软件 (操作系统、编程语言、所有软件版本) 和其他计算资源的详细信息,以帮助读者理解再现研究的精确计算要求。

- 生成一个 README 文件,包括对所用数据集和代码生成结果的说明。良好的文档可帮助不熟悉项目的研究人员了解提供的代码和实验步骤,内容从环境要求和安装到使用范例和预期结果展示。

- 生成用于再现所有结果的脚本。提供一个脚本可生成论文中报告的所有结果,包括下载运行所需软件包、数据集存储和正确设置、计算环境配置和代码运行。作者可以通过多种方式实现这些脚本,例如使用 Bash 脚本或 CodeOcean 等网上再现平台。

3.2 数据收集与准备

3.2.1 模块 3:数据质量

使用质量差或不合适的数据可能导致研究结果毫无意义或具有误导性。为了确保研究数据的质量,需要关注以下几个方面:

-

分别确定训练数据和分析数据的来源。报告数据的收集时间、地点和方式,以确保数据的可信度。

- 描述数据采样框架。描述研究的采样框架有助于读者了解样本的边界和与目标人群的关系。

- 确定该数据集对当前建模任务有用的原因。研究人员应解释为什么数据集对建模任务有用。例如,虽然偏差或不完整的数据对于某些研究问题不适用,但只要研究人员了解这些缺点如何影响分析并传达出这些局限性,这些数据对于问题的解决也可能是有效的。研究人员应该对这些局限性和研究问题的关系展开详细说明。

- 确定模型的结果变量。结果变量通常是根据不可观察的理论构建的代理变量,为了让读者评估结果变量与论文观点之间的相关性,研究人员应准确描述结果变量的测量方式。此外,本检查清单还要求作者提供关于结果变量的描述性统计结果。

- 确定数据集中的样本量。汇报总样本量,特别是子样本的使用情况和重复数据的集中分布情况。

- 根据结果变量的类别分别计算缺失数据的比例。重点在于汇报缺失数据的普遍性。本检查清单所要求的对缺失数据的处理将在模块 4 中进行介绍。

- 检验用于评估的数据具有代表性。研究人员应证明研究样本是模块 1 中定义的目标人群的代表性样本。

3.2.2 模块 4:数据预处理

预处理是将数据集从其最原始的形式转化为建模过程中使用的最终形式的一系列步骤。这其中包括数据选择、数据转换 (如填补缺失数据、标准化等)。数据的预处理对所研究的科学问题的研究范围和有效性都可能产生影响。本检查清单要求数据预处理过程应关注以下几个方面:

- 确定是否有样本被排除以及其被排除的原因。研究人员可能会排除数据集中的一些样本,如去除异常值或仅关注某些子集。最终使用的特定数据子集应与研究目标密切相关。研究者应报告选择特定的数据子集的重要性及原因。

- 确定如何处理异常值。数据集中可能包含错误或不理想的数据,去除这些数据对于确保研究结论的准确性十分重要。本检查清单要求汇报对这些异常数据的处理。

- 确定数据如何转化。一旦确定要使用的数据集,研究人员可以通过各种方式转化数据。例如,将数据标准化,填补缺失数据等。研究人员应对数据的转化方式进行详细说明。

3.3 建模

3.3.1 模块 5:模型选择

研究人员在构建机器学习模型时会面临不同的选择,具体应该根据研究目标和内容来确定。报告机器学习模型的详细信息至关重要,否则研究结果的可重复性将受到影响。此外,模型选择与评估指标的选择密切相关,不当的评估指标和模型选择方法可能导致估计结果过于乐观。因此,在模型选择方法应关注以下五个部分:

- 详细描述训练模型。其中包括详细描述模型的输入和输出、模型类型 (如随机森林、神经网络),以及用于训练模型的损失函数和算法。

-

确定选择此模型的原因。对机器学习模型类型的选择可能取决于所研究的科学问题。例如某些研究内容强调预测能力,那么选择最终预测准确性强的模型更合适;某些研究内容旨在确认模型在实际环境中的潜在可用性,那么模型具有更强的可解释性更为重要。

- 确定模型评估方法。对机器学习模型的评估必须在训练数据之外的测试数据上进行。为了确保结果的再现性和有效性,研究人员应汇报数据是如何分隔和使用的,具体包括是否使用交叉验证,还是使用外部验证的测试集。同时也要汇报分隔后的数据的样本量。

- 确定模型选择方法。在建模过程中可能面临不同机器学习模型类型的选择,即使机器学习类型固定,超参数的具体选择不同,模型也会呈现差异。研究人员应在论文中汇报最终模型是如何选择的,包括考虑准确性、公平性、可解释性等多方面的因素。

- 确定超参数选择。模型训练过程通常依赖于模型超参数的选择,如正则化权重、模型训练周期数或学习率等。研究人员应汇报选择的超参数及确定超参数的方式。

- 确定适当的基准。选择具体的机器学习模型后可能需要与现有的基准模型进行比较。研究人员在比较时应详细说明基准模型是如何训练的,以及基准方法是如何被优化的。

3.4 分析

3.4.1 模块 6:数据泄露

数据泄露问题是指在机器学习模型的训练过程中,错误地使用了不应该包含在训练过程中的测试数据信息,导致模型评估结果过于乐观。例如将训练数据和测试数据一起标准化会导致数据泄露,因为测试数据特征的信息包含在了训练数据中。为了避免产生数据泄露的问题,本检查表要求研究人员关注以下三个方面:

- 保持训练数据集和测试数据集分离。如果在其他预处理或建模步骤之后再进行测试数据集和训练数据集分隔也会导致泄露问题。

- 确定解决训练数据集和测试数据集之间相关性和重复性的办法。某些情况下,数据集中的样本可能存在依赖关系。例如来自同一患者的临床数据可能同时存在于训练数据集和测试数据集中。对于时间序列预测模型,将时间序列数据集随机分隔成训练集和测试集可能导致过于乐观的结果,因为训练集中包含了“来自未来”的信息。在这种情况下,训练-测试数据集的分隔或交叉验证应考虑这些依赖关系。同时也可以采用分块交叉验证、元分段交叉验证等方式来处理这些依赖关系。研究人员应给予说明。

- 确定特征的合法性。检查表中提到的非法特征是指在实际应用中无法获取或不应该被用作预测的特征,但在模型训练时却被使用,从而导致模型的性能被夸大。非法特征可能导致数据泄露,因为这些非法特征本质上是结果变量的代理,模型实际上是在利用结果变量的信息进行训练,而这些信息在实际预测时是无法获得的。这会使模型在训练数据上的表现非常好,但在真实数据上的表现可能远不如预期。

3.4.2 模块 7:性能指标和不确定性评估

机器学习模型的性能对研究结果十分重要。由于作者在选择性能指标时面临多种选择,因此研究人员有必要解释为什么所选择的性能指标适用于本研究情境。此外,传达和解释不确定性也很重要。本检查表要求研究人员详细汇报所选择的性能指标和这些指标的不确定性估计,以便读者判断研究人员是否为评估模型性能做出了有效选择。具体包括以下三方面:

- 确定使用的性能指标。适当的性能指标选择通常受所研究的特定研究问题的影响,某些指标可能具有误导性并不适用。例如,在存在严重的类别不平衡的情况下,准确性可能并不适合作为衡量机器学习模型的性能指标。研究人员应结合特定研究情境解释适用特定性能指标的理由。

-

进行不确定性估计。汇报置信区间、标准误等并提供具体的计算信息。此外,研究人员也可参考 Simmonds 等人在 2022 年提出的最佳实践和检查表来考虑不确定性问题。

- 进行适当的统计检验。统计检验是评估不同机器学习模型某一性能差异的工具。研究人员应对选择所用到的统计检验的原因进行论证,并对统计检验的假设进行检查。

3.5 应用范围和局限

3.5.1 模块 8:推广性和局限性

外部有效性 (或“推广性”) 是指研究样本的发现除了适用于目标人群,也适用于其他人群和情境。这里的外部有效性可能是对研究情境的推广应用、模型的推广应用以及算法的推广应用。本检查表要求研究人员对外部有效性的情况展开说明,具体包含以下两个部分:

- 确定是否外部有效性的证据。研究人员应讨论研究结果从样本到目标人群再到其他人员、结果或情境的推广能力。研究人员可以通过定量分析或理论分析的方法来提出外部有效性的证据。例如在其他研究情境下测试研究结论是否成立,引用先前的文献或推理不同情境之间的相似性。

- 确定作者不希望研究结果适用的情境。研究人员应关注模型在什么情境下失效,识别研究结果预期适用的情境边界,提高研究结果成功复制的可能性。

4. 总结

在本篇推文中,我们向大家介绍了基于机器学习的科学研究的报告标准。在研究开展的不同阶段,该标准都提供了具体的指导原则。希望这篇文章能够帮助大家更好地理解机器学习!

5. 相关推文

Note:产生如下推文列表的 Stata 命令为:

lianxh 机器学习, m

安装最新版 lianxh 命令:

ssc install lianxh, replace

- 连享会, 2021, Stata-Python 交互-7:在 Stata 中实现机器学习-支持向量机, 连享会 No.557.

- 李金桐, 2023, 因果推断:双重机器学习-ddml, 连享会 No.1221.

- 李占领, 2020, Semantic scholar:一款基于机器学习的学术搜索引擎, 连享会 No.177.

- 赵莹, 2022, 知乎热议:机器学习在经济学的应用前景, 连享会 No.938.

- 连享会, 2022, 连享会主页-推文列表-按时间, 连享会 No.449.

- 连享会, 2022, 连享会主页-推文列表-按类别, 连享会 No.448.

- 吕卓阳, 2021, MLRtime:如何在 Stata 调用 R 的机器学习包?, 连享会 No.85.

- 吴小齐, 2023, R 语言:L2 Boosting 在经济学中的应用, 连享会 No.1288.

- 王卓, 2023, Python:从随机实验到双重机器学习, 连享会 No.1204.

- 董洁妙, 2022, Stata:双重机器学习-多维聚类标准误的估计方法-crhdreg, 连享会 No.1036.

- Drukker, 刘迪, 2020, Stata Blogs - An introduction to the lasso in Stata (拉索回归简介), 连享会 No.117.

- 仵荣鑫, 2022, 知乎热议:如何学习机器学习, 连享会 No.983.

- 全禹澄, 2021, 机器学习如何用?金融+能源经济学文献综述, 连享会 No.670.

- 关欣, 2022, 机器学习在经济学领域的应用前景, 连享会 No.905.

- 冯乔, 2023, Stata 中的堆栈泛化和机器学习-pystacked, 连享会 No.1317.

- 张瑞钰, 2021, 知乎热议:纠结-计量经济、时间序列和机器学习, 连享会 No.585.

- 樊嘉诚, 2021, Stata:机器学习分类器大全, 连享会 No.505.

- 马丁, 刘梦真, 2021, 机器学习:随机森林算法的 Stata 实现, 连享会 No.568.

🍓 课程推荐:2024 机器学习与因果推断专题

主讲老师:司继春 (上海对外经贸大学) ;张宏亮(浙江大学)

课程时间:2024 年 11 月 9-10 日 ;16-17日

课程咨询:王老师 18903405450(微信)

尊敬的老师 / 亲爱的同学们:

连享会致力于不断优化和丰富课程内容,以确保每位学员都能获得最有价值的学习体验。为了更精准地满足您的学习需求,我们诚挚地邀请您参与到我们的课程规划中来。请您在下面的问卷中,分享您 感兴趣的学习主题或您希望深入了解的知识领域 。您的每一条建议都是我们宝贵的资源,将直接影响到我们课程的改进和创新。我们期待您的反馈,因为您的参与和支持是我们不断前进的动力。感谢您抽出宝贵时间,与我们共同塑造更加精彩的学习旅程!https://www.wjx.cn/vm/YgPfdsJ.aspx# 再次感谢大家宝贵的意见!

New! Stata 搜索神器:lianxh 和 songbl GIF 动图介绍

搜: 推文、数据分享、期刊论文、重现代码 ……

👉 安装:

. ssc install lianxh

. ssc install songbl

👉 使用:

. lianxh DID 倍分法

. songbl all

🍏 关于我们

- 直通车: 👉【百度一下: 连享会】即可直达连享会主页。亦可进一步添加 「知乎」,「b 站」,「面板数据」,「公开课」 等关键词细化搜索。