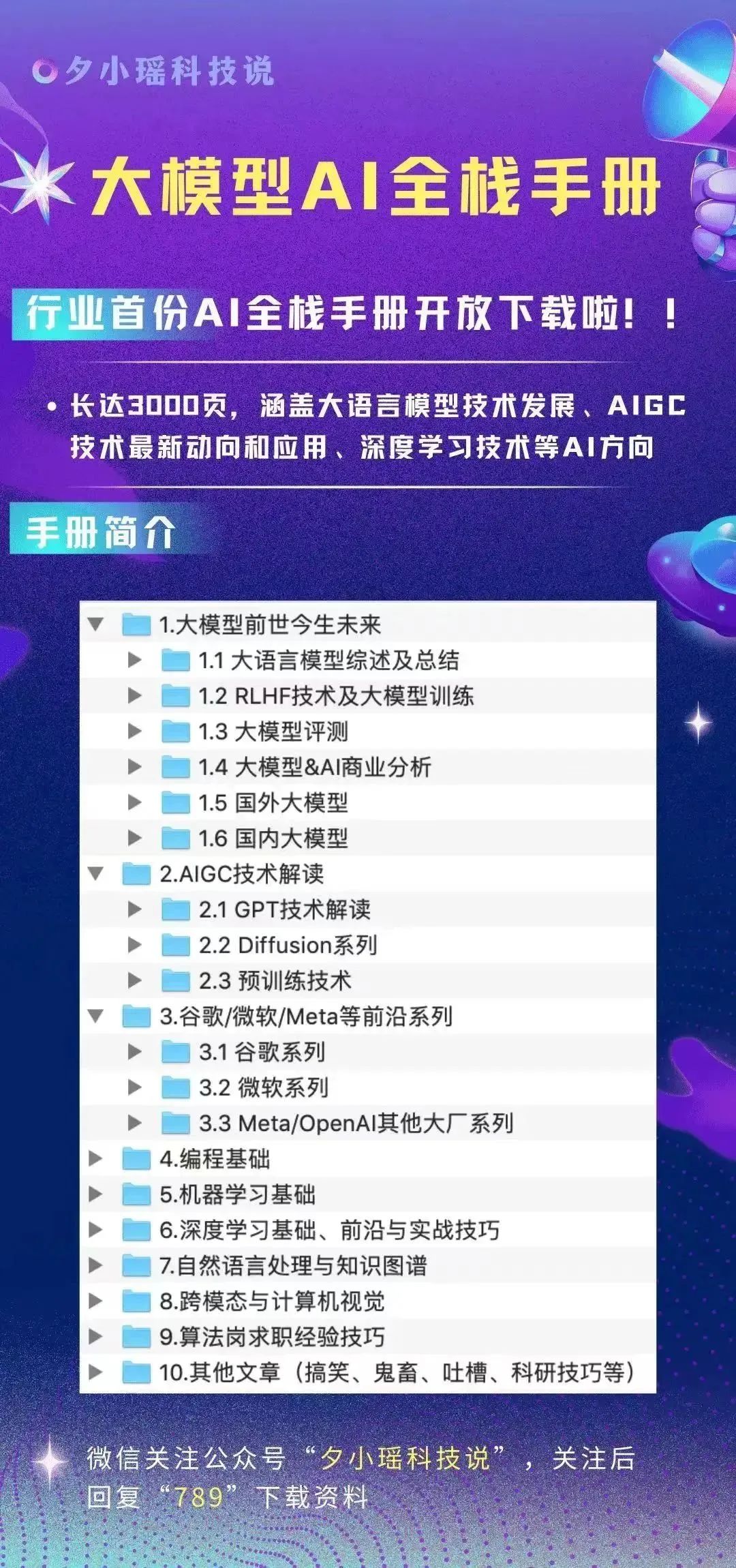

夕小瑶科技说 原创

夕小瑶科技说 原创

作者 | 卖萌酱,王二狗昨日,ChatGPT崩了!

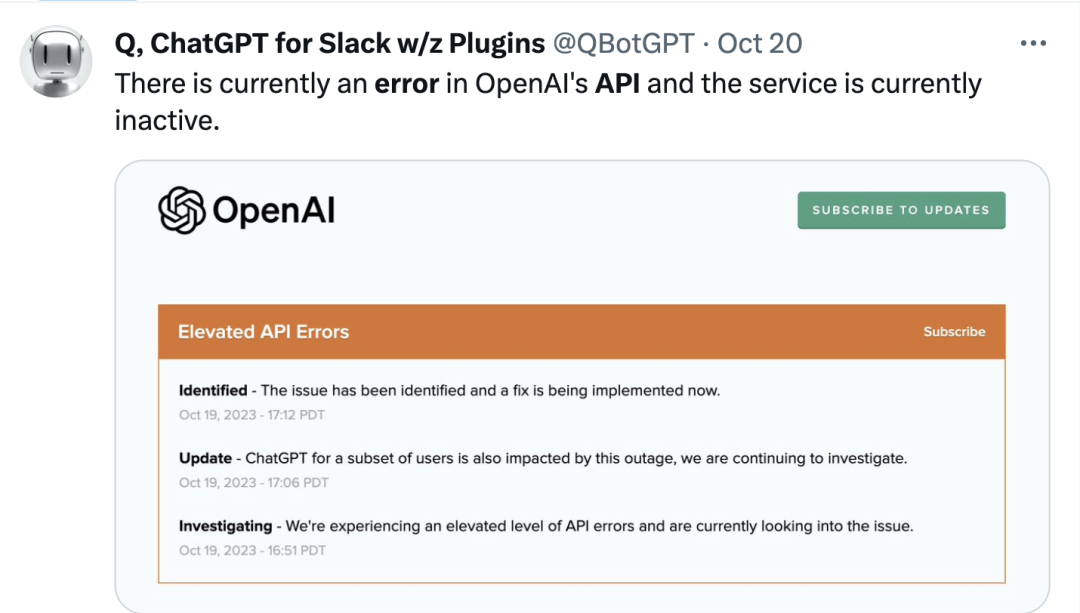

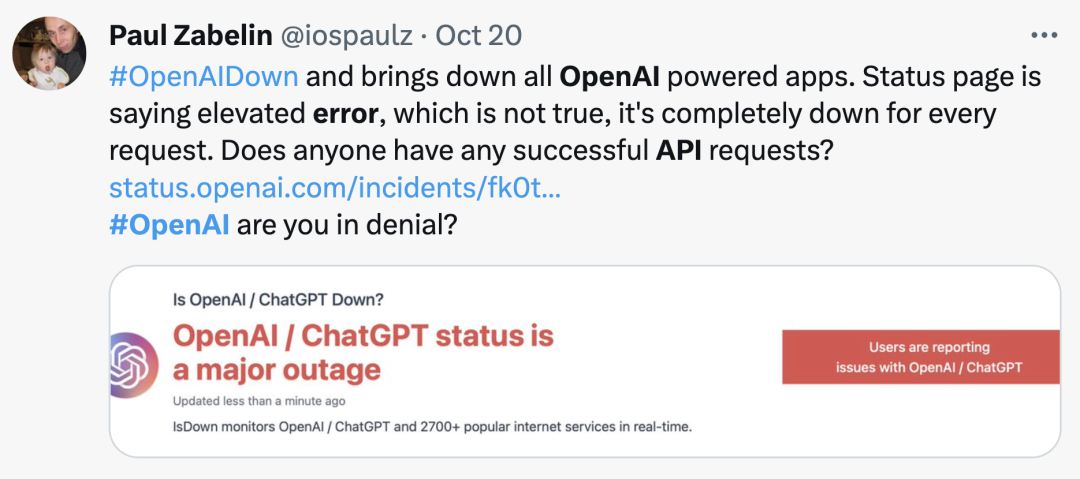

许多人发现无论是 ChatGPT 或是 ChatGPT PLUS 都不能正常工作了。还连带了全球数以万计的依赖ChatGPT API的热门AI应用也纷纷崩溃。

有Twitter网友调侃到,昨日受ChatGPT宕机的影响,全球的生产力下降了50%,打工人一片哀嚎。

更有网友上传了一段视频,真实的写照了受ChatGPT宕机影响的AI公司老板当日精神状态。

如果恰好你是依赖ChatGPT API的应用开发者,昨天ChatGPT的这个HTTP response可能会让你记忆犹新

Hmm...something seems to have gone wrong.

基于昨日的事件,卖萌酱想分别从AI开发者和用户的角度做一些分享。

怎么判断是不是ChatGPT服务崩了?

从用户的角度来看这个问题,可能会觉得有点奇怪。打不开网页了不就是崩了么?

其实不然,OpenAI针对流量反作弊做了一系列复杂的识别机制,并且还在持续不断的上线新的反作弊策略。

不久前,OpenAI大规模封禁亚洲账号的事情还历历在目:

所以用不了ChatGPT,不一定是人家服务器宕机了,也可能是你的账号被封禁或被暂时限制使用了。

有时ChatGPT官网的提示也会模棱两可,让人搞不清楚。其实,OpenAI官方提供了一个宕机事故通报/修复状态同步的一个页面:

http://status.openai.com

如果你打开后,看到的提示是:

All Systems Operational

那就别想了,大概率是你的账号被限制了,人家服务器没事。。。

当然,也有个极小概率的事件——你比OpenAI官方发现事故的时间更早,也就是说,你跑赢了人家官方的监控报警系统。

如果你相信你有这个速度,那就过一个小时再回来看看,让自己彻底死心。

总之,大家可以把上面这个页面收藏下来,或者订阅openai官方推送(但亲测订阅有时收不到邮件)。会对于判断服务是不是真的崩溃挺有帮助的。

科普:ChatGPT官网和ChatGPT API是两套系统

有时你可能会奇怪——

明明ChatGPT官网能用,但是一众用到ChatGPT API的应用却挂掉了;

或者反过来,ChatGPT官网挂了,但是一众ChatGPT API的应用还好好的。

这是因为OpenAI自家的官网ToC服务和API服务是不同的运维体系。甚至同样是API服务,你在微软Azure上调用和在ChatGPT官方平台上调用也会不一样。

具体内部分了几层,卖萌酱不得而知。总之,官网和API并不是一套系统,所以不能得出“官网好使就一定服务器没崩的结论”。

警示1:不要把鸡蛋放在同一个篮子里

这句话既是对普通用户说的,也是对AI应用开发者说的。

如果你是一个日常工作重度依赖ChatGPT的用户(常见于码农、文字工作者),离开ChatGPT会导致生产力大幅下降,那么建议你同时准备几个先进大模型厂商的账号。

卖萌酱自己测试下来,跟GPT4.0能力最接近的大模型是Claude2和文心一言4.0(暂未公测)。作为普通用户,可以考虑做个planB。

如果你是AI应用开发者,那你更要重视这个问题。

大模型厂商的API服务崩了,你可能没得选,你一顿“王德发”之后,还是要乖乖去用大模型厂商的API。

根据卖萌酱了解,绝大部分AI应用公司都没有大模型研发和运维能力:)

因此,如果你没有模型自研能力,重度依赖API,那么一定不要把自己的业务都交给同一家大模型厂商的API来做处理,大模型厂商不会为你的用户流失和经济损失负责,你需要有灾难预见的能力。

另外,在选择API的时候,也不要只关注模型效果,还要关注API的响应/生成速度和稳定性。

一般来说,像百度、阿里这类有10亿规模流量冲击经验的公司,会有更高的系统效率和系统稳定性的工程意识和优化经验,理论上来说会更稳定些。

总之一句话,鸡蛋不要放在同一个篮子里。

警示2:大模型&应用厂商要重视系统稳定性

昨天,有个朋友打电话问卖萌酱——

ChatGPT服务崩了,一群用户找上门了,我们要赶紧切换一家厂商的API兜底,哪家靠谱?国内外都行!

卖萌酱问,啥叫靠谱,效果层面打平?

朋友:效果差不多就行,我们这个流量很大,核心关注点是找个能抗住并发的API,要求能快速接入,要求服务稳定!

国内所谓的百模大战,更多比拼的是大模型的效果。

这就出现了一些比较奇怪的现象——

有些大模型,虽然效果很好,榜单排名靠前,但是响应速度可以慢到一秒一个字,一个机器翻译任务能跑10分钟;

有些大模型,虽然榜单排名低,但是响应速度非常快又服务稳定,效果虽然不是第一但是够用;

有些大模型,模型效果和响应速度都不错,但发几十个request就能有一个丢包或返回异常。

如果你是应用厂商老板,你会选择用哪个?

因此,对大模型厂商来说,在各个大模型效果没有拉开显著差距的情况下(或者厂商以为拉开了显著差距,但其实下游应用可能对这个差距不敏感),其实响应速度和稳定性才是成熟的下游应用厂商更加关注的指标。如果效果够用,速度、稳定性够用,那么就是拼价格了。

对于应用厂商来说,更要关注系统稳定性,跟用户/客户建立信任不容易,但摧毁信任,可能只需要一两次系统崩溃:)

最后,简单总结一下

ChatGPT虽好,可不要贪杯哦~